2. 玉林师范学院广西高校复杂系统优化与大数据处理重点实验室,广西 玉林 537000;

3. 玉林师范学院教育技术中心,广西 玉林 537000

2. Guangxi Universities Key Lab of Complex System Optimization and Big Data Processing, Yulin Normal University, Yulin, Guangxi, 537000, China;

3. Educational Technology Center, Yulin Normal University, Yulin, Guangxi, 537000, China

【研究意义】手机、平板等非专业照相设备的像素受到网络传输和拍摄距离的限制,导致大量手机图片或卫星影像等被人为压缩并降低画质。如今高分辨率显示屏幕在家庭和移动设备上已经普及,因此需要采用超分辨率技术对图像进行复原,提高清晰度,满足用户需求。【前人研究进展】图像超分辨率(Super-resolution, SR)处理技术是指根据一幅或者多幅低分辨率图像(Low-resolution, LR)来重建高分辨率高质量图像(High-resolution, HR)的技术。目前超分辨率技术主要分为两类:一是基于重建的超分辨率方法,利用多张图像的丰富信息,图像间的相同异或信息以及图像的先验知识进行重建,例如邻域像素重复技术和双三次图像插值技术(Bicubic)等,修复效果不佳。二是基于学习的超分辨率方法,目前用于单幅图像超分辨率的最先进方法大多是基于样本学习的。这些方法主要利用相同图像的内部相似性,或外部低和高分辨率的样本学习映射函数。基于样本的外部方法通常提供有大量丰富样本,但是受到有效紧凑建模数据困难的挑战[1]。随着深度学习在机器学习的多个领域取得显著的效果,许多基于深度卷积神经网络的超分辨率修复算法已经被广泛采用并取得了最佳效果。卷积神经网络被广泛应用于自然图像去噪,Dong等[2]已经证明利用卷积神经网络可以用于学习LR到HR的映射函数,可以实现或多或少的消除噪声,其中比较成功的典型算法是Super Resolution Convolutional Neural Network(SRCNN)算法。Kim等[3]提出了一种利用20层的残差卷积网络进行学习预测的方法,采用比较大的学习率参数大幅提高训练速度,峰值信噪比(Peak Signal to Noise Ratio, PSNR)实验结果接近历史最好效果。Johnson等[4]从人类视觉感知的角度思考,提出了一种基于感知损失函数的修复低分辨率视频图像方法,取得很好的视觉效果。改善图像光照补偿算法的效果, 提高图像预处理的质,胡伟平、Shi等[5-6]提出了亚像素卷积层(Sub-pixel convolution)的概念,通过在卷积神经网络的最后一层采用亚像素卷积层进行额外的超分辨率计算,获得很好的复原效果,并成功地用于超分辨率图像复原。【本研究切入点】 PSNR是评价图像的客观标准,是最普遍、最广泛使用于评鉴画质的客观量测法,特别是在超分辨率修复领域,常常针对PSNR进行损失函数(PSNR/MSE loss funtion)设计,大部分修复算法都在追求最高的PSNR数据。但其具有局限性,许多实验结果都显示,PSNR的分数无法和人眼看到的视觉品质完全一致,有可能PSNR较高者看起来反而比PSNR较低者模糊。这是因为人眼的视觉对于误差的敏感度并不是绝对的,其感知结果会受到许多因素影响而产生变化,例如:人眼对空间频率较低的对比差异敏感度较高;人眼对亮度对比差异的敏感度较色度高;人眼对一个区域的感知结果会受到其周围邻近区域的影响。【拟解决的关键问题】参考Johnson等[4]的方法,考虑图像间的峰值、纹理、光照等人眼感知的差异,采用亚像素卷积层替换常用的反卷积层作为上采样层,缓解图像放大后的棋盘效应(Checkerboard artifacts),设计合理的深度卷积神经网络,采用基于视觉感知的损失函数进行训练学习,实现对放大两倍的图像进行超分辨率修复,并达到优秀视觉效果。

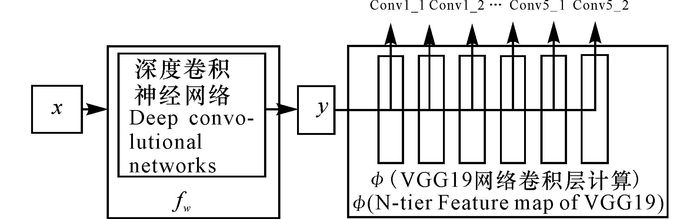

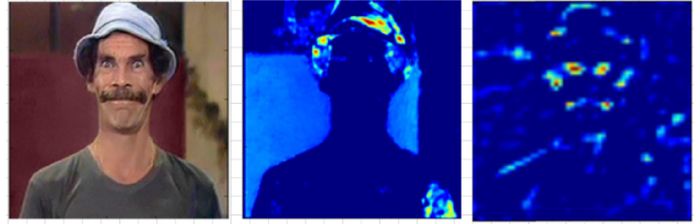

1 模型设计 1.1 深度学习模型本研究设计的深度学习模型由两部分组成(图 1),一是学习LR到HR映射函数的深度卷积神经网络fw,其中W(weights)是fw所有神经元的最优权值;二是采用由牛津视觉几何组(Visual Geometry Group,VGG)开发的卷积神经网络结构VGG19网络模型φ,用于计算损失函数。该模型通过卷积层提取不同层的卷积特征(Feature map),可以表达人类对图像的视觉感知情况(图 2)。利用卷积特征计算修复后预测图像和目标高分辨率图像的视觉感知对比损失情况,根据不同卷积层的特征图可以定义一系列的损失函数l1, l2, ……, lk。假设一幅低分辨率图像x通过深层卷积神经网络fw计算得到超分辨率输出图像y,则定义y=fw(x),每个损失函数计算高分辨率预测图像y和目标高分辨率图像

|

Conv1_n为VGG19网络模型第n层的卷积特征 Conv1_n is N-tier Feature map of VGG19 图 1 网络模型 Fig.1 Architecture of Network |

|

图 2 VGG模型分层提取图像特征 Fig.2 Feature maps of VGG Network |

| ${{W}^{*}}=\text{arg}~\underset{W}{\mathop{\text{min}}}\,~\ {{E}_{x,\text{ }\left\{ {{y}_{i}} \right\}~}}\left[ \sum\limits_{i=1}{{{\lambda }_{i}}}{{\ell }_{i}}~\left( {{f}_{w}}~\left( x \right),{{y}_{i}} \right)~ \right]。$ | (1) |

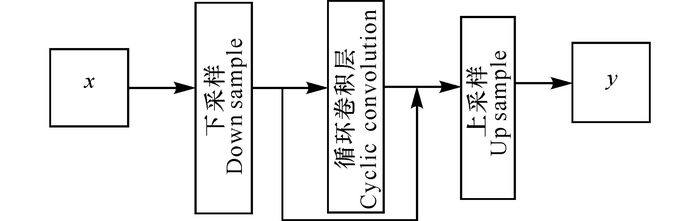

本研究参考Kim等[7]的模型设计思路,设计全卷积层的深度神经网络,深层卷积模型如图 3所示。下采样模块采用4×4大小滤波器(filter),步长为2×2的卷积层,循环卷积模块包括8个相同的全卷积层,采用PRelu激活函数,卷积核的数量都为128个,滤波器大小为3×3,步长为1×1,外围边缘(padding)为1。上采样模块由一个卷积层和一个放大两倍图像尺寸的亚像素卷积层组成,其中卷积层的卷积核的数量为512,滤波器大小为3×3,步长为1×1。如果需要训练输出2倍超分辨率目标图像,则上采样模块数量×2;需要训练4倍目标图像,则上采样模块数量×3, 以此类推。上采样模块连接一个滤波器大小为7×7,步长为3×3,卷积核的数量为3,padding为3×3的卷积层,最终输出放大2倍或者4倍的目标预测图像。

|

x为输入图像,y为输出图像 x is the input image, y is the output image 图 3 深层卷积神经模型 Fig.3 Deep CNN Network |

与传统的基于像素级别损失函数的训练过程不同,针对人眼对图像高频信号更为敏感的特征,参考Gatys等[8]的方法,本研究定义了基于VGG19神经网络模型的VGG损失函数,VGG19模型被设计用于预测图片的类别,采用官方提供的VGG19训练数据,把通过神经网络fw获得的超分辨率图像ISR和目标高清图像IHR作为VGG19模型的输入图像,易于获得各卷积层的图像特征φ,定义φi, j为VGG19的第j卷积层的特征图,计算均方误差(Mean Squared Error,MSE),最终定义损失函数如公式(2) 所示:

| $\begin{align} & l_{VGG/i,\text{ }j}^{SR}= \\ & \frac{1}{{{W}_{i,\text{ }j}}{{H}_{i,\text{ }j}}}\cdot \sum\limits_{x=1}^{{{W}_{i,\text{ }j}}}{\sum\limits_{y=1}^{{{H}_{i,\text{ }j}}}{{{\left( {{\phi }_{i,\text{ }j}}~{{\left( {{I}^{HR}} \right)}_{x,\text{ }y}}-{{\phi }_{i,\text{ }j}}~{{\left( {{I}^{SR}} \right)}_{x,\text{ }y}}~ \right)}^{2}}}}。\\ \end{align}$ | (2) |

由于噪音信号(图像)相邻信号间不平滑,随机变化较大,通过最小化全变差正则化(Total variation regularization)可以去除噪音,平滑信号。为了缓解生成图像的棋盘效应,增加基于全变差正则化计算的损失函数,具体计算如公式(3) 所示[9]:

| $l_{TV}^{SR}=\frac{1}{{{r}^{2}}WH}\sum\limits_{x=1}^{rW}{\sum\limits_{y=1}^{rH}{\left\| \nabla {{\phi }_{i,\text{ }j}}{{({{I}^{SR}})}_{x,\text{ }y}} \right\|}}\text{。}$ | (3) |

首先将高清图像随机裁剪为256×256大小的HR子图像Y,对HR子图像Y进行缩小50%处理,添加符合标准正态分布的噪点,进行高斯处理,得到“低分辨率”图像X,输入图像X的大小为输出图像Y的1/2。通过学习映射F,能够输入低分辨图像产生最终的高分辨率图像。

为了解决损失函数的最小化问题,训练过程采用Adam优化器,学习率为1e-4,Mini-Batch大小为16。第一次初步训练采用VGG的Conv1_2和Conv2_2卷积层提取特征数据,用损失函数(2) 计算均方误差然后进行梯度下降75个epoch计算最优解。第二次采用VGG的Conv5_2卷积层提取特征数据,把损失函数与一个全变差正则损失函数相加进行辅助计算,训练过程适当增大全变差正则损失函数的权重比例,可以有效地缓解生成图像的棋盘效应,然后进行梯度下降500个epoch进行权值优化。当学习率不断下降以后,梯度下降越来越缓慢,采用梯度剪裁(Clip gradient)可以把全局的梯度二范数限制在一定的范围内,最终得到比较好的训练效果。

2 结果与分析本研究使用谷歌公司最新发布的Open Image图片数据集训练一个×2的模型,该数据集包含约900万张图像,这些图片通过标签注释被分为6 000多类,都具有很高的分辨率。和其他一般图像数据集训练对比,实验证明采用高分辨率图片数据集相比较分辨率较低的图片数据集,能够更有效地避免神经网络预测生成图像的棋盘效应,有更强的鲁棒性。本研究随机从Open Image数据集中裁剪256×256大小的HR子图像200 000张,对训练图像进行高斯模糊和增加噪点,然后缩小50%作为低分辨率输入图像。

本研究评估数据集使用超分辨率研究领域标准评测数据集合Set5[10],Set14[11],BSD100[12],评测标准为PSNR,单位是dB,如公式(4) 所示:

| $\text{PSNR}=10\times \text{lo}{{\text{g}}_{10}}(\frac{{{({{2}^{n}}-1)}^{2}}}{\text{MSE}}),~$ | (4) |

其中,MSE是原图像与处理图像之间均方误差;(2n-1)2的是信号最大值的平方;n是每个采样值的比特数。

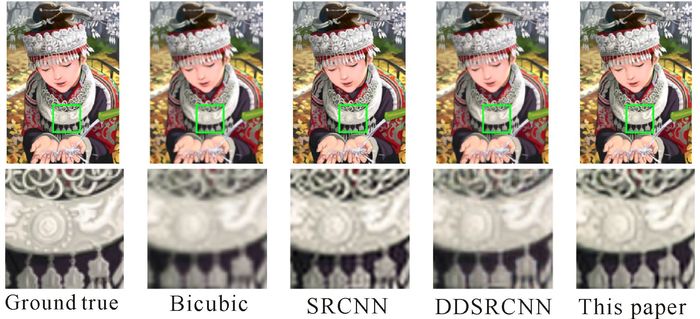

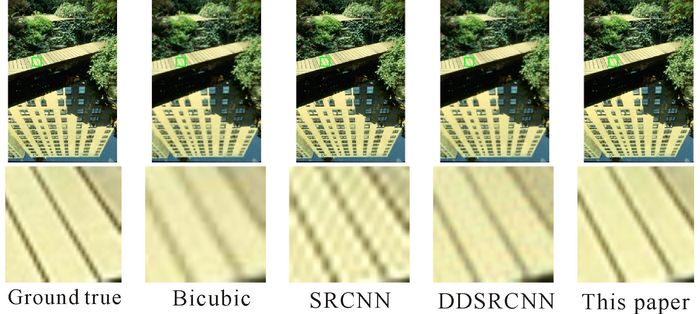

对比Bicubic算法及基于卷积神经网络进行超分辨率复原的SRCNN、ESRCNN(Expanded Super Resolution Convolutional Neural Network)和DDSRCNN(Deep Denoiseing Super Resolution Convolutional Neural Network)模型(其中,ESRCNN为SRCNN的改进模型,增加了更多卷积层),本模型较好保持了和该3个模型相近的PSNR数值(表 1),本研究的超分辨率模型的修复效果清晰度更高,纹理细节更加明显(图 4~5)。

| 表 1 5种超分辨率重建模型的PSNR比较 Table 1 PSNR comparison of five super-resolution reconstruction models |

|

图 4 人物图像超分辨率复原结果 Fig.4 Super-resolution results of figure image |

|

图 5 景物图像超分辨率复原结果 Fig.5 Super-resolution results of scene image |

图 4~5从左到右依次为原始高清图片,Bicubic算法、SRCNN算法和DDRCNN算法处理后的图片,本研究优化算法生成的超分辨率图像。从图中可以看出Bicubic算法处理后的图片是最模糊的,本研究算法的处理效果纹理细节比较清晰。

3 结论本研究设计了一种全部采用卷积层(无池化层)的神经网络模型,结合亚像素卷积层对图像进行上采样,并采用基于视觉感知的损失函数进行训练学习。经验证,该模型可以实现输入不同大小的低分辨率图像而不必多次训练学习不同比例的放大模型,实现对不同放大倍数图像的训练和预测。在保持一定PSNR正确率的前提下,该模型对放大后的超分辨率图像能够恢复更多纹理细节和更佳视觉效果,同时发现输入图像分辨率大小、是否进行模糊预处理等操作,对生成图像的棋盘效应影响很大。下一步工作考虑不仅仅通过VGG模型获得图像特征信息计算损失函数,尝试结合图片的光照、颜色、形状等特征信息共同参与模型的训练和学习,并进一步研究减少训练时间的方法。

| [1] |

DONG C, LOY C C, HE K, et al.Learning a deep convolutional network for image super-resolution[M]//FLEET D, PAJDLA T, SCHIELE B, et al(eds.).Computer Vision-ECCV 2014.ECCV 2014.Cham:Springer, 2014.

|

| [2] |

DONG C, LOY C C, HE K, et al. Image super-resolution using deep convolutional networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(2): 295-307. DOI:10.1109/TPAMI.2015.2439281 |

| [3] |

KIM J, LEE J K, LEE K M, et al.Accurate image super-resolution using very deep convolutional networks[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Las Vegas:NV, United States, 2016.

|

| [4] |

JOHNSON J, ALAHI A, LI F F.Perceptual losses for real-time style transfer and super-resolution[C]//LEIBE B, MATAS J, SEBE N, et al(eds.).Computer Vision-ECCV 2016.Cham:Springer, 2016.

|

| [5] |

胡伟平. 基于对称区块的人脸图像光照补偿算法[J]. 广西科学院学报, 2015, 31(1): 64-68. HU W P. Face illumination compensation algorithm based on symmetrical blocks[J]. Journal Guangxi Academy of Scienses, 2015, 31(1): 64-68. |

| [6] |

SHI W, CABALLERO J, HUSZÁR F, et al.Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas:IEEE, 2016.

|

| [7] |

KIM J, LEE J K, LEE K M.Accurate image super-resolution using very deep convolutional networks[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition.Seattle, WA, USA:IEEE, 2016.

|

| [8] |

GATYS L A, ECKER A S, BETHGE M.Texture synthesis using convolutional neural networks[C]//Proceedings of the 28th International Conferenceon Neural Information Processing Systems.Cambridge, MA, USA:MIT Press, 2015:262-270.

|

| [9] |

ALY H A, DUBOIS E. Image up-sampling using total-variation regularization with a new observation model[J]. IEEE Transactions on Image Processing, 2005, 14(10): 1647-1659. DOI:10.1109/TIP.2005.851684 |

| [10] |

BEVILACQUA M, ROUMY A, GUILLEMOT C, et al.Low-complexity single-image super-resolution based on nonnegative neighborembedding[C]//Proceedings of 2012 British Machine Vision Conference (BMVC).Surrey:BMVC, 2012.

|

| [11] |

ZEYDE R, ELAD M, PROTTER M.On single image scale-up using sparse-representations[M]//BOISSONNAT J D (ed.).Curves and Surfaces.Berlin:Springer, 2010.

|

| [12] |

HUANG J B, SINGH A, AHUJA N.Single image super-resolution from transformed self-exemplars[C]//Proceedings of 2015 IEEE Conference onComputer Vision and Pattern Recognition (CVPR).Boston, MA:IEEE, 2015.

|

| [13] |

MAO X J, SHEN C, YANG Y B.Image restoration using convolutional auto-encoders with symmetric skip connections..https://arxiv.org/pdf/1606.08921v3.

|

2017, Vol. 24

2017, Vol. 24