2. 贵州大学计算机科学与技术学院, 贵州贵阳 550025

2. College of Computer Science and Technology, Guizhou University, Guiyang, Guizhou, 550025, China

在大数据时代,各大法律案件公开网站每天都会发布大量的法律文本。这些文本通常为非结构化文本,不仅专业性较强而且篇幅也较长。从这些文本中提取关键信息对实现“智慧司法”建设具有现实意义,其结果将辅助司法办案人员快速阅卷并厘清案件信息,同时也是知识图谱构建、相似案例推荐、自动量刑建议等一系列任务的重要基础。

实体识别是自然语言处理中的一类基础任务,是从非结构化或半结构化文本提取出用户指定类型的实体,并输出为结构化的信息。在法律文本中主要体现为对案件关键信息如嫌疑人、涉案物品、犯罪事实等的精确抽取。早期常用的方法是基于规则的方法[1],但基于规则的方法存在泛化能力差的缺点。有研究报道使用语法解析树的方法来提高抽取效率[2-4],然而从语法解析的角度进行嵌套命名实体识别很大程度上依赖于标记语料库。在中文语言中,句子的分块或者分词相对较困难,因为此类语言既没有已经切分的句子序列,其词汇也没有明显的边界标记,这使得语法解析方法无法取得较好的性能。

近年来,随着深度学习的发展,自然语言处理相关任务取得了优异的性能。Seo等[5]改进了注意力机制,通过使用双向注意力流机制获得问句感知的上下文表征,从而得到更深层次的上下文语义信息,实现了机器阅读理解模型对答案片段的抽取。Li等[6]针对命名实体识别任务,设计了一个统一的阅读理解框架,能够同时识别出文本中的非嵌套实体及嵌套实体,成为目前有效的实体识别手段之一。然而由于中文司法领域数据的专业性,司法信息抽取领域仍然存在以下问题需要解决。

(a) 缺乏知识的预训练。自从Google于2018年提出BERT[7]预训练语言模型,自然语言处理的各项任务取得了巨大的突破,预训练-微调范式成为自然语言处理任务最常用的手段。在此基础上,Cui等[8]提出了中文任务的RoBERTa-wwm预训练语言模型,采用分词技术构造全词遮蔽任务进行预训练,有效提升了中文任务的性能。该系列模型通过大规模语料预训练学习通用知识,然而司法数据领域性较强,通用领域预训练语言模型(PLM)缺乏专业的司法词法结构信息,尤其是专业性强的实体,通用领域预训练语言模型在识别时准确性较差。

(b) 缺乏充足的标签语义信息。Yang等[9]研究发现现有机器阅读理解模型并不能通过构建问句获得充足的标签语义,提出将标签语义通过语义融合模块增强问句表示的方法。该方法将标签语义注入问句描述中并取得了有效的性能,然而这种方式并没有很好地区分句子中每个字对不同标签的重要性。

(c) 存在噪声数据,导致泛化性差。当处理司法数据时,模型往往会因为字符的缺失或者写错而出现理解偏差,抽取出错误的实体。如给定“赵××于2012年3月15日撬开刘×家进行盗窃2012年3月18日,赵××在菜市场被公安逮捕”段落,提问“找出所有的案发时间?”原有模型会因为段落中“2012年3月18日”之前缺失一个逗号而导致语义理解错误,从而将被捕时间抽取成作案时间。因此,需要改善模型应对噪声数据的能力,提升模型的鲁棒性和泛化性。

针对以上问题,本研究基于RoBERTa-wwm预训练语言模型,使用实体知识注入预训练模型、标签语义感知和对抗训练3种方法进行联合优化。其中实体知识注入预训练模型通过聚合在司法语料中多次出现的实体构建司法领域词典,将专业性较强的实体知识注入RoBERTa-wwm预训练语言模型中进行预训练,这种预训练方式能够将司法标签语义注入模型中,有效地学习司法领域的相关知识。标签语义感知通过自注意力机制区分句子中不同字对不同标签的重要性,将实体标签信息融合到句子中。最后,对抗训练阶段借助快速梯度算法(Fast Gradient Method,FGM) [10]提升模型的鲁棒性和泛化能力。

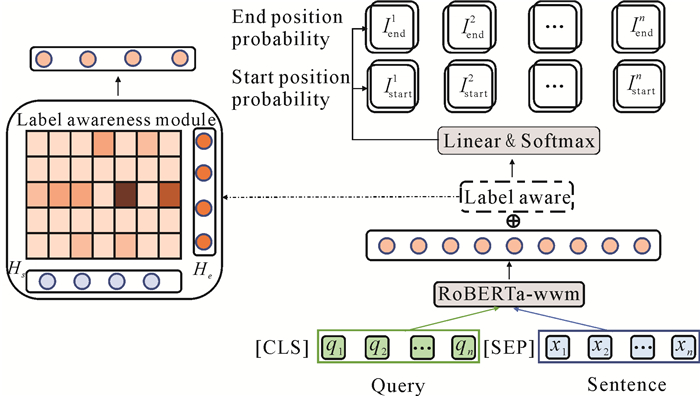

1 策略构建 1.1 基于机器阅读理解的司法信息抽取模型构建机器阅读理解模型给出的一个问句Query,通过自注意力机制从文本中提取答案实体所在的开始位置和结束位置,图 1即为基于机器阅读理解的司法信息抽取模型。

|

| 图 1 基于RoBERTa-wwm的机器阅读理解模型 Fig. 1 Machine reading comprehension model based on RoBERTa-wwm |

1.1.1 模型主干

给出问句Query={q1, q2, …, qn}及长度为n的序列X={x1, x2, …, xn},目标从X中提取实体的xstart, end及其标签y。将X与Query组合起来作为RoBERTa-wwm预训练语言模型的输入序列S:{[CLS], q1, q2, …, qn, [SEP], x1, x2, …, xn},其中[CLS]用于标识整个输入的语义,[SEP]用于分割问句和句子的字符输入。经过公式(1)输出一个上下文句子表示ES,

| $ E_S=\operatorname{RoBERTa-wwm}(S), $ | (1) |

其中,

对上下文矩阵ES分别使用两个二分类器, 预测某个下标是否为start或end的概率,具体操作如公式(2)、公式(3)所示:

| $ \begin{aligned} P_{\text {start }}=\operatorname{softmax}\left(E_S \cdot T_{\text {start }}\right) \in \mathbb{R}^{n \times 2}, \end{aligned} $ | (2) |

| $ P_{\text {end }}=\operatorname{softmax}\left(E_S \cdot T_{\text {end }}\right) \in \mathbb{R}^{n \times 2}, $ | (3) |

其中,Pstart表示预测下标为start的概率,Pend表示预测下标为end的概率,Tstart和Tend为学习参数。

然而在上下文X中可能有多个同类实体,即有多个start和end,存在重叠的情况。通过就近原则匹配start和end显然是不合理的,因此,采用公式(4)、公式(5)解决多个同类实体重叠问题:

| $ {{\hat I}_{{\rm{start }}}} = \left\{ {i\mid {\mathop{\rm argmax}\nolimits} \left( {P_{{\rm{start }}}^{(i)}} \right) = 1, i = 1, \cdots , n} \right\}, $ | (4) |

| $ {\hat I}_{\mathrm{end}}=\left\{i \mid \operatorname{argmax}\left(P_{\mathrm{end}}^{(i)}\right)=1, i=1, \cdots, n\right\}, $ | (5) |

其中,Pstart(i)的每一行表示在给定查询的情况下,每个索引作为实体起始位置的概率分布,Pend(i)的每一行表示在给定查询的情况下,每个索引作为实体结束位置的概率分布。为解决重叠start与end匹配问题,使用argmax函数作用于输出概率矩阵每行的Pstart和Pend,从而获得最大概率的实体开始位置和结束位置的组合。

1.1.3 模型训练训练时,X会与两组标签序列Ystart和Yend配对,Ystart和Yend的长度均为n,分别表示每个令牌(token)xi是任何实体起始位置或结束位置的真实标签。因此,针对起始位置和结束位置的预测,损失表示为

| $ \begin{aligned} l_{\text {strat }}=\operatorname{CE}\left(P_{\text {start }}, Y_{\text {start }}\right), \end{aligned} $ | (6) |

| $ l_{\text {end }}=\operatorname{CE}\left(P_{\text {end }}, Y_{\text {end }}\right) 。$ | (7) |

则整个跨度(span)的损失表示为

| $ l_{\text {span }}=\mathrm{CE}\left(P_{\text {start , end }}, Y_{\text {start, end }}\right), $ | (8) |

整体的训练目标为最小化公式(9):

| $ l=\alpha l_{\text {strat }}+\beta l_{\text {end }}+\gamma l_{\text {span }} \text {, } $ | (9) |

其中CE表示交叉熵损失函数(CrossEntropy loss),α, β, γ∈[0, 1]是超参数,用于控制训练时总体的损失,这3种损失以端到端的方式联合进行训练,并在RoBERTa-wwm预训练语言模型中共享嵌入(embedding)层参数。

1.2 标签语义感知向量化表示机制 1.2.1 编码器标签向量化表示:给定一个实体标签类型ei和实体类型集E中的n个标记,利用RoBERTa-wwm将实体标签编码为向量化表示hei。向量化表示hei如下所示:

| $ H_{e_i}=\operatorname{RoBERTa}-\mathrm{wwm}\left(e_i\right) \text {, } $ | (10) |

| $\begin{aligned} h_{e_i}=\operatorname{sum}\left(H_{e_i}\right), \end{aligned} $ | (11) |

其中

| $ H_E=\operatorname{concat}\left(h_{e_1}, h_{e_2}, \cdots, h_{e_{|E|}}\right) \text {, } $ | (12) |

其中

利用公式(1)获得句子表示ES之后,进一步使用标签语义感知模块将标签语义信息融合到句子表示中。

在标签感知模块(图 1中Label aware的展开图)中,可以利用标签信息来丰富给定句子中每个token的信息,这将有助于实体抽取。该模块利用自注意力机制[11]计算标签感知注意力权重Attlabel,该权重表示给定句子中每个token嵌入与标签嵌入之间的相关性,然后得到HEA。

| $ Q=W_Q E_S, $ | (13) |

| $ K=W_k H_S, $ | (14) |

| $ \operatorname{Att}_{\text {label }}=\operatorname{softmax}\left(\frac{Q K^{\mathrm{T}}}{\sqrt{d_k}}\right), $ | (15) |

| $ H_{E A}=\mathrm{Att}_{\text {label }} H_E, $ | (16) |

其中Q、K均为权重矩阵,由ES经线性变换计算得到,

然后,合并ES、HEA得到Hs_k:

| $ \left(H_{s_{-} k}\right)^{\mathrm{T}}=\operatorname{concat}\left(\left(H_S\right)^{\mathrm{T}}, \left(H_{E A}\right)^{\mathrm{T}}\right), $ | (17) |

其中,

本研究使用FGM对模型进行对抗训练。对抗训练的本质是挑选一个能使得模型产生更大损失的扰动量作为攻击,然后将最大的扰动量添加到输入样本,朝着最小化含有扰动的损失方向更新参数[12]。对抗训练算法之间的差别在于如何计算扰动值。在FGM算法中,根据embedding当前的梯度计算扰动值,即

| $\gamma_{\mathrm{adv}}=\varepsilon \nabla_x L(x, y ; \hat{\theta}) /\left\|\nabla_x L(x, y ; \hat{\theta})\right\|_2 \text {, } $ | (18) |

其中,γ为当前输入扰动;ε为设置参数,本研究设为1.0;

在每一次训练中,得到最大扰动γadv的过程类似于添加L2正则化[13]。将得到的扰动注入词嵌入层的参数中,注入扰动后使用原有样本和标签计算扰动损失,与原有的真实损失一同对模型参数进行优化。

1.4 基于实体知识注入的预训练语言模型研究表明,预训练语言模型(PLM)可以通过大规模语料库进行自监督预训练来获取知识[14-16],然后将所学知识编码到其模型参数中。然而,由于司法词汇专业性较强,现有PLM模型对于那些专业性较强的实体知识难以识别。为了使预训练任务更贴近下游任务且融合更多的中文语义信息,本研究使用RoBERTa-wwm预训练语言模型结合司法领域词典进行领域预训练。首先,爬取网上公开的、与本次任务相同的盗窃起诉书1万篇,经过正则清洗手段构建与2021年中国法律智能评测(CAIL2021)数据相同结构的司法案件语料。然后,聚合在司法语料中多次出现的实体并构建司法领域词典。最后,使用词典辅助RoBERTa-wwm预训练语言模型进行全词遮蔽(MASK),MASK样例如表 1所示。在该策略中,将实体当成一个统一的单元,相较于BERT基于字的MASK,这个单元中的所有实体在训练时统一被MASK,以此向模型注入实体的语义信息。模型可以学习到潜在的知识依赖以及更长的语义依赖来让其更具有泛化性。

| 说明Explanation | 样例Example |

| Original text | 嫌疑人使用钢管撬开窗户盗窃 |

| Word segmentation text | 嫌疑人使用钢管撬开窗户盗窃 |

| Whole word MASK | 嫌疑人使用[MASK][MASK]撬开窗户盗窃 |

2 实验设置 2.1 数据集

本实验主要建立在CAIL2021司法信息抽取赛道发布的数据集上,该赛事开源了一阶段和二阶段两个数据集,本研究将其合并。实验数据主要来源于网络公开的若干罪名起诉意见书,包括犯罪嫌疑人、受害人、作案工具、被盗物品、被盗货币、物品价值、盗窃获利、时间、地点和组织机构等10类相关业务实体。考虑到多类罪名案件交叉的复杂性,该数据集仅涉及盗窃罪名相关信息的抽取。将数据集划分为训练集、验证集和测试集,三者间的比例为8∶1∶1。CAIL2021数据集分布如表 2所示。

| 实体类别(含义) Entity category (meaning) |

数据集Dataset | ||

| 训练集 Training set |

验证集 Validation set |

测试集 Test set |

|

| NHCS (Criminal suspect) | 7 569 | 907 | 922 |

| NHVI (Victim) | 3 564 | 414 | 429 |

| NCSM (Stolen currency) | 1 069 | 139 | 125 |

| NCGV (Value of goods) | 2 421 | 287 | 329 |

| NCSP (Stealing profit) | 555 | 54 | 58 |

| NASI (Stolen items) | 6 647 | 830 | 859 |

| NATS (Criminal tools) | 804 | 81 | 144 |

| NT (Time) | 3 195 | 371 | 425 |

| NS (Place) | 4 068 | 478 | 551 |

| NO (Organization) | 932 | 97 | 123 |

2.2 问句构建

MRC模型性能依赖于问句的构建质量。针对这个特点,深入研究CAIL2021司法信息抽取赛道的数据集,并参考司法案件分析相关文献,通过聚合与类别标签属性相关的案件要素,有针对性地对有关标签构建司法知识问句,如表 3所示。

| 实体类别Entity category | 问句构建Question construction |

| Criminal suspect | Find out all criminal suspect |

| Victim | Find all the victims |

| Stolen currency | Find out all stolen currencies, such as cash, RMB, Vietnamese dong, money, Hong Kong dollars, coins, etc |

| Value of goods | Find out the value of all items, such as yuan, etc |

| Stealing profit | Find out all the stolen profits, such as yuan, etc |

| Stolen items | Find out all stolen items, such as electric cars, mobile phones, cars, motorcycles, etc |

| Criminal tools | Find out all the crime tools, such as steel pipes, knives, etc |

| Time | Find out all the time of the crime, including calendar time (year, month, day, etc.) and non calendar time (morning, afternoon, evening, morning, etc.) |

| Place | Find out all locations, such as administrative district name, street name, community name, building number, floor number, landmark address or natural landscape.In addition, include location indications, such as "in front of the house" or "behind the building" |

| Organization | Find out all organizations, including companies, government parties, schools, governments, news organizations, etc |

2.3 评价指标

采用信息抽取领域常用的精确率(Precision,P)、召回率(Recall,R)及F1得分作为评价指标,计算如下:

| $ P=\frac{\text { 识别正确的命名实体个数 }}{\text { 识别出的命名实体个数 }} \times 100 \% \text {, } $ | (19) |

| $ R=\frac{\text { 识别正确的命名实体个数 }}{\text { 样本中的所有命名实体个数 }} \times 100 \% \text {, } $ | (20) |

| $F 1=\frac{2 \times P \times R}{P+R} \times 100 \% 。$ | (21) |

本研究模型是基于RoBERTa-wwm预训练语言模型的MRC模型,输入RoBERTa-wwm预训练语言模型的最大句子长度为512,学习率设置为2e-5,优化器采用AdamW,权重衰减系数设置为0.01,Dropout设置为0.01,单批次大小设置为32,所有实验都在一张40 G的DGX-A100显卡上迭代训练15轮。

3 实验结果与分析 3.1 实体知识注入预训练模型对模型的影响表 4对比了有无实体知识注入进行预训练对模型性能的影响结果。从表 4中可以看出,在司法领域预训练时注入实体知识信息,相较于原始模型的F1得分提高了1.57%,同时也证明了将预训练任务迁移到司法领域上继续预训练可以进一步提升模型的效果。

| 模型 Model |

数据集 Dataset |

精确率(%) Precision (%) |

召回率(%) Recall (%) |

F1得分(%) F1-score (%) |

| RoBERTa-wwm (No entity knowledge injection) | Validation set | 93.22 | 94.01 | 93.61 |

| Test set | 93.34 | 93.92 | 93.63 | |

| RoBERTa-wwm (Entity knowledge injection) | Validation set | 94.57 | 95.63 | 95.10 |

| Test set | 94.76 | 95.65 | 95.20 |

3.2 标签语义嵌入对模型性能的影响

通过自注意力机制计算原始文本与标签语义之间的相关性,将标签语义嵌入模型中来获取充足的标签语义信息,表 5在使用3.1节预训练的编码器RoBERTa-wwm+pretrain基础上对比了有无标签语义嵌入对模型性能的影响。由于RoBERTa-wwm预训练语言模型具备丰富的语义知识,表 5的F1值虽然有所提升但是提升不明显。因此,为进一步验证有无标签语义嵌入对模型性能的影响,使用Word2Vec和Bi-LSTM替换掉RoBERTa-wwm预训练语言模型,并进行相关显著性实验(表 6)。本研究提出的标签语义嵌入机制通过自注意力机制区分不同实体类别标签对句子中每个词语的重要性,将标签语义信息融入句子嵌入中,模型性能得以提升,在验证集和测试集上F1值分别提高0.23%和0.30%,显著性实验F1值分别提升5.61%和5.42%,证明为模型添加更多有效的标签语义能够帮助其进一步提升性能。

| 模型 Model |

数据集 Dataset |

精确率(%) Precision (%) |

召回率(%) Recall (%) |

F1得分(%) F1-score (%) |

| Tagless knowledge embedding (RoBERTa-wwm +pretrain) |

Validation set | 94.57 | 95.63 | 95.10 |

| Test set | 94.76 | 95.65 | 95.20 | |

| Tagged knowledge embedding (RoBERTa-wwm +pretrain) |

Validation set | 94.89 | 95.78 | 95.33 |

| Test set | 95.13 | 95.88 | 95.50 |

| 模型 Model |

数据集 Dataset |

精确率(%) Precision (%) |

召回率(%) Recall (%) |

F1得分(%) F1-score (%) |

| Tagless knowledge embedding (Word2Vec+Bi-LSTM) |

Validation set | 59.34 | 61.19 | 60.25 |

| Test set | 58.89 | 60.96 | 59.91 | |

| Tagged knowledge embedding (Word2Vec+Bi-LSTM) |

Validation set | 65.52 | 66.20 | 65.86 |

| Test set | 64.78 | 65.88 | 65.33 |

3.3 对抗训练对模型的影响

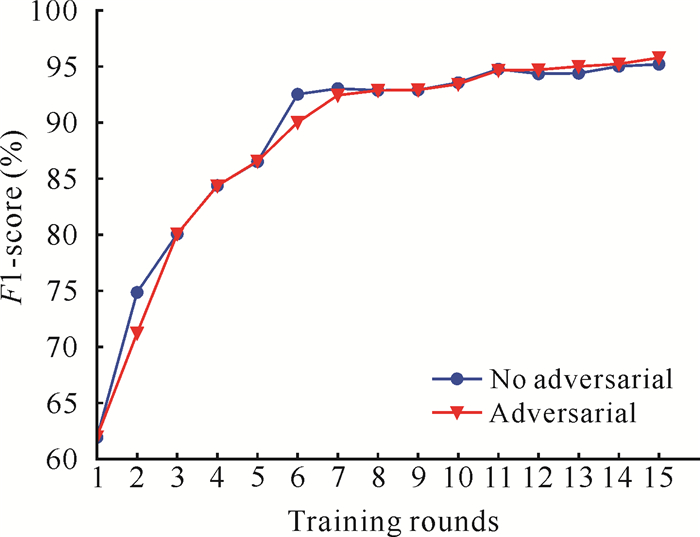

对抗训练通过对嵌入层矩阵添加扰动来增强模型在对抗样本下的表现,提升模型整体的鲁棒性和泛化能力。为验证对抗训练对模型的影响,在3.1节的预训练权重基础上,对比了训练阶段有无对抗训练的模型性能。从表 7的实验结果可以看出,在3.2节的实验基础上,验证集和测试集上的F1值分别提高了0.73%和0.58%。这说明在模型训练阶段增加对抗训练可以在一定程度上提升模型的性能。如图 2所示,模型在无对抗训练的第7轮和第11轮时性能发生抖动,在加入对抗训练后,模型训练稳定,这表明加入对抗训练能提高模型训练的稳定性,增强模型的鲁棒性和泛化能力。

| 数据集 Dataset |

F1得分(%) F1-score (%) | |

| 无对抗 No adversarial |

有对抗 Adversarial |

|

| Validation set | 95.10 | 95.83 |

| Test set | 95.20 | 95.78 |

|

| 图 2 对抗训练对训练稳定性的影响 Fig. 2 Effect of adversarial training on training stability |

3.4 模型对比实验

为进一步验证联合优化策略的有效性,本研究与多种机器阅读理解模型及预训练模型进行对比实验。

① BiADF[5]:使用双向注意力流机制来获得问句感知的上下文表示,对上下文和问句之间的复杂交互关系进行建模。

② BERT-MRC[6]:通过构建问句获得实体知识,以阅读理解的方式对实体进行抽取。

③ LEAR[9]:BERT-MRC的一种改进模型,将待抽取的实体标签描述为查询语句,与原始文本进行拼接,然后基于BERT对实体进行抽取,通过这种方式让模型学习实体标签本身的语义信息。

④ BERT[7]:一种预训练语言模型,使用Transformer架构的编码器,用于学习在给定上下文的情况下词的向量化表示。

⑤ RoBERTa-wwm[8]:一种使用全词MASK的中文预训练语言模型,并且使用了更多的预训练数据。

相关性能指标如表 8所示。从表 8中可以看出预训练模型的性能远远优于基于BiDAF的机器阅读理解模型,这说明经过大规模数据预训练后的模型可以得到很好的语义表示,通过预训练-微调范式可以有效地提高模型在特定任务上的性能;同时,预训练阶段注入额外的实体知识能够使得预训练模型与外部知识进行交互,从而提升MRC任务的性能。本研究模型基于RoBERTa-wwm预训练语言模型进行设计,采用了多任务联合的机制,相比基线模型有较好的性能表现;进一步使用基于注意力机制的标签知识嵌入机制,将标签知识融合到句子向量化表示中来提高模型的性能,最终模型性能整体提升了2.79%。在实施联合优化策略后,本研究模型在CAIL2021司法信息抽取赛道的数据集上获得了更好的F1值,表明了实体知识注入预训练模型、标签知识嵌入及对抗训练对司法MRC任务有重要的影响,本研究的优化方法可以有效改善模型的性能。

| 模型 Model |

验证集(%) Validation set (%) |

测试集(%) Test set (%) |

| BiDAF | 86.93 | 86.84 |

| BERT | 91.77 | 91.72 |

| RoBERTa-wwm | 92.38 | 92.43 |

| LEAR | 93.39 | 93.38 |

| BERT-MRC | 92.96 | 92.91 |

| Before model optimization | 93.61 | 93.63 |

| After model optimization | 96.47 | 96.42 |

4 结论

本研究针对CAIL2021司法信息抽取赛道的数据集设计了基于RoBERTa-wwm预训练语言模型的司法信息抽取机器阅读理解模型,并联合基于实体知识注入任务预训练、标签知识嵌入机制和对抗训练3种方法对模型进行优化,本研究模型的F1值比基线模型提高了2.79%。为探索更多的优化策略,未来的工作可以从以下3个方面入手:针对司法信息抽取出来的案件信息构建知识图谱, 从而为模型提供更多的知识;增加更多的数据,引入更多的训练方式,对本研究模型进行司法领域预训练;探索引入更多的标签语义提升模型的性能。

| [1] |

RAU L F. Extracting company names from text[C]//The Seventh IEEE Conference on Artificial Intelligence Application. Piscataway, NJ: IEEE, 1991: 29-32.

|

| [2] |

FINKEL J R, MANNING C D. Joint parsing and named entity recognition[C]//Proceedings of Human Language Technologies: the 2009 Annual Conference of the North American Chapter of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2009: 326-334.

|

| [3] |

ZHANG X T, LI D C, WU X H. Parsing named entity as syntactic structure[C]//INTERSPEECH 2014, Fifteenth Annual Conference of the International Speech Communication Association. Singapore: ISCA, 2014: 278-282.

|

| [4] |

JIE Z M, MUIS A O, LU W. Efficient dependencyguided named entity recognition[C]//Proceedings of the Thirty-First AAAI Conference on Artificial Intelligence. Menlo Park, CA: AAAI, 2017: 3457-3465.

|

| [5] |

SEO M J, KEMBHAVI A, FARHADI A, et al. Bi-directional attention flow for machine comprehension[Z/OL]. (2018-06-21)[2022-09-07]. https://arxiv.org/pdf/1611.01603.pdf.

|

| [6] |

LI X Y, FENG J R, MENG Y X, et al. A unified MRC framework for named entity recognition[C]//Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2020: 5849-5859.

|

| [7] |

DEVLIN J, CHANG M W, LEE K, et al. BERT: pre- training of deep bidirectional transformers for language understanding[C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2019, 1: 4171-4186.

|

| [8] |

CUI Y M, CHE W X, LIU T, et al. Pre-training with whole word masking for chinese BERT[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 29: 3504-3514. |

| [9] |

YANG P, CONG X, SUN Z Y, et al. Enhanced language representation with label knowledge for span extraction[C]//Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2021: 4623-4635.

|

| [10] |

MIYATO T, DAI A M, GOODFELLOW I. Adversarial training methods for semi-supervised text classification[Z/OL]. (2017-05-06)[2022-09-08]. https://arxiv.org/pdf/1605.07725v3.pdf.

|

| [11] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach, CA: NIPS, 2017.

|

| [12] |

MADRY A, MAKELOV A, SCHMIDT L, et al. Towards deep learning models resistant to adversarial attacks[Z/OL]. (2019-09-04)[2022-09-14]. https://arxiv.org/pdf/1706.06083.pdf.

|

| [13] |

GOODFELLOW I J, SHLENS J, SZEGEDY C. Explaining and harnessing adversarial examples[Z/OL]. (2015-03-20)[2022-09-14]. https://arxiv.org/pdf/1412.6572.pdf.

|

| [14] |

TENNEY I, XIA P, CHEN B, et al. What do you learn from context? probing for sentence structure in contextualized word representations[Z/OL]. (2019-05-15)[2022-09-15]. https://arxiv.org/pdf/1905.06316.pdf.

|

| [15] |

PETRONI F, ROCKTÄSCHEL T, RIEDEL S, et al. Language models as knowledge bases?[C]//Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP). Stroudsburg, PA: Association for Computational Linguistics, 2019: 2463-2473.

|

| [16] |

ROBERTS A, RAFFEL C, SHAZEER N. How much knowledge can you pack into the parameters of a language model?[C]//Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP). Stroudsburg, PA: Association for Computational Linguistics, 2020: 5418-5426.

|