阿尔茨海默病(Alzheimer′s Disease,AD)是一种常见的神经退行性疾病,俗称老年痴呆[1, 2]。它会导致大脑中神经细胞的退化和死亡,进而影响记忆、思维和行为的能力,也是导致老年人死亡的主要原因之一。目前,尚无治愈AD的方法,进行早期干预是减缓其恶化的有效途径[3],因此对AD的早期诊断极为重要。神经影像学技术如磁共振成像(Magnetic Resonance Imaging,MRI)在AD的早期诊断中发挥着关键作用。由于人工检查神经影像学数据既费力又耗时,机器学习技术已经被广泛应用于神经影像学数据的处理以减轻神经科医生的负担。

在利用机器学习技术对AD进行早期诊断的起步阶段,主要是通过传统的机器学习方法来处理神经影像学数据。例如,随机森林[4]通过随机选择特征子集和样本子集构建多个弱分类器(如决策树),最后集成多个弱分类器的预测(如投票法、平均法等)作为最终分类结果。L1SVM(L1-Support Vector Machine)[5]利用支持向量机(Support Vector Machine,SVM)完成分类任务,并引入L1正则化对重要特征进行选择。近年来,随着机器学习技术的不断发展[6, 7],深度学习方法已经被广泛应用于疾病诊断领域,并因其强大的特征提取能力取得了比传统机器学习方法更好的效果。现有的深度学习方法通常把患者作为节点,并通过K最近邻算法(K-Nearest Neighbors,KNN)[8],根据节点间的相似性构建图结构数据,然后使用图卷积网络(Graph Convolutional Network,GCN)[9]进行特征学习,最后根据学习到的特征嵌入进行疾病诊断。例如IDGCN (Interpretable learning based Dynamic Graph Convolutional Network)[10]在GCN的基础上加入可解释特征学习和动态图学习模块,获得了比传统方法更好的性能,并且能够解释诊断结果与大脑的特定区域之间的关系。DGLCN(Dual-Graph Learning Convolutional Network)[11]使用原始特征矩阵及其转置矩阵分别构建目标图和特征图,并使用它们进行双图学习从而更好地对MRI数据进行特征学习。FSNet[12]使用FGCN(Feature Graph Convolutional Network)和SGCN(Simple Graph Convolutional Network)分别捕捉特征和样本的重要性,并根据重要性信息提取特征嵌入,最后使用特征嵌入进行分类。Multi-Modal GNN(Multi-Modal Graph Neural Network)[13]分别根据MRI和PET(Positron Emission Tomography)数据构建图结构,并通过图融合策略来利用它们之间的互补信息。UNB-GCN(Univariate Neurodegeneration Biomarker Graph Convolutional Network)[14]根据MRI数据的重要区域生成单变量神经退行性生物标志物(Univariate Neurodegeneration Biomarker,UNB),并设计了一个注意力模块使GCN更关注产生重要UNB的脑部区域。

由于不同疾病患者的数量有差异,数据集中往往存在类不平衡问题,现有方法均缺乏对这一问题的考虑。另外,现有方法特征学习的效果依赖于图结构的质量,但在神经系统疾病的早期阶段,患者脑部的病理变化较小,神经影像学数据与正常人极为相似,很难构建出高质量的图结构。因此,本文使用多层感知机(Multilayer Perceptron,MLP)对神经影像学数据进行特征学习与疾病诊断,旨在更有效地使用MRI数据对阿尔茨海默病进行早期诊断。

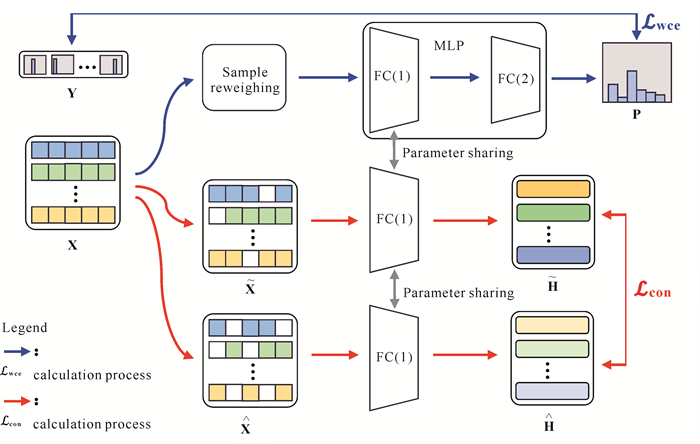

1 方法本文方法包括标签学习(蓝色路径)和对比学习(红色路径)两个部分(图 1)。在标签学习部分,引入加权交叉熵损失来降低类不平衡问题对模型的影响。在对比学习部分,设计监督对比学习来提升模型的特征提取能力。

|

| 图 1 本文所提出算法的整体框架 Fig. 1 Overall framework of the algorithm proposed in this paper |

1.1 模型结构

MLP是一种经典的前馈人工神经网络模型,由输入层、隐藏层和输出层组成,隐藏层和输出层中的每个神经元都与前一层的所有神经元相连接,因此也被称为全连接层(Fully Connected layer,FC)。其中,隐藏层负责对输入数据进行一系列的非线性变换从而实现特征提取,输出层负责根据隐藏层提取的特征嵌入对样本类别进行预测。本文采用两层网络结构的MLP作为预测模型,并将第1层输出的特征嵌入H和第2层输出的预测概率矩阵P表示如下:

| $ \boldsymbol{H}=\boldsymbol{W}^{(1)} \boldsymbol{X}+\boldsymbol{b}^{(1)}, $ | (1) |

| $ \boldsymbol{P}=\operatorname{softmax}\left[\sigma\left(\boldsymbol{W}^{(2)} \boldsymbol{H}+\boldsymbol{b}^{(2)}\right)\right], $ | (2) |

式中,W (i)和b (i)表示第i层的可训练参数,σ表示激活函数(如ReLU、Sigmoid等)。

1.2 加权交叉熵损失交叉熵损失是分类任务中常用的损失函数之一[15, 16],其有效性已经在实践中得到广泛验证。本文将交叉熵损失函数表达如下:

| $ \mathcal{L}_{\mathrm{ce}}=-\sum\limits_{\mathrm{i} \in \mathrm{~T}} \mathrm{y}_{\mathrm{i}} \log p_i, $ | (3) |

式中,T=v1, v2, …, vt, 表示训练数据集; t表示训练样本总数。yi和pi分别表示样本vi的标签和模型对样本vi的预测概率分布。交叉熵损失可以衡量模型输出的概率分布与真实标签之间的差异,当两者相差较大时,交叉熵损失的值会较大,反之则较小。因此,通过最小化交叉熵损失,可以使模型获得对不同类别的区分能力。然而,当数据集中不同类别的样本数量差距较大时,使用交叉熵损失可能会导致模型在训练过程中更关注数量较多的类别而忽略了数量较少的类别,原因是传统的交叉熵损失会公平地看待所有样本。

为解决上述问题,对式(3)进行了一些改进,使其能够为不同类别样本给予不同程度的关注度。具体来说,引入样本重加权策略,使样本数量较少的类别获得更高的权重,而样本数量较多的类别则相反。为此,先计算训练集中每个类别样本的数量:

| $ M_i=\sum\limits_{j=1}^t \mathbb{1} \left(y_j=i\right), $ | (4) |

式中,Mi表示类别i的样本数量;

| $ w_i=1-\frac{M_{y_i}}{t}, $ | (5) |

式中,wi表示样本vi的权重,Myi表示与节点vi类别相同的样本数量。根据式(5),样本的权重将与其同类样本的数量占总样本数量的比例成反比。最终,结合式(3)和式(5),得到加权交叉熵损失

| $ \mathcal{L}_{\mathrm{wce}}=-\sum\limits_{\mathrm{i} \in \mathrm{~T}} w_i \cdot\left(y_i \log p_i\right)。$ | (6) |

式(6)通过为不同类别的样本赋予不同的权重,使得模型在训练中公平地对每个类别进行学习,从而降低类不平衡问题对模型训练的影响,使模型获得更好的泛化能力。

1.3 监督对比损失加权交叉熵损失能够通过最小化模型的预测结果与真实标签之间的差异来使模型从样本标签中学习类别信息。然而,它缺乏对样本间相互关系的学习能力,而学习样本间相互关系往往能够帮助模型更好地捕捉数据的内在结构和关联性,从而获得更高质量的特征嵌入。基于上述思考,本文设计监督对比损失来使模型能够更好地学习样本之间的相互关系。具体来说,为每个样本选择k个正样本和k个负样本,并使其与正样本在嵌入空间中互相靠近,与负样本在嵌入空间中互相远离。

1.3.1 选择正样本为了使模型能够学习到同类样本间的联系,为每个样本选择与其类别相同且特征最为相似的部分样本作为其正样本,并在嵌入空间中使它们互相靠近。具体来说,先将训练集按照不同类别分为多个子集:

| $ \mathrm{C}_i=\left\{v_j \mid \forall j \in(1, n), y_j=i\right\}, $ | (7) |

式中,Ci表示由类别为i的样本组成的集合。接下来,计算每个样本与其余同类样本的特征相似度:

| $ \mathrm{P}_i=\left\{\mathrm{S}_{i j} \mid \forall v_j \in \mathrm{C}_{y_i}\right\}, \text { where } \mathrm{S}_{i j}=\frac{x_i \cdot x_j}{\left|x_i\right|\left|x_j\right|}, $ | (8) |

式中,Pi表示由样本vi与其余同类样本的相似度组成的集合,Sij表示节点vi与vj的相似度,xi和xj分别表示节点vi与vj的特征向量。最后,为每个样本选择k个相似度最高的同类样本作为其正样本:

| $ \operatorname{Pos}_i=\operatorname{top}\left(\mathrm{P}_i, k\right), $ | (9) |

式中,Posi表示为样本vi选择的正样本组成的集合,top (Pi, k)表示从Pi中选取前k个具有最大值的样本。通过减小样本与其正样本在嵌入空间中的距离,模型能够更好地学习到同类样本间的联系,从而提升模型的特征提取能力。

1.3.2 选择负样本在让模型学习同类样本间联系的同时,也需要学习不同类别样本间的差异。因此,本文将为每个样本选择与正样本数量相同的负样本。首先,计算每个样本与非同类样本的特征相似度:

| $ \mathrm{N}_i=\left\{\mathrm{S}_{i j} \mid \forall v_j \notin \mathrm{C}_{y_i}\right\}, $ | (10) |

式中,Ni表示由样本vi与非同类样本的相似度组成的集合。接下来,为了使模型在提升对特征相似的非同类样本区分能力的同时,保持对特征不相似样本的区分能力。为每个样本选择k-1个相似度最高的非同类样本以及一个相似度最低的非同类样本作为负样本:

| $ \mathrm{Neg}_i=\operatorname{top}\left(\mathrm{N}_i, k-1\right)+\operatorname{top}\left(\mathrm{N}_i, -1\right), $ | (11) |

式中,Negi表示为样本vi选择的负样本组成的集合,top (Ni, k-1)表示从Ni中选取前k-1个相似度最高的样本,top (Ni, -1)表示从Ni中选取相似度最低的样本。通过增加样本与其负样本在嵌入空间中的距离,模型能够更好地捕捉到不同类别样本间的差异,使不同类别的样本在嵌入空间中具有更好的分离度,进而提升模型的分类性能。

1.3.3 对比损失加权交叉熵损失会使模型倾向于将同一类别的所有样本具有相似的特征嵌入,即在嵌入空间中属于同一个簇,而对比损失则可能使模型将同一类别的样本映射为多个簇。为了避免两者的优化目标出现冲突,更好地发挥各自的优势,本文考虑通过数据增强获得两组增强特征来计算对比损失,从而使模型间接地对样本间的相互关系进行学习。首先,通过随机掩码策略获得两组增强特征:

| $ \left\{\begin{array}{l} \widetilde{\boldsymbol{X}}=\operatorname{mask}\left(\boldsymbol{X}, \boldsymbol{r}_1\right), \\ \hat{\boldsymbol{X}}=\operatorname{mask}\left(\boldsymbol{X}, r_2\right), \end{array}\right. $ | (12) |

式中,mask (X, r)表示将矩阵X每一行中r %的元素值转变为0。接下来,分别将两组增强特征输入模型,获得模型第一层输出的特征嵌入:

| $ \left\{\begin{array}{l} \widetilde{\boldsymbol{H}}=\boldsymbol{W}^{(1)} \widetilde{\boldsymbol{X}}+\boldsymbol{b}^{(1)}, \\ \hat{\boldsymbol{H}}=\boldsymbol{W}^{(1)} \hat{\boldsymbol{X}}+\boldsymbol{b}^{(1)}, \end{array}\right. $ | (13) |

式中,

| $ \mathrm{d}\left(h_i, h_j\right)=\frac{\widetilde{\boldsymbol{h}}_i \cdot \widetilde{\boldsymbol{h}}_j}{\left|\widetilde{\boldsymbol{h}}_i\right|\left|\widetilde{\boldsymbol{h}}_j\right|}+\frac{\widetilde{\boldsymbol{h}}_i \cdot \hat{\boldsymbol{h}_j}}{\left|\widetilde{\boldsymbol{h}}_i\right|\left|\hat{\boldsymbol{h}}_j\right|}+\frac{\hat{\boldsymbol{h}_i} \cdot \hat{\boldsymbol{h}_j}}{\left|\hat{\boldsymbol{h}}_i\right|\left|\hat{\boldsymbol{h}}_j\right|}, $ | (14) |

式中,

| $ \mathcal{L}_{\text {con }}=\sum\limits_{i \in T}\left[\sum\limits_{v_j \in \operatorname{Pos}_i} \mathrm{~d}\left(h_i, h_j\right)-\sum\limits_{v_j \in \operatorname{Neg}_i} \mathrm{~d}\left(h_i, h_j\right)\right] $ | (15) |

通过最小化

将加权交叉熵损失

| $ \mathcal{L}=\mathcal{L}_{\mathrm{wce}}+\alpha \mathcal{L}_{\mathrm{con}}, $ | (16) |

式中,α表示平衡

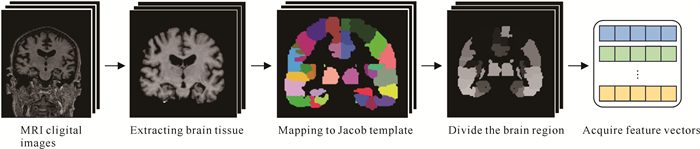

从ADNI数据库下载原始MRI数字图像,并遵循文献[17]中描述的方式进行预处理,具体步骤包括提取脑组织、修正运动和时间、配准、过滤和平滑。在完成对MRI数字图像的预处理后,将其映射到Jacob模板[18]中,从而将大脑划分为93个脑区。最后,提取每个脑区的灰质体积作为特征,这样每个样本(患者)就可以用一个93维的特征向量来表示。数据预处理的具体流程见图 2。

|

| 图 2 从MRI数字图像提取特征向量的预处理流程 Fig. 2 Preprocessing pipeline of extracting feature vectors from MRI digital images |

共处理805位受试者的MRI数字图像,其中包括186名AD患者,393名轻度认知障碍(MCI)患者和226名正常人(对照组,NC)。此外,393名MCI患者又分为226名MCI非转化者(MCIn)和167名MCI转化者(MCIc)。最后,将这些样本分成4个二分类数据集(即AD-NC、NC-MCI、AD-MCI和MCIn-MCIc)进行实验。4个数据集的具体信息见表 1。

| 数据集 Dataset |

样本 Samples |

特征维度 Characteristic dimensions |

| AD-NC | 186∶226 | 93 |

| NC-MCI | 226∶393 | 93 |

| AD-MCI | 186∶393 | 93 |

| MCIn-MCIc | 226∶167 | 93 |

2.2 对比算法

本文使用的对比算法包括1种传统机器学习算法(L1SVM)和5种深度学习算法(GCN、GAT、Transformer、SUGRL、DGLCN)。

L1SVM[5]在SVM的基础上引入L1正则化来过滤掉对分类决策贡献较小的特征。

GCN[9]是一种基于频谱理论的图卷积网络,通过图结构来对节点特征进行邻域聚合的方式学习节点间的相互关系。

GAT(Graph Attention Network)[19]通过注意力机制来计算节点与其邻居之间的重要性权重,并利用这些权重对节点的邻域信息进行加权聚合。

Transformer[20]是一种基于自注意力机制的深度学习模型,通过计算每个特征向量中不同位置之间的相互依赖关系,为每个位置分配注意力权重。

SUGRL(Simple Unsupervised Graph Representation Learning)[21]使用结构信息和领域信息来为节点选择正样本,并通过上界损失限制节点与正样本在特征空间中的距离。

DGLCN[11]为样本构建目标图和特征图,并通过双图来学习样本的目标相关性和特征相关性。

2.3 实验设置在一台4张NVIDIA GeForce RTX 2080 Ti (每张11 GB内存)的服务器上使用PyTorch Geometric(PyG)框架进行实验。参考2.2节中对比算法的相关文献[5][9][11][19-21]来为其设置最优参数,以使其达到最佳结果。由于本实验使用的数据集没有提供预先建立的图结构,因此对于所有需要使用图结构的算法,本文使用K最近邻算法为它们构建图结构,K值统一设置为10。对于所有对比算法,设置最大训练轮次为104轮,预测模型的隐藏层神经元数量为32,优化器为Adam(Adaptive moment estimation)。GCN、GAT以及本文提出方法的学习率均为10-2。SUGRL的学习率为2.5×10-3,权重衰减为5×10-5。Transformer的学习率为2×10-4,权重衰减为10-3,隐藏层神经元数量为256,注意力头数量和编码器的层数均为4。DGLCN的学习率为5×10-3,特征提取器为两层GCN,神经元数量分别为128、64。

通过4种常用指标对所有方法进行评估,包括准确率(ACC)、敏感度(SEN)、特异度(SPE)和ROC曲线下面积(AUC)。对于这些评价指标,更高的数值都意味着更好的性能。为了减少实验结果的随机性,采用5倍交叉验证,并使用不同的随机数种子在4个数据集上对所有方法独立进行了5次交叉验证实验,最后取5个结果的平均值作为最终结果。

2.4 结果分析本文提出的方法与6种对比算法的平均值和相应的标准差见表 2。

| 数据集 Dataset |

指标 Index |

L1SVM | GCN | GAT | Transformer | SUGRL | DGLCN | Proposed |

| AD-NC | ACC | 76.3 (2.1) | 81.5 (1.0) | 81.3 (1.3) | 84.0 (1.4) | 81.6 (0.4) | 86.9 (1.6) | 85.8 (0.7) |

| SEN | 77.5 (1.2) | 84.7 (0.7) | 85.1 (2.1) | 88.1 (2.7) | 84.9 (1.5) | 85.9 (1.6) | 88.8 (1.1) | |

| SPE | 75.1 (2.4) | 77.5 (1.4) | 76.2 (2.0) | 78.9 (1.2) | 81.1 (1.1) | 87.2 (1.7) | 82.1 (1.1) | |

| AUC | 77.6 (1.8) | 88.3 (0.6) | 87.0 (1.2) | 78.4 (3.0) | 88.1 (0.5) | 90.6 (2.5) | 91.3 (0.6) | |

| AD-MCI | ACC | 65.3 (1.8) | 66.1 (1.4) | 65.1 (0.8) | 67.7 (0.6) | 66.5 (0.4) | 68.7 (1.5) | 69.9 (1.2) |

| SEN | 66.4 (1.6) | 73.8 (2.3) | 73.5 (1.7) | 66.0 (1.1) | 66.8 (0.9) | 68.5 (1.6) | 78.0 (2.2) | |

| SPE | 64.2 (3.4) | 51.0 (6.7) | 47.3 (3.6) | 70.5 (2.3) | 72.0 (1.0) | 74.8 (2.4) | 53.0 (2.4) | |

| AUC | 61.4 (2.2) | 69.2 (2.1) | 67.3 (0.6) | 70.9 (0.8) | 71.6 (0.6) | 65.5 (2.8) | 71.8 (1.1) | |

| NC-MCI | ACC | 61.2 (1.4) | 64.2 (1.6) | 61.8 (1.6) | 67.7 (0.6) | 63.5 (1.3) | 67.5 (2.4) | 69.1 (1.0) |

| SEN | 56.8 (1.6) | 64.6 (1.2) | 64.9 (3.2) | 66.0 (1.1) | 65.6 (2.1) | 61.7 (1.5) | 67.2 (1.1) | |

| SPE | 63.5 (2.7) | 63.9 (3.4) | 56.5 (2.9) | 70.5 (2.4) | 68.2 (1.7) | 67.7 (1.3) | 72.4 (1.2) | |

| AUC | 63.5 (2.0) | 70.1 (1.3) | 66.3 (1.7) | 70.9 (0.8) | 68.4 (0.5) | 69.2 (2.8) | 74.8 (0.3) | |

| MCIc-MCIn | ACC | 62.4 (2.8) | 65.5 (2.2) | 62.0 (2.3) | 64.7 (3.6) | 65.0 (0.9) | 67.7 (2.4) | 68.8 (0.7) |

| SEN | 66.4 (3.1) | 70.1 (3.2) | 67.9 (3.3) | 67.9 (4.6) | 67.2 (1.2) | 64.0 (2.5) | 72.0 (2.4) | |

| SPE | 62.4 (2.3) | 58.9 (0.5) | 53.6 (2.9) | 59.3 (6.9) | 66.6 (1.7) | 69.9 (3.1) | 64.4 (1.8) | |

| AUC | 64.4 (1.6) | 69.8 (2.2) | 65.8 (1.7) | 66.0 (3.8) | 68.9 (1.1) | 63.7 (3.0) | 72.3 (0.8) | |

| Note: data in bold and underlined are the best and second best results, respectively. | ||||||||

深度学习算法在这4个数据集上的表现明显优于传统机器学习算法。例如,与传统机器学习算法L1SVM相比,深度学习算法中整体表现最差的GAT在所有数据集的4个评价指标上平均提高了1.1%,原因是深度学习算法具有比传统机器学习算法更强大的特征提取能力,能够更好地理解受试者的MRI数据,从而更准确地对神经系统疾病进行诊断。

从整体上看,不使用图卷积神经网络算法的表现优于使用图卷积神经网络算法。例如,与使用图卷积神经网络算法相比,不使用图卷积神经网络算法在所有数据集的4个评价指标上平均提高了2.06%,原因是神经系统疾病数据集中样本特征差异较小,难以构建高质量的图结构,导致图卷积神经网络难以充分发挥其特征学习能力。

在所有深度学习算法中,本文提出的方法在整体上表现出最好的性能,然后依次是DGLCN、Transformer、SUGRL、GCN、GAT。例如,与DGLCN相比,本文提出的方法在所有数据集的4个评价指标上平均提高了1.4%。原因是:①通过样本重加权策略有效降低了类不平衡问题对模型的影响,有效提升了模型的泛化能力。②本文提出的方法通过监督对比损失使模型能够更好地学习到样本间的相互关系,提升了模型提取的特征嵌入质量,进而提高了模型的分类性能。

2.5 消融实验本文提出的方法包括两个重要部分,即样本重加权(a)和监督对比学习(b)。为了探究本文提出的方法中各个部分的有效性,在所有数据集上对不同部分组合的性能进行消融实验,结果见表 3。使用样本重加权策略与不使用时相比,在所有数据集的4个评价指标上平均提高了3.2%,这是因为样本重加权策略通过重新为不同类别的样本分配权重,使模型能够更加公平地对每个类别进行学习,获得更好的泛化性能。使用监督对比学习与不使用时相比,在所有数据集的4个评价指标上平均提高了6.8%,原因是监督对比学习能够使模型学习到样本间的相互联系,提升模型的特征提取能力,从而进一步提升模型的分类性能。因此,同时考虑样本重加权策略和监督对比学习是合理且有效的。

| 数据集 Dataset |

a | b | 准确率 ACC |

敏感度 SEN |

特异度 SPE |

曲线下面积 AUC |

| AD-NC | √ | 85.2 (0.8) | 88.6 (1.4) | 81.2 (0.4) | 91.1 (0.6) | |

| √ | 83.0 (0.8) | 85.1 (1.5) | 80.4 (0.7) | 89.0 (0.7) | ||

| √ | √ | 85.8 (0.7) | 88.8 (1.1) | 82.1 (1.1) | 91.3 (0.6) | |

| AD-MCI | √ | 70.2 (1.0) | 83.0 (1.8) | 43.5 (1.2) | 71.6 (1.4) | |

| √ | 68.8 (1.2) | 76.7 (1.6) | 51.9 (2.5) | 68.7 (1.2) | ||

| √ | √ | 69.9 (1.2) | 78.0 (2.2) | 53.0 (2.4) | 71.8 (1.1) | |

| NC-MCI | √ | 67.7 (0.8) | 80.4 (0.8) | 46.5 (2.7) | 74.5 (0.3) | |

| √ | 65.9 (0.7) | 70.9 (1.6) | 57.6 (1.8) | 72.0 (0.6) | ||

| √ | √ | 69.1 (1.0) | 67.2 (1.1) | 72.4 (1.2) | 74.8 (0.3) | |

| MCIn-MCIc | √ | 67.5 (1.3) | 72.7 (1.1) | 60.7 (3.2) | 72.0 (1.0) | |

| √ | 63.4 (1.3) | 67.3 (1.7) | 58.3 (3.1) | 68.2 (1.7) | ||

| √ | √ | 68.8 (0.7) | 72.0 (2.4) | 64.4 (1.8) | 72.3 (0.8) | |

| Note: data in bold are the best results. | ||||||

为进一步探究本文提出的方法在计算监督对比损失时不使用原始特征做法的合理性,分别使用以下4种组合计算监督对比损失进行消融实验:(Ⅰ) H,

| 数据集 Dataset |

设置 Setting |

准确率 ACC |

敏感度 SEN |

特异度 SPE |

曲线下面积 AUC |

| AD-NC | Ⅰ | 84.7 (0.8) | 87.8 (1.6) | 80.8 (1.1) | 91.0 (0.7) |

| Ⅱ | 84.7 (1.0) | 87.7 (1.6) | 81.0 (0.7) | 90.5 (0.4) | |

| Ⅲ | 85.3 (1.2) | 88.5 (1.1) | 81.3 (1.5) | 91.1 (0.6) | |

| Ⅳ | 85.8 (0.7) | 88.8 (1.1) | 82.1 (1.1) | 91.3 (0.6) | |

| AD-MCI | Ⅰ | 69.1 (0.9) | 79.8 (3.1) | 47.1 (4.4) | 70.8 (0.8) |

| Ⅱ | 68.8 (1.3) | 76.6 (2.3) | 52.2 (2.0) | 71.2 (1.1) | |

| Ⅲ | 69.4 (0.8) | 78.1 (1.7) | 51.3 (2.6) | 71.1 (0.8) | |

| Ⅳ | 69.9 (1.2) | 78.0 (2.2) | 53.0 (2.4) | 71.8 (1.1) | |

| NC-MCI | Ⅰ | 67.5 (1.0) | 63.1 (1.4) | 75.2 (1.5) | 74.3 (0.3) |

| Ⅱ | 67.3 (0.4) | 63.6 (1.4) | 73.7 (2.1) | 74.0 (0.6) | |

| Ⅲ | 68.0 (0.8) | 64.9 (0.7) | 73.6 (2.1) | 74.3 (0.3) | |

| Ⅳ | 69.1 (1.0) | 67.2 (1.1) | 72.4 (1.2) | 74.8 (0.3) | |

| MCIn-MCIc | Ⅰ | 66.6 (2.0) | 70.3 (1.0) | 61.9 (4.3) | 71.9 (0.6) |

| Ⅱ | 67.1 (0.8) | 70.2 (1.4) | 63.0 (1.4) | 72.1 (0.8) | |

| Ⅲ | 66.6 (1.8) | 69.9 (0.8) | 62.2 (3.6) | 71.8 (1.2) | |

| Ⅳ | 68.8 (0.7) | 72.0 (2.4) | 64.4 (1.8) | 72.3 (0.8) | |

| Note: data in bold are the best results. | |||||

2.6 参数敏感度实验

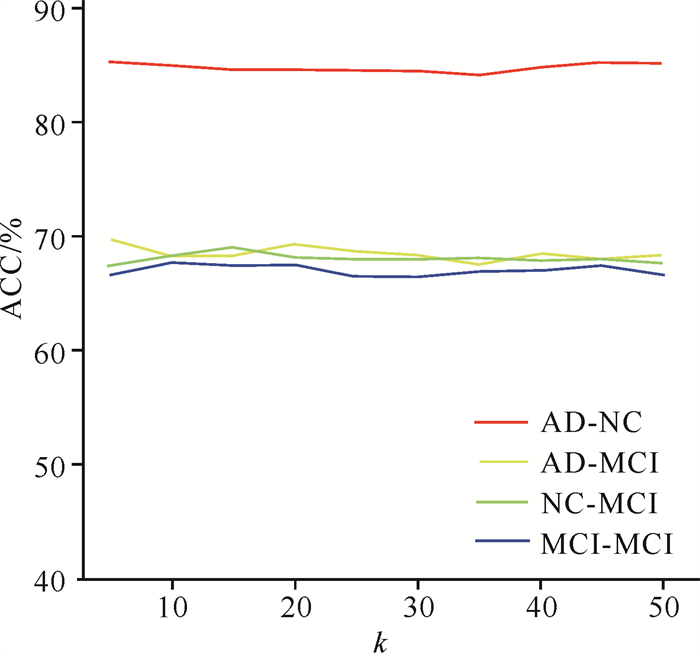

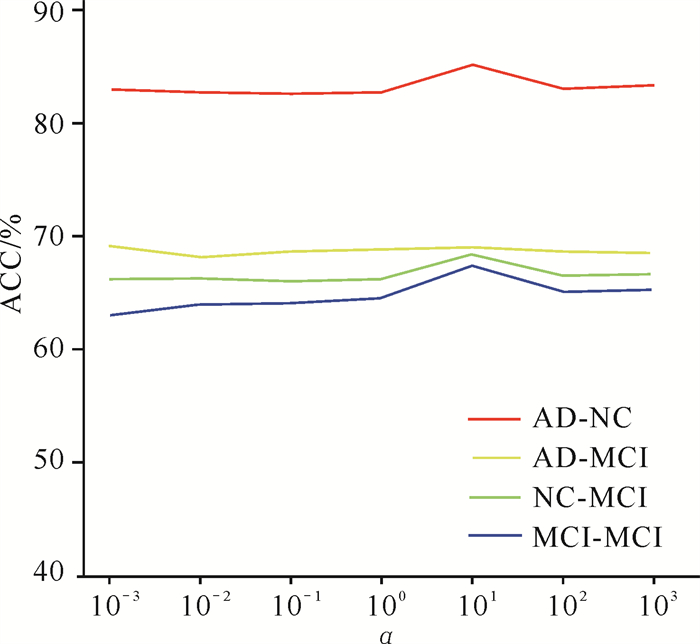

本文提出的方法包括2个关键超参数,即用于确定选择正负样本数量的k和用于调整监督对比损失在总损失中权重的α。下面分别对这两个参数进行参数敏感度实验。

在{10, 20, …, 50}范围内改变k的取值,结果见图 3。显然,本文提出的方法对k的取值并不敏感,原因是本文提出的监督对比学习在选择正负样本时考虑了类别因素,k的增大不会导致将非同类样本选为正样本或将同类样本选为负样本,因此依然能够使模型合理地对样本间的相互关系进行学习。

|

| 图 3 参数敏感度实验结果(k) Fig. 3 Results of the parameter sensitivity test (k) |

在{10-3, 10-2, …, 103}范围内改变α的取值,实验结果如图 4所示。本文提出的方法对α的取值较为敏感。具体来说,本文提出的方法在α的取值为101时达到最佳性能。原因是当α的取值过小时,监督对比损失在总损失中的占比过小,模型无法学习到样本间的相互关系导致分类效果不佳。而当α的取值过大时,加权交叉熵损失在总损失中的占比过小,模型难以从标签中学习到对不同类别的区分能力,同样会导致分类效果不佳。因此,选择合适的α对本文提出的方法至关重要。

|

| 图 4 参数敏感度实验结果(α) Fig. 4 Results of the parameter sensitivity test (α) |

3 结论

本文提出了一种新的基于深度神经网络的阿尔茨海默病早期诊断算法。首先在交叉熵函数中引入样本重加权策略,以降低疾病诊断数据集中的类不平衡问题对模型造成的负面影响;其次设计监督对比学习使模型学习到样本间的相互关系,从而提高模型的特征提取能力。实验结果表明,与现有最先进的方法相比,本文提出的方法具有更强的分类能力。

| [1] |

丁秀梅, 杜晓歌, 郭艳芳. 老年痴呆症患者精神行为症状现状调查及影响因素分析[J]. 临床医学, 2023, 43(12): 53-55. |

| [2] |

袁天漫, 徐菊玲, 钱秀群, 等. 老年痴呆病人认知功能受损的研究进展[J]. 全科护理, 2021, 19(15): 2050-2053. DOI:10.12104/j.issn.1674-4748.2021.15.008 |

| [3] |

刘建英, 于勰荔, 何明鸣. 早期康复训练联合健康教育对老年痴呆患者认知功能、生活质量和肢体功能的影响[J]. 中国老年学杂志, 2022, 42(7): 1703-1705. DOI:10.3969/j.issn.1005-9202.2022.07.049 |

| [4] |

SVETNIK V, LIAW A, TONG C, et al. Random forest: a classification and regression tool for compound classification and QSAR modeling[J]. Journal of Chemical Information and Computer Sciences, 2003, 43(6): 1947-1958. DOI:10.1021/ci034160g |

| [5] |

ZHU J, ROSSET S, TIBSHIRANI R, et al. 1-norm support vector machines[J]. Advances in Neural Information Processing Systems, 2003, 15379424. |

| [6] |

洪月华, 徐霜, 梁家荣. 一种基于粗糙集和遗传神经网络的数据分类器模型[J]. 广西科学, 2013, 20(2): 128-131, 136. |

| [7] |

吴建生. 旱涝灾害的遗传-神经网络集成预测方法研究[J]. 广西科学, 2006, 13(3): 203-206, 211. DOI:10.3969/j.issn.1005-9164.2006.03.013 |

| [8] |

COVER T, HART P. Nearest neighbor pattern classification[J]. IEEE Transactions on Information Theory, 1967, 13(1): 21-27. DOI:10.1109/TIT.1967.1053964 |

| [9] |

KIPF T N, WELLING M. Semi-supervised classification with graph convolutional networks[Z/OL]. (2017-12-22)[2024-06-02]. https://arxiv.org/abs/1609.02907v4.

|

| [10] |

ZHU Y H, MA J B, YUAN C G, et al. Interpretable learning based dynamic graph convolutional networks for Alzheimer's disease analysis[J]. Information Fusion, 2022, 77: 53-61. DOI:10.1016/j.inffus.2021.07.013 |

| [11] |

XIAO T S, ZENG L, SHI X S, et al. Dual-graph learning convolutional networks for Interpretable Alzheimer's disease diagnosis[C]//Medical Image Computing and Computer Assisted Intervention: MICCAI 2022. Cham, Switzerland: Springer Nature, 2022: 406-415.

|

| [12] |

LI H X, SHI X S, ZHU X F, et al. FSNet: dual interpretable graph convolutional network for Alzheimer's disease analysis[J]. IEEE Transactions on Emerging Topics in Computational Intelligence, 2023, 7(1): 15-25. DOI:10.1109/TETCI.2022.3183679 |

| [13] |

ZHANG Y, HE X, CHAN Y H, et al. Multi-modal graph neural network for early diagnosis of Alzheimer's disease from sMRI and PET scans[J]. Computers in Biology and Medicine, 2023, 164: 107328. DOI:10.1016/j.compbiomed.2023.107328 |

| [14] |

QU Z S, YAO T, LIU X H, et al. A graph convolutional network based on univariate neurodegeneration biomarker for Alzheimer's disease diagnosis[J]. IEEE Journal of Translational Engineering in Health and Medicine, 2023, 11: 405-416. DOI:10.1109/JTEHM.2023.3285723 |

| [15] |

文竹, 袁立宁, 黄伟, 等. 基于图多层感知机的节点分类算法[J]. 广西科学, 2023, 30(5): 942-950. |

| [16] |

李华, 陈宁江. 基于PSO的WFCM算法研究及其在医保欺诈行为发现中的应用[J]. 广西科学院学报, 2017, 33(1): 32-39. |

| [17] |

SHEN H T, ZHU X, ZHANG Z, et al. Heterogeneous data fusion for predicting mild cognitive impairment conversion[J]. Information Fusion, 2021, 66: 54-63. DOI:10.1016/j.inffus.2020.08.023 |

| [18] |

KABANI N J, MACDONALD D J, HOLMES C J, et al. 3D anatomical atlas of the human brain[J]. NeuroImage, 1998, 7(4): S717. DOI:10.1016/S1053-8119(18)31550-7 |

| [19] |

VELIC KOVIC P, CUCURULL G, CASANOVA A, et al. Graph attention networks[Z/OL]. (2018-12-04)[2024-06-02]. https://arxiv.org/abs/1710.10903v3.

|

| [20] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[Z/OL]. (2017-01-12)[2024-06-02]. https://arxiv.org/abs/1706.03762.

|

| [21] |

MO Y J, PENG L, XU J, et al. Simple unsupervised graph representation learning[C]//Proceedings of the AAAI Conference on Artificial Intelligence. Menlo Park, CA: AAAI, 2022: 7797-7805.

|