2. 电子科技大学深圳高等研究院, 广东深圳 518000

2. Institute for Advanced Study, University of Electronic Science and Technology of China Shenzhen, Shenzhen, Guangdong, 518000, China

近些年来,基于图神经网络(GNN)的深度学习研究发展迅速[1-4],这主要归因于图结构数据在各个领域如化学、交通、药物设计等方面[5-8]中无处不在。具有图结构的数据,其样本间通常存在复杂的关联关系(如节点之间的连接、边的权重等),且为非欧几里得数据,而传统深度学习的方法主要针对欧几里得数据设计,因此无法直接建模具有图结构的数据,从而使得其在图数据上的表征能力受限。尽管基于图神经网络的深度学习研究取得了巨大的成功,但是在许多现实场景中,获取大规模标记数据是一项昂贵且耗时的任务。与此同时,图神经网络作为深度学习模型的一种,同样存在过拟合问题,特别是在标注数据稀缺的情况下,监督学习设定下的图神经网络通常不具备良好的泛化能力。

为解决上述问题,自监督学习被认为是一种有前景的方法[9]。自监督学习的核心思想是不依赖于标签导向的任务而是通过解决一系列定制的代理任务来学习样本的表示,这些代理任务往往从数据本身获得,不需要人工标注。一个好的代理任务能够帮助模型从未标记的数据中学习到更多更好的信息表示,从而能够在各种下游任务上实现更好的泛化能力并拥有更强的健壮性。最近在自然语言处理领域和计算机视觉领域诞生了各种有效的代理任务,使得自监督学习能够迅速发展。在自然语言处理领域,早期的词嵌入技术[10]就是自监督学习的经典代表。如今,研究者提出各种有效的代理任务来预训练模型,使得当前的大语言模型[11]取得了飞速的进展,在许多任务的求解上超越了传统的监督学习,并且展现出强大的泛化能力。同样地,在计算机视觉领域,早期的代理任务如图像上色、拼图、视频帧排序、图像修补、损坏图像分类等,最近也被许多新的代理任务所取代,例如自监督对比学习框架(如MoCo[12]、SimCLR[13]和BYOL[14])利用图像变换下语义的不变性来学习视觉特征。而在自然语言处理领域盛行的预训练任务——掩码自编码,也在计算机视觉领域大力发展,例如,MAE[15]对输入图像的随机块进行掩盖(Mask)并对遗失像素进行重建,其性能甚至超越了当前许多基于对比的方法。

随着自监督学习在自然语言处理领域和计算机视觉领域取得的巨大成功,研究者们对应用自监督学习到图数据的兴趣越来越大。然而,将之前为自然语言处理或计算机视觉设计的代理任务转移到图数据分析中是富有挑战性的,主要是因为图数据是一种非欧几里得数据,不同于文本和图像等欧几里得数据。图的拓扑结构不限于规则的刚性结构,且节点直接相互关联,这导致现有的代理任务大多不能直接应用在图上。另外,图数据中各个样本之间都有着不同的关系,如连接关系、节点属性、边属性、路径、社区结构和网络中心性等,如何设计一个代理任务使得模型能够学习并输出节点的特征,并且表示出样本之间复杂的关系,也是一个非常重要的问题。这些挑战促使研究者在图领域的自监督学习中,对任务设计的复杂性、特征表征的有效性以及模型的泛化能力等进行专门的探索和定义[16]。考虑到图数据和样本关系的复杂性、多样性,并充分利用图拓扑结构与特征信息,图自监督学习模型在自掩码、辅助属性分类、对比学习、混合方法和不变性挖掘等方面都进行了探究。

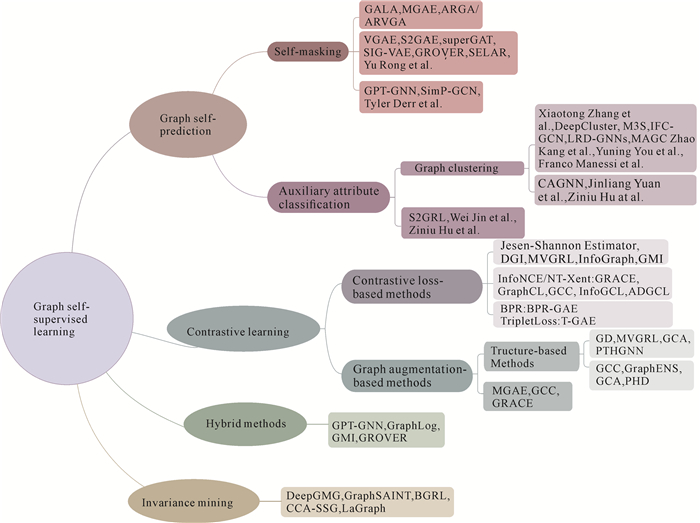

为推动图自监督学习方法的发展并促进实证比较,本文系统回顾了图自监督学习(GSSL)的现有方法,并为其提供了一个统一的分类框架(图 1)。具体而言,可将图自监督学习方法分为以下4类:①图自预测方法——通过利用图数据内部的特征、结构或聚类信息作为训练信号来学习表征;②对比学习方法——通过比较不同视图下的数据或数据对来训练模型;③混合方法——综合运用多种代理任务以提升模型的性能;④不变性挖掘方法——研究图数据在不同变换下的不变信息以增强鲁棒性。这种分类框架不仅揭示了现有方法之间的异同,而且也为未来新方法的开发提供了思路。此外,本文还总结了图自监督学习在医学图像等领域的应用与研究进展。最后,为了进一步推动图自监督学习的发展,本文指出了当前研究中的瓶颈问题,并探讨了未来有价值的研究方向。

|

| 图 1 图自监督学习方法的分类示意 Fig. 1 A taxonomy of graph self-supervised learning methods |

1 图自预测

给定一个图$\mathcal{G}=(E, V)$,其中E代表边的集合,V代表节点的集合。图结构可以用邻接矩阵$\boldsymbol{A} \in$ $\mathbb{R}^{|V| \times|V|}$来存储,$\boldsymbol{A}_{i, j}=1$则代表节点i和节点j之间存在一条连边,否则就没有连边;$\boldsymbol{D}=\sum\limits_i \boldsymbol{A}_{i, j}$是度矩阵,也是一个对角线矩阵,对角线的值对应每个节点的度;特征矩阵$\boldsymbol{X} \in \mathbb{R}^{n \times f}$用于描述由n个节点组成的f维特征向量。本文用到的部分数学符号所对应的含义如表 1所示。基于图的节点和边信息,神经网络容易从拥有大量注释标签的图中学习,但由于成本原因,研究者期望能够从少量或没有标签的图中完成同样的任务。

| 符号 Symbol |

含义 Definition |

| $\mathcal{G}$ | Input graph |

| E | Edge set |

| V | Node set |

| A | Adjacency matrix |

| Ai, j | Edge between node i and node j |

| D | Degree matrix |

| X | Feature matrix |

| pϕ(∙) | Decoder |

| $\mathcal{L}$ | Loss function |

| fθ | Encoder |

| λ | Regularization hyperparameter |

| H,h | Hidden representation of features |

| KL(∙) | Kullback-Leibler divergence |

| p(H) | Prior gaussian distribution |

| $\widetilde{\boldsymbol{A}}$ | Adjacency matrix with added self-loops |

| σ | ReLU activation function |

| Ω | Pseudo-label mapping function |

| $\mathcal{J}$JS | Jensen-Shannon divergence |

| $D_\phi$ | Discriminator |

| Tk | Transition matrix |

| d | Embedding distance metric |

| e | Graph edit distance |

| τ | Temperature parameter |

| u | Embedded representation |

| Z | Target prediction representation |

| B | Training batch |

| $\theta, \phi$ | Trainable parameters |

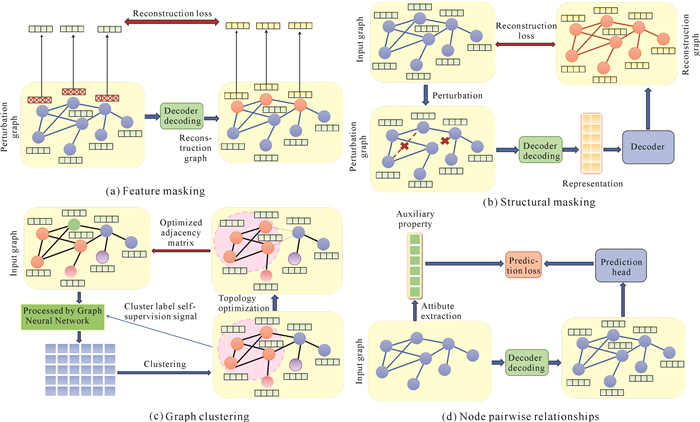

图自预测是一种利用图数据自身的特征、结构以及隐含的聚类信息或成对关系等属性作为监督信号进行训练的方法。该方法通过自动生成的信息标签作为监督信号,训练图编码器及其预测头,从而学习图数据的有效表征。本文将图自预测总体上分为基于自掩码和基于辅助属性两类方法,其中基于自掩码的方法又可细分为特征掩码和结构掩码2种,而基于辅助属性的方法则可细分为图聚类和节点成对关系2种,共4种方法。基于自掩码的方法从特征和结构两个角度进行数据的重建,而基于辅助属性的方法则通过更多样的特征图和拓扑图属性进行监督信号的丰富,图 2给出了各个类别模型的框架图。如图 2(a)所示,特征掩码方法对经扰动的特征信息进行恢复,从而进行学习。例如,Mgae[17]对随机扰动后的特征信息进行处理,ARGA和ARVGA[18]则引入正则化对数据噪声进行处理。结构掩码方法则对经扰动的邻接矩阵进行重建[图 2(b)],例如,变分图自编码器(VGAE)[19]针对无向图重构其节点链接;SIG-VAE[20]引入随机噪声增加建模不确定性,从而提高模型的灵活性;superGAT[21]应用注意力机制处理噪声图;SELAR[22]引入对多类型边的处理机制,使得模型可以有效应用于异构图。图聚类将节点划分为不同的簇,生成伪标签作为辅助信息进行建模[图 2(c)]。例如,基于特征聚类,M3S[23]分批次地对节点特征进行聚类训练,IFC-GCN[24]根据伪标签和特征聚类对节点特征进行约束,SDCN[25]将自动编码器的特征表示和GCN的结构感知特性结合,SGDMC[26]在特征聚类的基础上引入注意力网络对图样本进行加权训练;基于结构聚类,CAGNN[27]对噪声图进行同类别节点的边加强和聚类操作,自监督图卷积聚类(SGCC)[28]引入无监督流行学习算法。节点成对关系方法则将节点对关系作为辅助属性进行训练[图 2(d)],例如,S2GRL[29]引入节点间相对位置学习节点相似性与差异性,Jin等[30]以预测节点与中心节点的距离为优化目标。

|

| 图 2 4种图自预测模型图解 Fig. 2 Illustrations of four graph self-prediction models |

1.1 自掩码

基于自掩码方法将输入数据本身作为监督信号,通过重构图特征或结构来学习有效的表征。根据重构对象的类型,自掩码分为特征掩码与结构掩码两类。但自掩码模型易受噪声影响,优化噪声处理是提高模型效果的一种方法,诸如Mgae、SIG-VAE等方法都增加了对随机噪声的考虑;而且,因该类方法使用的图信息比较单一,联合多种类别任务进行联合训练或可在之后的研究中得到更好的效果。此外,目前许多模型都基于非异构图进行训练,在异构图方面的研究还存在许多的挑战,例如如何设计合适的自掩码任务使得模型能够表征不同类型的边和节点。基于上述背景,以下将详细介绍现有的自掩码方法及其应用。

1.1.1 特征掩码在计算机视觉领域,研究者通过对随机像素进行掩盖和预测,期望神经网络能够充分理解单张图像信息,对大面积的损失图像进行补全。针对输入的图像,Pathak等[31]采用3种剪裁策略将某些区域设置为0,这些策略包含对中心区域的掩盖,以及为了解决区域覆盖边界和低级特征学习问题而引入的随机化掩盖过程,并通过重构损失和对抗损失猜测缺失的像素。受图像修补方法的启发,许多研究在图结构上也采用自掩码的方法,从而使模型能够充分学习和理解结构或特征的信息。其中,特征掩码方法通过扰动和恢复图结构中的特征信息进行学习,该方法在训练过程中采用属性屏蔽,即将部分特征进行屏蔽,再通过训练恢复被屏蔽的属性。这一过程可以形式化表示为以下公式:

| $ \theta^*, \phi^*=\underset{\theta, \phi}{\operatorname{argmin}} \mathcal{L}_{\mathrm{mse}}\left(\mathrm{p}_\phi\left(\mathrm{f}_\theta\left(\widetilde{\mathcal{G}}\right)\right), \boldsymbol{X}\right), $ | (1) |

其中,$\widetilde{\mathcal{G}}=(\boldsymbol{A}, \widetilde{\boldsymbol{X}}), \widetilde{\boldsymbol{X}}$ 是经过主成分分析降维处理的特征矩阵。该方法具体使用均方差损失函数$\mathcal{L}_{\mathrm{mse}}$ 进行训练。

此外,Mgae[17]遵循去噪自编码器的思想,在随机扰动中引入边际化过程,即随机破坏图的内容特征,通过多次重复扰动生成多个经过扰动后的特征矩阵,并基于扰动结果计算得到每个特征收敛的破坏概率向量。对于给定的图$\mathcal{G}=(\boldsymbol{A}, \boldsymbol{X})$,经扰动的特征矩阵表示为$\left\{\widetilde{\boldsymbol{X}}_i\right\}_{i=1}^m$,使用单层自编码器即fθ对目标函数进行处理,并对多个堆叠的单层自编码器进行优化训练。其单层自编码器的目标函数如下:

| $ \sum\limits_{i=1}^m\left\|\boldsymbol{X}-f_\theta\left(\boldsymbol{A}, \widetilde{\boldsymbol{X}}_i\right)\right\|^2+\lambda\|\theta\|^2 \text { 。} $ | (2) |

其中,θ表示单层编码器中的可训练参数。

区别于Mgae等未正则化的方法,ARGA和ARVGA[18]考虑了潜在编码的数据分布,同时还考虑了现实世界中数据稀疏且存在噪声的特点,并针对性地引入了对抗正则化的方法。通过对抗训练使得潜在表示与先验分布匹配,并通过最小化二分类器交叉熵,将嵌入结果进行正则化改进。

1.1.2 结构掩码结构掩码通过恢复结构信息进行学习,在大多数情况下是指对邻接矩阵进行处理和重构。

VGAE[19]是最简单的自编码器,针对无向图设计。该模型不考虑节点特征,直接对删除部分边的邻接矩阵进行重构并完成链接预测任务,其编码器可以用公式表示为

| $ q({\boldsymbol{H}}\mid \boldsymbol{A},\boldsymbol{X}) = {\rm{ }}\prod\nolimits_{i = 1}^{|V|} {\cal N} \left( {{\boldsymbol{h}_i}\mid {{\boldsymbol{u} }_i}(\boldsymbol{A},\boldsymbol{X}),{\Sigma _i}(\boldsymbol{A},\boldsymbol{X})} \right),{\rm{ }} $ | (3) |

其中,$\boldsymbol{\mu}=\operatorname{GCN}(\boldsymbol{X}, \boldsymbol{A})$,是均值向量$\boldsymbol{\mu}_i$的矩阵;$|V|$ 是节点个数。优化变分下界:

| $ \begin{gathered} \mathbb{E}_{q(\boldsymbol{H} \mid \boldsymbol{A}, \boldsymbol{X})}[\log p(\boldsymbol{A} \mid \boldsymbol{H})]- \\ \mathrm{KL}[q(\boldsymbol{H} \mid \boldsymbol{A}, \boldsymbol{X}) \| p(\boldsymbol{H})] 。\end{gathered} $ | (4) |

SIG-VAE[20]在VGAE的基础上增加了分层编码器,通过添加随机噪声并集成图的领域信息,以此增加建模的不确定性,从而提高模型的灵活性。superGAT[21]在VGAE的基础上将注意力用于链接预测——该模型针对噪声图改进了图注意力模型,采用原始GAT和点积2种注意力机制,通过链接预测对注意力进行自我监督并通过负采样对稀疏图进行建模,研究边存在对节点分类的影响。SELAR[22]针对异构图,是一种将预测多个边类型的复合关系作为辅助任务学习的方法。该方法将两节点间的通过异构边的链接看作元路径(即多跳链接的推广),并将元路径预测作为自监督学习的辅助任务,类似于链接预测。此外,SELAR还提供了一个自动化框架,用于选择元路径并平衡元路径学习与链接预测任务之间的关系,从而进一步提升模型的性能。杜航原等[32]将VGAE与聚类结合,提出一种结合图自编码器与聚类的半监督表示学习方法,在编码器生成的低维表示基础上增加k-means聚类模块,从而使图自编码器的训练过程和节点的类别分布划分形成自监督机制。S2GAE[33]构建了一种边缘级对比学习框架,该框架先随机屏蔽部分边缘再对这些缺失的边缘进行重构,提高了模型在节点级和图级的泛化性。Rong等[34]用GROVER随机掩码目标节点/边缘的一个局部子图,并从节点嵌入中预测上下文属性,通过考虑目标节点/边缘和上下文来缓解模糊问题。该模型由节点GNN和边GNN两部分组成,通过将节点信息提取为查询(Query)、键(Key)和值(Value),并引入多头注意力机制来增强特征提取能力。为提升模型的泛化性能,在训练过程中采用动态消息传递网络(dyMPN)对消息传递的跳数进行随机化处理。此外,模型将两个自监督任务结合进行训练:一是上下文属性预测,用于学习原子、化学键及其数目之间的关系;二是图级别模式预测,用于捕捉官能团之间的关联。这种设计使得模型能够同时学习局部和全局的图结构信息,从而更好地适应复杂的图数据任务。

1.1.3 特征属性和结构信息的联合训练Jin等[30]结合了结构掩码和属性掩码两种形式对特征信息进行随机屏蔽和重建,同时将结构信息分为局部结构信息(边屏蔽、重建)和全局结构信息(衡量不同节点的距离),并将特征和结构两种信息进行组合。在此联合训练的基础上,SimP-GCN[35]设计了一个对比假设任务,用于计算节点对的相似性并采样生成训练样本,该任务同时平衡了图的结构与特征信息,构建了一种融合两种信息的图表示。该模型根据节点对的特征余弦相似性生成特征图(也叫KNN图),再进行自适应的图整合,并利用分数向量$\boldsymbol{S}^{(l)}$ 平衡来自KNN图和原始图的信息,计算节点特征贡献。另外,该模型还引入自监督学习组件并结合复杂的成对节点关系,预测成对的节点相似性。

自适应的图整合过程在第l层传播聚合的公式为

| $ \begin{aligned} & \boldsymbol{P}^{(l)}=\boldsymbol{s}^{(l)} \tilde{\boldsymbol{D}}^{-\frac{1}{2}} \tilde{\boldsymbol{A}} \tilde{\boldsymbol{D}}^{-\frac{1}{2}}+(1- \\ &\left.\boldsymbol{s}^{(l)}\right) \boldsymbol{D}_f^{-\frac{1}{2}} \boldsymbol{A}_f \boldsymbol{D}_f^{-\frac{1}{2}}, \end{aligned} $ | (5) |

| $ \boldsymbol{s}^{(l)}=\sigma\left(H^{(l-1)} W_s^{(l)}+b_s^{(l)}\right), $ | (6) |

其中,l指层序号;$\boldsymbol{H}^0=\boldsymbol{X}$;$W_s^{(l)}$与$b_s^{(l)}$是转换参数;Af、Df是k近邻图的邻接矩阵和度矩阵。

相似性的分类损失表示为

| $ \mathcal{L}_{\text {class }}=\frac{1}{\left|\boldsymbol{D}_{\mathrm{L}}\right|} \sum\limits_{\left(v_i, v_i\right) \in \boldsymbol{D}_{\mathrm{L}}} l_{\text {softmax }}\left(H_i, y_i\right), $ | (7) |

不相似性的损失函数为

| $ \begin{aligned} & \quad \mathcal{L}_{\text {self }}(\boldsymbol{A}, \boldsymbol{X})= \\ & \frac{1}{|T|} \sum\limits_{\left(v_i, v_j\right) \in T}\left\|f_w\left(H_i^{(l)}\right)-H_j^{(l)}-S_{i j}\right\|^2, \end{aligned} $ | (8) |

| $ S_{i j}=\frac{x_i^{\mathrm{T}} x_j}{\left\|x_i\right\|\left\|x_j\right\|}, $ | (9) |

其中,T表示节点对集合,fw为线性映射函数, i、j分别指节点i和节点j。

此外,GPT-GNN[36]实现了在单个大规模图上对GNN进行预训练和节点级迁移,同时捕获属性和结构信息。该方法通过设计两个自监督任务实现这一目标:一是根据节点的特征预测节点边的形成,二是根据节点边形成对节点特征的预测。在具体实现中,该模型通过将节点分为属性生成节点和边生成节点,并分别学习一个解码器,从而同时进行属性和边的生成任务,由此获得二者的依赖关系。

1.2 辅助属性分类辅助属性分类方法通过在图数据中引入一些额外的属性信息,包含节点的标签、属性、度数等,使得模型能够更好地理解图数据的结构和特征。为进一步降低对人工标注的依赖,许多研究开始探索基于辅助属性的自监督学习方法。

图聚类作为一种基于辅助属性的方法,由模型自动生成伪标签,减少了人工注释标签的成本,而不同的属性信息建模和辅助信息的选择对模型效果的影响较大。对于基于节点成对关系的方法,节点间的相似度与相对距离都是值得考虑的属性。未来,探寻图中多样的、具有代表性的属性信息,以及选择不同的属性信息进行联合训练或可提升模型性能。

1.2.1 基于图聚类的方法采用图聚类的方法能更好地利用特征信息和节点结构信息,对图结构或节点属性建模,将节点划分为不同的簇。此过程不仅依赖于节点的连接关系,而且还会考虑节点的特征相似性,从而将具有相似特征或紧密连接的节点划分到同一簇中,有效地结合了结构和内容的信息,并利用信息生成伪标签。其学习目标是将节点分为相应聚类,可表示为

| $ \begin{aligned} & \quad \theta^*, \phi^*= \\ & \underset{\theta, \phi}{\operatorname{argmin}} \frac{1}{|V|} \sum\limits_{v_i \in V} \mathcal{L}_{\mathrm{ce}}\left(p_\phi\left(\left[f_\theta(G)\right]_{v_i}\right), \Omega\left(v_i\right)\right), \end{aligned} $ | (10) |

其中,Ω: $\mathcal{V} \rightarrow \mathcal{C}$ 为获取节点伪标签的映射函数,[∙]vi表示用于获取节点vi表示的选择函数。

在图聚类方面,主要类别是特征聚类和结构聚类,在此基础上模型可引入多阶段自监督、交替优化策略、自编码器、无监督流行学习算法等,以实现更好的聚类效果。

1.2.1.1 基于特征聚类的方法Zhang等[37]提出了一种适应性图卷积方法用于属性图聚类,利用高阶图卷积捕捉全局聚类结构,并为不同的图自适应选择适当的阶数。这种方法更广泛地考虑多跳关系,从而能够更加高效地利用节点关系。在Zhang等[37]研究的基础上,DeepCluster[38]对中心剪裁区域图像特征进行聚类生成伪标签,并结合特征信息增强训练卷积神经网络,用以增强特征学习的不变性。

IFC-GCN[24]通过迭代特征聚类(IFC)模块增强标准GCN,所提出的IFC模块可根据预测的伪标签和特征聚类迭代地约束节点特征,从而提高伪标签的准确性;此外,该模型设计了一个类似期望最大化(EM)的框架,通过交替修正伪标签和节点特征来改善网络性能。为提高模型捕捉全局属性的能力和处理异质性更强的复杂网络,LRD-GNNs[39]构造了基于低秩分解的GNN(LRD-GNN-Matrix)和基于低秩张量分解的GNN(LRD-GNN-Tensor)。

Kang等[40]针对子空间聚类,利用二分图通过交替优化策略优化参数。该方法针对多视角数据,引入权重参数将更大的权重分配给更重要的视图,从而提高模型效率。自适应图卷积(AGC)[41]为针对多视图的图聚类提出的一种多视图属性图聚类框架,该框架基于随机游走表示节点的二阶关系,并采用多视图交替优化策略,通过对多视图探索互补信息获取共享的聚类模式,并通过图滤波技术保持低频信号使得较小特征值的信号更加平滑。

M3S[23]采用多阶段自监督将深度聚类(Deep clustering)与GCN结合,分批次进行节点标注,并在聚类后利用特征对齐将节点映射回标注空间。SDCN[25]首次将自动编码器和GCN结合,进行深度聚类。该方法设计了一个传递操作符,将自编码器学习到的表示传递给相应的GCN层,并由一个双自监督机制来统一自动编码器和GCN这2种不同的深度神经架构,从而指导整个模型的更新。在SDCN的基础上,DFCN[42]考虑到动态信息的融合与处理,提出一种基于相互依赖学习的结构和属性信息融合(SAIF)模块,用于明确地合并由自编码器和图自编码器学习到的表示,以进行一致性表示学习。

为解决噪声和异常值对图结构产生的影响,端到端并行自适应图卷积聚类(AGCC)[43]模型构建了两个路径网络:在第一路径网络中,AGC模块通过逐层交替更新图结构和数据表示的方法实现;在第二路径网络中,自编码器(AE)模块提取潜在的数据特征。注意力机制融合(AMF)模块对AGC和AE两个模块的数据表示进行加权与融合,实现模块间的连接,再将其传输到AGC模块。此外,在利用图数据的高阶属性和结构关系时,往往面临两个主要挑战:一是非独立分布的图高阶属性和结构关系的利用不足,二是冗余信息过多的问题。针对以上两个问题,R2FGC[44]模型基于给定图,通过属性扰动、边缘删除和图扩散对图进行增强,并构建了2种不同的图视图,再在AE模块与GAE模块中对经过增强的图视图学习属性级和结构级的潜在表示,并基于上述2种表示从全局和局部2个角度探索节点相似性。R2FGC利用节点之间的属性和结构级别的关系信息,提取了相同节点的增强不变关系,减少了不同节点之间的冗余相关性。

考虑到对图学习样本进行加权处理,可以更加充分地利用图信息,同时有效利用图信息对噪声样本进行检测,Huang等[26]提出了自监督图注意力网络的SGDMC方法。该方法提出了一种新型注意力分配机制以聚合潜在特征,注意力由潜在特征之间的高斯相似性与端点伪标签的余弦相似性决定。该模型在注意力层后构建了聚类层以获取视图的聚类结构,并根据重要节点更具影响力而其他节点更有可能是噪声样本的直觉提出一种新的样本加权策略,即通过评估其他样本对该样本的注意力之和来确定每个样本的全局权重。

You等[45]首次将自监督和多任务学习结合,在节点聚类任务的基础上,进一步引入图划分和图补全2种新的任务,并将多任务学习作为辅助来获取特征信息。在相邻节点更可能具有同一标签的假设下,图划分任务利用图的结构信息将节点分为大小接近的几个子集,使得不同子集间边数量最小化;图补全任务利用节点的特征信息进行破坏与重构。在此基础上,Manessi等[46]将顶点特征自编码、损坏顶点特征重建和损坏顶点嵌入重建3个任务共享参数,并通过静态超参数来平衡不同任务之间的优化目标,提高了模型的准确性。

1.2.1.2 基于结构聚类的方法CAGNN[27]通过提高嵌入质量以减轻潜在噪声边的影响,同时强化属于同一类别的节点之间的连接,以保留集群结构和获得更具区分度的节点嵌入。在此基础上对节点嵌入进行聚类,预测簇,并通过簇标签提供伪标签。同样地,Yuan等[47]针对嘈杂的图和标签训练稳健的GNN,生成代表聚类的伪标签,并基于这些伪标签设计了一个样本选择策略,以选择具有干净标签的节点。此外,Hu等[48]首先在聚类保存任务中获取了一组不重叠的簇,然后使用基于注意力的聚合器获取簇表示,最后通过NTN解码器估计节点与簇的相似性从而估算节点属于簇的概率。

SGCC[28]是一种新型聚类方法,该方法在聚类方法的基础上引入了无监督流行学习算法,从而可以更好地利用相似性信息。该方法通过先对超边中的相似性信息进行评估并排序,为每个期望聚类选择一个代表性的数据项作为初始表示并指导聚合过程。在之后的聚类步骤中,一次性迭代其余代表并对新项超边进行更新。

1.2.2 基于节点成对关系的方法除图的自身性质外,节点的成对关系也包含重要信息。定义映射函数Ω: $\mathcal{V} \times \mathcal{V} \rightarrow \mathcal{C}$,并根据成对的节点关系定义伪标签,其目标函数可以表示为

| $ \begin{aligned} & \quad \theta^*, \phi^*= \\ & \underset{\theta, \phi}{\operatorname{argmin}} \frac{1}{|\mathcal{P}|} \sum\limits_{v_i, v_j \in \mathcal{P}} \mathcal{L}_{\mathrm{ce}}\left(p_\phi\left(\left[f_\theta(\mathcal{G})\right]_{v_i, v_j}\right), \Omega\left(v_i, v_j\right)\right), \end{aligned} $ | (11) |

其中,$P \subseteq \mathcal{V} \times \mathcal{V}$ 是任务的节点对集合, [∙]vi是用于提取和链接vi、vj节点表示的选择函数。

S2GRL[29]利用节点的相对位置,收集k跳内节点的路径长度(该路径长度反映了两个节点交互的程度),编码了全局拓扑,还区分了节点之间的细粒度交互,因此学习到的表示能够细致地表征节点之间的相似性和差异性。在前者的启发下,Jin等[30]统计成对节点间的最短路径,建立了与图簇相关的一组固定的锚点/中心节点;随后,模型预测每个节点到中心节点的距离,并应用METIS图划分算法对图进行划分,将最高度数的节点分配为相应簇的中心。以预测节点与中心簇的距离为优化目标,该问题被定义为一个多重回归问题。此外,Hu等[48]联合了3个任务来关注图结构的不同信息,包括去噪链接重建(移除部分边并进行重构)、中心性得分排名、聚类保存,3个任务共享编码器参数并由不同的参数控制从而进行连接。其中对中心性得分进行排名旨在预测每对节点中心性得分的相对顺序,并根据中心性得分创建伪标签。

如表 2所示,在自掩码模型方面,经结构掩码处理的模型效果往往比特征掩码的更好,随机噪声对自掩码的训练效果影响较大。注意力机制的引入,如SuperGAT,给模型带来了较大的性能提升。而使用聚类操作辅助属性分类方法的模型,如M3S、IFC-GCN等,效果一般会比自掩码模型更好。此外,利用节点相对位置信息进行训练的方法,如S2GRL,在部分数据集上也取得了更好的效果。

| Unit: % | |||||||||||||||||||||||||||||

| 方法 Method |

引文网络数据集 Cora |

学术文献引用网络数据集 CiteSeer |

生物医学文献引用网络数据集 PubMed |

基于维基百科的计算机科学主题链接数据集 Wiki-CS |

亚马逊产品评论网络数据集,计算机类别 Computers |

亚马逊产品评论网络数据集,照片类别 Photo |

|||||||||||||||||||||||

| GCN | 81.50 | 70.30 | 78.80 | 76.89 | 86.34 | 92.35 | |||||||||||||||||||||||

| GAT | 82.80 | 71.50 | 78.50 | 77.42 | 87.06 | 92.64 | |||||||||||||||||||||||

| MLP | 56.11 | 56.91 | 71.35 | 72.02 | 73.88 | 78.54 | |||||||||||||||||||||||

| GALA | 74.59 | 69.32 | 69.39 | 54.44 | |||||||||||||||||||||||||

| ARGA | 64.00 | 57.30 | 68.07 | 38.05 | |||||||||||||||||||||||||

| ARVGA | 63.80 | 54.40 | 51.30 | 38.67 | |||||||||||||||||||||||||

| VGAE | 79.81 | 66.75 | 77.16 | 76.63 | 86.37 | 92.93 | |||||||||||||||||||||||

| SIE-VAE | 79.7 | 70.4 | 79.3 | ||||||||||||||||||||||||||

| MGAE | 63.43 | 63.56 | 43.88 | ||||||||||||||||||||||||||

| SuperGAT | 84.4 | 72.6 | 81.7 | ||||||||||||||||||||||||||

| M3S | 81.6 | 71.9 | 79.3 | ||||||||||||||||||||||||||

| IFC-GCN | 84.5 | 74.2 | 81.3 | 93.1 | 91.4 | ||||||||||||||||||||||||

| Knn-GCN | 67.4 | 68.7 | 78.9 | ||||||||||||||||||||||||||

| SGC | 81.0 | 71.9 | 78.9 | 90.0 | 91.2 | ||||||||||||||||||||||||

| SDCN | 65.96 | ||||||||||||||||||||||||||||

| CAGNN | 77.37 | 67.30 | 71.03 | ||||||||||||||||||||||||||

| AGC | 68.92 | 67.00 | 69.78 | ||||||||||||||||||||||||||

| S2GRL | 83.7 | 72.1 | 82.4 | ||||||||||||||||||||||||||

2 基于对比学习的方法

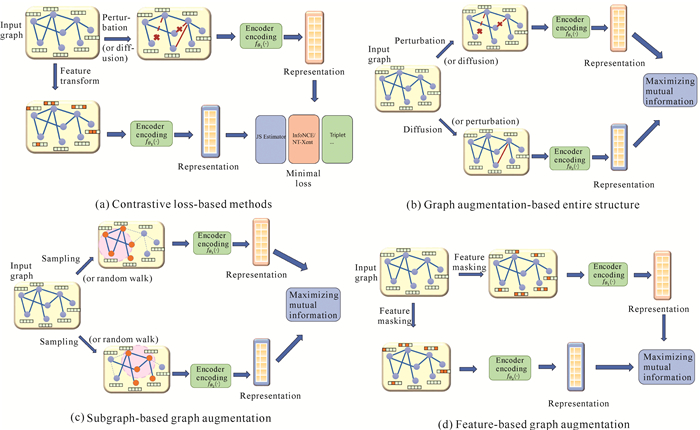

对比学习是现在图自监督学习研究最热门的一个部分。对比学习是建立在最大化互信息(MI)的思想上,通过预测增强实例之间的一致性来进行学习。具体而言,该方法通过最大化具有相似语义信息的图实例(正样本)之间的互信息,同时最小化不相关信息的图实例(负样本)之间的互信息来学习。本文将这种方法分为两大类:基于对比损失的方法(如Jensen-Shannon Estimator、InfoNCE/NT-Xent等)和基于图增强的方法(基于结构增强和基于特征增强),其中有代表性的模型如图 3所示。图 3(a)是基于对比损失的方法,通过最大化正样本视图的一致性、最小化负样本视图的一致性来学习表示。常见的对比损失有Jensen-Shannon Estimator损失(DGI模型使用此种损失)和InfoNCE/NT-Xent损失(GCC模型和GRACE模型使用该种损失)。图 3(b)为基于整个结构的图增强方法,主要有边扰动和图扩散两类方法。MVGRL模型采用图扩散生成全局视图,并与局部结构进行多视角对比学习;GD模型采用图扩散进行增强;GCA模型保留了重要的节点特征,同时为那些不重要的节点分配更高的掩蔽概率;HeCo模型使用交叉视图对比机制,从不同视角(网络模式和元路径视图)学习节点嵌入,在处理自我监督的异构图神经网络(HGNNs)有较好的表现。图 3(c)为基于子图的图增强方法,GraphCL模型采用通过均匀采样子图和随机边扰动等增强策略进行图增强;GCC采用了随机游走子图采样的方法;GraphENS模型采用了基于Ego网络采样的方法;CTAug模型由拓扑增强模块和图学习增强模块构成,通过添加或删除边来修改图的结构从而实现图增强。图 3(d)则是基于特征的图增强,如MGAE模型采用了相邻节点特征噪声;GRACE模型对不显著的节点特征施加额外的噪声,最终实现图增强。

|

| 图 3 图自监督对比学习模型图解 Fig. 3 Illustrations of graph self-supervised contrastive learning models |

2.1 基于对比损失的方法

互信息估计是对比学习方法的核心,其通过对不同样本在空间中的位置进行调整,实现与正样本之间的距离缩小和与负样本之间的距离扩大。互信息的定义如下:

| $ \begin{aligned} & I(x, y)=\operatorname{KL}(p(x, y) \| p(x) p(y))= \\ & E_{p(x, y)}\left[\log \frac{p(x, y)}{p(x) p(y)}\right], \end{aligned} $ | (13) |

| $ \begin{aligned} & \mathcal{I}(x, y)=\operatorname{KL}(p(x, y) \| p(x) p(y))= \\ & E_{p(x, y)}\left[\log \frac{p(x, y)}{p(x) p(y)}\right], \end{aligned} $ | (14) |

其中,KL表示Kullback-Leibler散度,用于度量两个概率分布之间的差异,其值越小表示这两个概率分布之间的接近程度越高,即它们之间的信息损失或信息增益较小。

2.1.1 Jensen-Shannon(JS)散度在图对比学习中,JS散度相对于KL散度更为常见。JS散度为互信息提供一个下界,并提供了更有效的估计。因此,在基于JS散度的对比学习中,对比损失的形式如下:

| $ \begin{gathered} \mathcal{L}_{J S}\left(D_\phi\left(\boldsymbol{h}_i, \boldsymbol{h}_j\right)\right)=-\mathcal{M} \mathcal{I}_{J S}\left(\boldsymbol{h}_i, \boldsymbol{h}_j\right)=\mathbb{E}_{\mathcal{P} \times \overline{\mathcal{P}}} \\ {\left[\log \left(1-D_{\varPhi}\left(\boldsymbol{h}_i, \boldsymbol{h}_j^{\prime}\right)\right)\right]-\mathbb{E}_{\mathcal{P}}\left[\log \left(D_{\varPhi}\left(\boldsymbol{h}_i, \boldsymbol{h}_j\right)\right)\right],} \end{gathered} $ | (15) |

其中,公式中hi和hj是从相同的分布P中采样的,对比损失为负互信息。对于图G={ A, X },Veličković 等[49]提出DGI方法,对输入图生成全局视图和局部视图两个视图:全局视图直接为输入图本身,局部视图则通过对节点采样和邻居连接采样来构建,将这两个视图分别输入编码器得到表示,然后通过JS散度最大化这两个视图表示的互信息。Hassani等[50]提出MVGRL方法,采用了类似的方式获得了负样本的采集。另外,InfoGraph[51],GMI[52]也使用了JS散度来计算两个表示hi和hj之间的互信息。

2.1.2 InfoNCE/NT-Xent损失InfoNCE(Normalized Mutual Information Neural Estimation)是由You等[53]提出的用于自监督学习的对比损失函数,用于衡量两个样本之间的相似性,它通过最大化归一化的互信息来进行训练。类似于JS散度,该函数为噪声对比估计器(也称为InfoNCE)提供了一种互信息估计的下界,该估计自然地由1个正对和N个负对组成。基于InfoNCE的对比损失可以被定义为

| $ \begin{array}{r} \mathcal{L}_{\mathrm{con}}\left(\mathrm{D}_\phi\left(\boldsymbol{h}_{\mathrm{i}}, \boldsymbol{h}_j\right)\right)=-\mathcal{M I _ { \mathrm { NCE } } ( \boldsymbol { h } _ { i } , \boldsymbol { h } _ { j } ) =} \\ -\mathbb{E}_{\mathcal{P} \times \widetilde{\mathcal{P}}^N}\left[\log \frac{e^{D_\phi\left(\boldsymbol{h}_i, \boldsymbol{h}_j\right) / \tau}}{e^{D_\phi\left(\boldsymbol{h}_i, \boldsymbol{h}_j\right) / \tau}+\sum\limits_{n \in N} e^{D_\phi\left(\boldsymbol{h}_i, h_n^{\prime}\right) \tau}}\right], \end{array} $ | (16) |

其中,通过调节τ可以控制概率的分布形状。GRACE[54]、GraphCL[53]和GCC[55]使用了该判别器。具体来说,GRACE利用结构变换和特征变换等技术扩增图的视图空间:首先,它对扩增后的视图进行编码以获得对应的表示;随后,通过对这些表示进行投影,可以得到新的、更丰富的表示,而在这个过程中,GRACE使用InfoNCE损失来最大化同一图中不同视图之间的互信息,以促进节点表示的学习和优化。GraphCL与GRACE类似,通过节点删除和边删除实现视图扩增。特定类型的InfoNCE损失,称为NT-Xent[56]损失,而NT-Xent损失中引入了归一化和预设的参数,用于控制概率分布的平滑度和模型的收敛性。在计算对数概率时允许这些参数对分布进行归一化处理,且在计算得分时通过调整τ来平衡正样本和负样本之间的差异。Li等[57]提出了一种结合社区感知的对比学习框架,通过边丢弃和属性掩码生成两个增强视图,并结合节点级对比与社区级对比, 使用InfoNCE损失最大化同一节点在不同视图中的表示一致性。

2.1.3 其他目标函数除了上述两个下限互信息估计器外,还可以采用Triplet Loss[58]来估计数据实例之间的互信息,但最小化Triplet Loss损失并不能保证互信息被最大化,因为它不能代表互信息的下界。另外,Rendle等[59]使用贝叶斯个性化排名(BPR)损失来估计互信息。

2.2 图增强在计算机视觉的研究中,对比学习在很大程度上依赖于图增强,从而有利于模型探索更丰富的底层语义信息。然而,由于图数据的特性,将欧氏空间中的增强方法直接应用于非欧氏空间是具有挑战性的。目前,已经存在两种主要类型的图增强方法:基于结构的增强和基于特征的增强。

基于结构的图增强方法主要关注调整图的拓扑结构,以改变图中节点之间的连接方式。该方法包括通过添加或删除节点、增加或减少边的方式来改变图的结构,例如随机节点删除、边删除、子图采样等,从而改变图的稀疏性和连通性,最终引入更多的变化和噪声,提高模型的鲁棒性和泛化能力。

基于特征的图增强方法主要是在节点或图级别上对节点特征进行变换或扰动。该类方法通过对节点特征进行随机扰动、特征交换、特征裁剪等方式来引入数据多样性,节点特征的随机遮挡、扰动、几何变换等方法都可以增加图的变化,并促使模型学习到更具有鲁棒性的特征表示。

图增强可以为模型提供更多的训练样本,扩充训练数据的多样性,而且增强也起到一定的正则化作用,有助于提高模型的泛化能力。一些图增强策略(如边扰动、节点遮蔽等)能够模拟真实数据中可能存在的噪声,训练增强后的模型往往能获得更好的鲁棒性,在噪声和数据缺失的情况下有更强的适应能力。然而基于结构的图增强方法可能破坏图的拓扑结构,基于特征的图增强方法可能引入过多噪声,影响表示质量,未来研究应优化这两点。此外,异质图、动态图等复杂场景下的视图生成策略也有待研究。

2.2.1 基于结构的图增强方法在结构(Structure)方面,可以分为整个结构(Whole structure)变换和子图(Subgraph)变换两类。设图G={ A, X },第i个图增强实例可以用$\tilde{G}^{(i)}=t_i(G)$表示,则基于结构的图增强可以表示为

| $ \tilde{G}^{(i)}=\left(\tilde{\boldsymbol{A}}^{(i)}, \boldsymbol{X}\right)=\left(t_i(\boldsymbol{A}), \boldsymbol{X}\right), $ | (17) |

其中,$\tilde{G}^{(i)}$表示增强后的图,$\tilde{\boldsymbol{A}}^{(i)}$ 表示增强后的结构属性矩阵,ti表示图增强函数。

2.2.1.1 基于整个结构的图增强方法基于整个结构的图增强方法,主要有边扰动(Edge perturbation)和图扩散(Graph diffusion)两类方法。边扰动是在整个图上随机添加/删除边[53, 60],图扩散是在整个图上创建新边。GraphCL模型采用均匀采样子图和随机边扰动等增强策略进行图增强[53]。Gasteiger等[61]提出的GD采用了图扩散的方法,通过扩散过程来增强图的特征传播,可以有效捕捉图中的高阶依赖关系:

| $ t_i(\boldsymbol{A})=\sum\limits_{k=0}^{\infty} \Theta_k \boldsymbol{T}^k, $ | (18) |

其中,${\Theta _k}$和Tk分别是加权系数和转移矩阵。

GCA[62]保留了重要的节点特征,同时为那些不重要的节点分配更高的掩蔽概率,其重要性由节点中心性来衡量。Liu等[63]提出了一种基于结构的学习方法:通过图学习器(Graph learner)学习一个图,然后将这个图作为一个视角,和原图进行对比学习,训练时图学习器的参数也会更新,因此最终能得到一个较好的图结构。Li等[64]提出了一种HeCo增强的方法,HeCo在处理HGNNs时,通过使用交叉视图对比机制,从不同视角(网络模式和元路径视图)学习节点嵌入,以捕捉局部和高阶结构。

2.2.1.2 基于子图的图增强方法基于子图的图增强方法主要有统一采样(Uniform sampling)、随机游走采样(Random walk sampling)以及Ego网络采样(Ego-nets sampling)3类。统一采样即从图中随机采样节点及其边组成的子图,如GraphCL[53]。随机游走采样,即基于随机游走采样子图,如GCC[55]。Ego网络采样,即以采样中心节点的k跳邻居组成子图,Park等[65]提出的GraphENS采用此种方法。另外,基于Ego网络采样,Kim等[66]提出了D-SLA方法,其代理任务为判断生成图和原图的区别。基于子图的对比损失函数如下:

| $ \mathcal{L}_{G D}=-\log \left(\frac{e^{S_0}}{e^{S_0}+\sum_{i \geqslant 1} e^{S_i}}\right), S=f_S\left(h_\mathcal{G}\right) 。$ | (19) |

由于这个式子无法具体区分原图和每一个生成图,所以进一步利用图的编辑距离来监督图的表示学习,两个图的编辑距离越近,他们的表示就越近。基于编辑距离的损失函数为

| $ \mathcal{L}_{\mathrm{edit}}=\sum\limits_{i, j}\left(\frac{d_i}{e_i}-\frac{d_j}{e_j}\right)^2, d_i=f_{\text {diff }}\left(h_{\mathcal{G}_0}, h_{\mathcal{G}_i}\right) 。$ | (20) |

基于子图的图增强方法通过对原始图进行结构上的修改来生成新的子图,这些子图可以帮助模型更好地学习图的表示。Liu等[67]提出了一种基于子图的图增强方法,其主要思想是在数据增强阶段,将原图分为同配图(Homophilic graph)和异配图(Heterophilic graph),在异配图上同样有很好的表现。Wei等[68]提出了一种基于显著性的图对比方法:首先通过图对比显著性的定义,计算节点和边的显著性,然后迭代计算和删除显著性低的节点和边,最后得到显著性最高的图结构并将其作为增强的视图进行对比学习。Wu等[69]提出了CTAug方法,可通过添加或删除边来修改图的结构。CTAug由拓扑增强模块和图学习增强模块构成,前者旨在生成保留内聚属性的增强图,后者则旨在增强图编码器对子图模式的辨别能力。

2.2.2 基于特征的图增强方法设图G={ A, X },则第i个图增强实例可以用$\tilde{\mathcal{G}}^{(i)}=t_i(\mathcal{G})$ 表示。则基于特征的图增强方法可以表示为

| $ \tilde{\mathcal{G}}^{(i)}=\left(\boldsymbol{A}, \tilde{\boldsymbol{X}}^{(i)}\right)=\left(\boldsymbol{A}, t_i(\boldsymbol{X})\right), $ | (21) |

其中,$\tilde{\mathcal{G}}^{(i)}$为增强后的图,$\tilde{\boldsymbol{X}}^{(i)}$表示增强后的特征属性矩阵。

| $ t_i(\boldsymbol{X})=\boldsymbol{M} \circ \boldsymbol{X}, $ | (22) |

M是与 X具有相同形状的掩码矩阵,对于给定的掩码矩阵,其元素已初始化为1,并且掩码条目被分配为零。除了通过随机采样生成掩码矩阵M之外,还可以通过自适应计算的方式生成。

在特征方面,主要通过特征变换来实现。对比学习方法可分为以下3类:①随机遮蔽(Random masking),即节点特征的随机遮蔽,将节点特征按一定比例替换为0或者随机噪声[70];②基于中心性的遮蔽(Centrality-based masking),根据节点的中心性指标对节点进行重要性排序,重要性较低的节点特征更可能被遮蔽;③高斯噪声(Gaussian noise),向节点特征中添加高斯噪声,当添加的噪声均值为0时,即在原特征基础上添加噪声;当噪声均值为原特征的值时,即用噪声特征替换原特征。GraphCL[53]采用节点特征掩码。MGAE[17]采用相邻节点特征噪声。

GRACE[54]对那些不显著的节点特征添加额外的噪声,以促使模型更加依赖底层语义信息,而非仅仅依赖于特定的特征值。GRACE的损失函数如下:

| $ \mathcal{L}=-\sum\limits_i \log \frac{\exp \left(\theta\left(u_i, v_i\right) / \tau\right)}{\sum\limits_j \exp \left(\theta\left(u_i, v_j\right) / \tau\right)},$ | (23) |

其中,ui和vi分别是节点i在两个视图中的嵌入表示;θ(ui, vj)是ui和vi之间的相似度度量,通常使用余弦相似度;τ是温度参数,用于控制相似度的平滑程度。

对比学习具有良好的泛化能力,可扩展性较强,可以从数据中挖掘出隐含的结构和模式,但目前较难获得最优视图生成策略,而图的生成质量对学习表示的质量影响很大。另外,当扩展到大规模图时,计算效率和内存消耗也是一个挑战,而且其对于异质图的处理还有待深入研究。未来的研究可从以下4个方面入手:提高在大规模图上的计算效率、优化对比损失或编码器结构,以及研究异质图的自监督学习范式、设计适合异质图的代理任务等。如表 3所示,本文总结了有代表性的基于对比学习方法的定量实验结果。

| Unit: % | |||||||||||||||||||||||||||||

| 数据集 Datasets | DGI | GMI | InfoGCL | MVGRL | CCA-SSG | GCA | GraphCL | CG3 | GraphENS | CTAug | MA-GCL | GRACE | |||||||||||||||||

| Cora | 82.3 | 82.71 | 83.5 | 82.91 | 83.92 | 81.24 | 83.62 | 83.4 | 77.26 | 83.3 | 81.7 | ||||||||||||||||||

| Citeseer | 71.8 | 73 | 73.5 | 72.6 | 73.1 | 71.8 | 72.5 | 73.6 | 63.98 | 73.6 | 71.5 | ||||||||||||||||||

| PubMed | 76.8 | 80.1 | 79.1 | 79.4 | 81.3 | 82.8 | 79.8 | 80.2 | 79.6 | 83.5 | 80.7 | ||||||||||||||||||

| Coauthor-CS | 92.15 | 92.11 | 93.37 | 93.1 | 92.98 | 94.19 | 92.93 | ||||||||||||||||||||||

| Amazon-C | 83.95 | 87.52 | 88.42 | 87.85 | 88.06 | 88.3 | 88.83 | 87.46 | |||||||||||||||||||||

| Photo | 91.61 | 90.68 | 91.74 | 92.84 | 92.53 | 92.21 | 92.15 | ||||||||||||||||||||||

3 基于不变性的挖掘

在基于不变性挖掘的方法中,通过挖掘图数据中的不变性来学习图表示。首先需要定义一个不变性,它指的是图结构或图属性在某些变换下保持不变,常用的不变性包括节点顺序不变性、边顺序不变性、子图同构不变性。

DeepGMG是Li等[71]提出的一种基于子图同构不变性的GNN自监督学习方法,该方法使用图同构挖掘算法从图数据中挖掘出同构子图,然后使用这些子图来训练GNN模型。GraphSAINT是Zeng等[72]提出的一种方法,它是一种基于图核不变性的GNN自监督学习方法。它使用图核挖掘算法从图数据中挖掘出具有相似核的子图,然后使用这些子图来训练GNN模型。此外,还有BGRL[73],其参考了BYOL[74]框架,通过参数预测器学习节点表示之间的不变性,不需要负样本。BGRL由两个编码器和一个解码器组成,两个编码器分别用于对图中的两类节点进行编码,解码器则用于将编码后的节点表示重构为原始图,其公式表示为

| $ \mathcal{l}(\theta, \phi)=-\frac{2}{N} \sum\limits_{i=0}^{N-1} \frac{\widetilde{Z}_{(1, i)} \widetilde{H}_{(2, i)}}{\left\|\widetilde{Z}_{(1, i)}\right\|\left\|\widetilde{H}_{(2, i)}\right\|}, $ | (24) |

其中,$\widetilde{Z}$和$\widetilde{H}$分别表示两个增强图中的节点表示。遵循余弦相似性的梯度对在线参数θ进行更新,以使得预测的目标表示逐渐接近于每个节点的真实目标表示$\widetilde{H}_2$。

CCA-SSG[75]提出了一种新的基于差异不变的目标函数,其目标包含不变性项(最小化两个增强图的表示差异)和解相关项(最小化表示维度之间的相关性)。首先,对输入图进行随机扩充,生成两个不同的视图,并利用图编码器对这两个视图进行编码,得到对应的节点表示矩阵;然后,通过典范相关分析(CCA)对这两个节点表示矩阵进行分析,生成两个新的节点表示矩阵;最后,利用指定的损失函数对两个新的节点表示矩阵进行训练,使得模型能够学习到图数据中的内在相关性。CCA-SSG的目标函数如下:

| $ \begin{aligned} & \quad \mathcal{L}=\left\|\widetilde{\boldsymbol{Z}}_A-\widetilde{\boldsymbol{Z}}_B\right\|_F^2+\lambda\left(\left\|\widetilde{\boldsymbol{Z}}_A \widetilde{\boldsymbol{Z}}_A-\boldsymbol{I}\right\|_F^2+\right. \\ & \left.\left\|\widetilde{\boldsymbol{Z}}_B \widetilde{\boldsymbol{Z}}_B-I\right\|_F^2\right), \end{aligned} $ | (25) |

其中,$\widetilde{\boldsymbol{Z}}_A$和$\widetilde{\boldsymbol{Z}}_B$为两个视图的编码所得;超参数λ>0,用于平衡不同部分的损失。

此外,LaGraph[76]利用隐变量的假设,将自监督学习目标推导为信息瓶颈上界,保证了视图表示在噪声中的不变性。

目前不变性定义还较为简单,未能充分挖掘数据的深层次不变特征。一些方法如DeepGMG、Graph-SAINT需要事先挖掘满足特定不变性的子结构,计算代价较高;另外,还缺乏对异质图和动态图等更复杂图结构不变性的探索。未来应进一步探索更高层次、更泛化的不变性定义,以捕获数据的内在本质特征,从而促进研究扩展到如异质图、动态图等更复杂场景下的不变性学习问题。

4 混合方法混合方法的运用涉及多个前置任务,以更充分利用各种监督信号的优势。混合方法以多任务学习的方式将多种前置任务整合为一体,其中的目标函数为两个或多个自监督学习目标函数的加权总和。混合方法可被形式化为

| $ \theta^*, \phi^*=\underset{\theta, \phi}{\operatorname{argmin}} \sum\limits_{i=1}^N \alpha_i \mathcal{L}_{\mathrm{sss}_i}\left(f_\theta, p_{\phi_i}, D_i\right), $ | (26) |

其中,N表示前置任务的数量,αi, $\mathcal{L}_{\mathrm{ssl}_i}, p_{\phi_i}, D_i$分别表示权衡权重、损失函数、前置任务解码器、第i个前置任务的数据分布。

混合型任务可分为以下几种类型。

第1种为多种生成任务的混合方法,如GPT-GNN[77]将特征和结构生成融入GNN的训练前框架。对于每个输入,首先对部分边和节点进行随机掩盖,然后同时训练编码器执行属性生成和边缘生成两个生成任务。属性生成任务利用均方误差(MSE)损失重构被掩蔽的特征,而边缘生成任务则通过对比损失来预测被掩蔽的边缘。

第2种为多个对比学习任务的混合方法,以提供不同视角的监督信号。GraphLog[78]将子图与子图、图与图、图与上下文作为对比目标, 将InfoNCE损失用作3种对比学习的互信息估计器。HDMI[79]结合了同尺度和跨尺度对比学习,将给定的多路网络分解为多个属性图,并提出3个不同的目标以最大化原始节点特性、节点嵌入和图级表示之间的互信息。

第3种为第1和第2种混合方法的融合,例如GMI采用联合学习目标进行图表示学习。其中,对比学习目标(即特征互信息)通过JSD估计器最大化节点嵌入与邻居特征的一致性,生成目标(即边缘互信息)通过最小化带有二元交叉熵(BCE)损失的邻接矩阵重构误差来实现。

另外,还可以将不同的基于属性的辅助任务集成到混合方法中。例如在GROVER[80]中,预训练Graph-Transformer模型的同时引入了节点级(上下文属性预测)和图级(Motif预测)的辅助属性分类任务。

混合方法整合了多种自监督任务,可以达到单个方法所不具备的效果,然而不同任务之间可能存在冲突,如何有效平衡各个任务的贡献是一个挑战,未来可设计自适应的任务选择和组合机制,动态地选择最优任务组合。

5 图自监督学习在医学影像上的应用除了在图数据挖掘中有着广泛的应用之外,图自监督学习在医学影像处理领域也展现出了巨大的潜力。许多医学数据样本之间都存在一定关联,这些关联能够帮助机器学习模型做出更加准确的预测。例如,人的大脑中存在很多脑区,每个脑区之间又存在不同的联系,传统的图像方法很难建模这种关系,继而无法考虑脑区之间的相互影响和因果关系,而且医学图像领域样本标签也难以获取。因此,最近有许多研究利用图自监督学习建模各个样本之间的联系,从而促进了医学影像分析的发展。下面介绍当前比较先进的图自监督学习在医学影像分析上的应用。

5.1 对抗图对比学习在功能磁共振成像(FMRI) 中的应用一般来说,使用图学习的方法需要定义一个图,而医学影像中往往不直接含有图结构,因此,将图自监督学习应用到医学影像的第一步都是定义构图的方法。A-GCL[81]的构图流程非常经典:给定FMRI数据,将每个感兴趣区域(ROI)都视为图的节点,通过计算每两个ROI的血氧水平依赖性(BOLD)平均时间序列的皮尔逊(Pearson)相关系数得到边的权重。节点特征源自BOLD中低频波动振幅(ALFF)的3个频段,分别是Slow-5(0.01-0.027 Hz)、Slow-4(0.027-0.073 Hz)和Classical(0.01-0.08 Hz)。

A-GCL首先将脑网络经过一个图同构网络编码得到新的特征;然后,将每条边两端的特征拼接,得到每条边的特征$\tilde{x}_{u v}=\left[\tilde{x}_u; \tilde{x}_v\right] \in \mathbb{R}^{2 d}$;最后,使用多层感知机(MLP)将边的特征降为一维,这样,边缘特征被转换成一个标量,该标量对应于伯努利分布的参数,进一步从伯努利分布中采样便可以得到一个增强的图$\tilde{\mathcal{G}}$。A-GCL主要关注的问题是图分类,也就是对每一个患者分类,所以使用读出函数将每个节点的特征相加,使得每个图能得到一个向量表示$z(\mathcal{G})$, $z(\tilde{\mathcal{G}}) \in \mathbb{R}^d$。为了训练特征提取器和图增强过程中的参数,在一个批次中,如果两个特征向量来自相同的图,则迫使它们接近;如果它们来自不同的图,则迫使它们远离,具体操作公式为

| $ \begin{gathered} I(z, \mu ; \mathcal{B})= \\ \frac{1}{|\mathcal{B}|} \sum\limits_{\mathcal{G} \in \mathcal{B}} \log \frac{\exp (\operatorname{sim}(\boldsymbol{z}(\mathcal{G}), \boldsymbol{z}(\tilde{\mathcal{G}})))}{\sum\limits_{\mathcal{G} \in \mathcal{B} \backslash \mathcal{G}} \exp \left(\operatorname{sim}\left(\boldsymbol{z}(\mathcal{G}), \boldsymbol{z}\left(\tilde{\mathcal{G}}^{\prime}\right)\right)\right)},\end{gathered} $ | (27) |

这里$\mathcal{B}$ 代表批次。为了使提取的特征在图上是平滑变化的,A-GCL提出跨批次记忆库损失函数来使得增强的图结构不会变化太大。

5.2 图自监督学习在脑网络分析中的应用BrainGSL[82]同样是针对脑网络的FMRI数据,与A-GCL的主要区别就是将代理任务替换为图重构。首先,通过Pearson相关系数的方式构造图结构; 其次,利用图自掩码的方式来预训练模型; 再次,随机掩盖节点的特征,通过GCN的消息传递,利用未被掩盖特征的节点来复原被掩盖的节点特征;最后,利用节点的特征矩阵做内积得到重构的图结构,目标函数则最小化重构图结构和原图结构的距离,即

| $ \mathcal{L}_{\mathrm{MGAE}}=\|A-\hat{A}\|_2^2, $ | (28) |

其中,$\hat{A}$是重构的图结构。在预训练得到节点表示后,为挖掘BOLD信号中的时间信息,作者使用了Transformer来提取BOLD序列中的时序特征,而每个节点的特征就是由预训练得到的节点特征和Transformer提取的特征结合得来。

5.3 图自监督学习探索脑功能结构连接体骨架技术目前,对人体脑网络的研究还存在着一些不足,不同大脑区域在结构和功能整合中的重要性尚未充分了解。最近,TSGR[83]提出了一种基于图重构的重要脑区识别模型,且TSGR的构图方式区别于其他方法,其计算所有ROI之间信号的Pearson相关系数,得到函数相似矩阵,并将其作为图节点的特征矩阵,此特征矩阵是TSGR的邻接矩阵。计算邻接矩阵直接连接的纤维总数,然后除以其面积的几何平均值,就可以得到结构连通性矩阵并用于图自监督学习。

TSGR提出了新的编码器结构UGformer。首先用自注意力机制来获取全局信息,然后使用GCN卷积来卷积局部信息:

| $ \begin{aligned} & \quad H^{\prime(k)}=\text {Attention}_V \\ & \left(H^{(k)} \boldsymbol{Q}^{(k)}, H^{(k)} \boldsymbol{K}^{(k)}, H^{(k)} \boldsymbol{V}^{(k)}\right) H^{(k+1)}= \\ & \operatorname{GCN}\left(E, H^{\prime(k)}\right), \end{aligned} $ | (29) |

其中, Q =XWQ, K =XWK, V =XWV,是计算注意力需要使用的投影矩阵,WQ、WK、WV为模型可以学习的参数。其次,TSGR利用一个MLP层将表示降为一维,则得到了每个样本(脑区)的重要性分数,并将分数和每个脑区的特征相乘去重构邻接矩阵。最后,可以通过重要性分数来识别重要脑区。

5.4 基于时序图自监督学习的标签高效的FMRI分析由于FMRI分析对于滑动窗的大小非常敏感,故GATE[84]提出2种图增强方法,分别是相邻窗口增强(S-A)和多尺度窗口增强(M-A)。S-A首先随机选取一个子窗口,然后利用Pearson相关系数构图得到第1个视图,并在这个子窗口的相邻窗口构图得到第2个视图;M-A考虑到不同窗口大小生成的图结构信息的相关性,因此将2个不同尺度的滑动窗口作为2个相关视图。对于得到的2个视图,GATE采用GCN作为编码器来获得每个节点的嵌入。在目标函数的设计上,传统的对比损失不适合脑网络中样本数量有限、类数量少的情况。因此,GATE提出输入一致性(Input-consistency)正则化:

| $ \begin{aligned} & \quad \mathcal{L}=-\frac{1}{N} \sum_{i=1}^N \frac{\left\langle\boldsymbol{z}_i^a, \boldsymbol{z}_i^b\right\rangle}{\left\|\boldsymbol{z}_i^a\right\|\left\|\boldsymbol{z}_i^b\right\|}+\gamma \sum_{v=a, b} \|\left(\boldsymbol{Z}^v\right)^{\mathrm{T}} \boldsymbol{Z}^v- \\ & \boldsymbol{I} \|_F^2, \end{aligned} $ | (30) |

式子第1项可以看作是嵌入特征的正则化,保证了低维特征能够保持表示能力;第2项确保特征的各个维度是不相关的,以避免解崩溃,即模型的所有输出都是相等的。

5.5 基于图自监督学习的医学影像分析在医学影像分析中,由于受试者的身体、机器类型和操作协议的差异,原始图像的尺寸在扫描期间可能会有所不同。但是,现有的基于视觉的方法往往依赖固定的图像输入,因此Sun等[85]提出了基于图自监督学习的方法,通过受试者图像和图谱图像之间的解剖对应关系来了解图结构。具体来说,该方法将患者的肺部CT图像视为一组节点,其中的节点对应于覆盖患者肺部区域的图像块,通过解剖对应关系来建立边,其目标函数就是对每一个图像块在经过GCN编码之后的表示进行对比学习损失(InfoNCE损失)。

6 展望尽管自监督学习最近在自然语言处理和计算机视觉方面取得了成功,但是应用于图数据的自监督学习仍然是一个新兴领域,需要迎接重大挑战。未来,图自监督学习的研究应从以下4个方面入手。

6.1 高质量的对比学习方法生成视图对比学习方法学习到的表示很大程度上取决于生成视图的质量,最佳视图生成还取决于特定的下游任务。然而,即使每个下游任务是可用的,目前仍然无法获得每个下游任务的最佳视图。现有的大多数图增强都考虑屏蔽/随机重排节点特征、修改边或其他替代方法,但这些方法在生成多个视图时只提供有限的多样性和不确定的不变性。为了弥补差距,如何自适应地执行图增强、如何自动选择增强或通过挖掘丰富的底层结构和属性信息来联合考虑更强的增强样本,将是未来研究的一个有趣方向。

6.2 可扩展的图对比方法现有方法的编码器都是采用GCN。当扩展到更大的图时,现有的许多图自监督方法在时间消耗方面存在内存需求过大问题和计算效率低下问题。对于图对比方法,模型的延展性变得更加关键,因为它们的性能通常依赖于整个图的节点,随着视图和图规模的增加,计算时间会急剧增加。因此,如何优化对比损失或者编码阶段来提高模型在大规模图上的效率是一个亟待解决的重要问题。

6.3 图自监督学习的可解释性研究在多种应用场景下,GNN的可解释性是保证GNN模型可靠性和安全性的关键。例如,在药物发现中,了解分子图中哪些官能团主要影响了GNN是很重要的。然而,现有的最先进的研究侧重于监督设置下的解释,该解释需要依赖于下游任务,并且只有有限的方法可以在不给定下游预测头的情况下解释预训练的GNN。在图自监督学习的可解释方面,还需要更多的研究。

6.4 异质图自监督学习的研究异质图广泛存在于现实世界中,例如用户-物品的购买关系图、电影-演员-导演的关系图等,其相对于同质图有着不同类别的节点和边,是更复杂的图结构。传统的图自监督方法无法直接应用在异质图上,如何设计一个适合异质图的代理任务是一个有趣且有希望突破的研究方向。

| [1] |

KIPF T N, WELLING M. Semi-supervised classification with graph convolutional networks [C/OL]. International Conference on Learning Representations, 2017. https://openreview.net/forum?id=SJU4ayYgl.

|

| [2] |

HAMILTON W L, YING R, LESKOVEC J. Inductive representation learning on large graphs [C]//NIPS'17: Proceedings of the 31st International Conference on Neural Information Processing Systems. [S. l. : s. n. ], 2017.

|

| [3] |

XU K, HU W, LESKOVEC J, et al. How powerful are graph neural networks?[C/OL]. International Conference on Learning Representations, 2019. https://openreview.net/forum?id=ryGs6iA5Km.

|

| [4] |

HUANG J, DU L, CHEN X, et al. Robust mid-pass filtering graph convolutional networks [C]//Proceedings of the ACM Web Conference 2023. New York: ACM, 2023: 328-338.

|

| [5] |

张茜, 孙一佳, 白琳, 等. 面向同源蛋白质探测的一种新型混合深度学习模型[J]. 广西科学, 2019, 26(3): 283-290. DOI:10.13656/j.cnki.gxkx.20190618.009 |

| [6] |

王永贵, 赵晓暄. 结合自监督学习的图神经网络会话推荐[J]. 计算机工程与应用, 2023, 59(3): 244-252. |

| [7] |

陈蓉, 孙剑, 徐宗本. 彩色图像分割中基于图上半监督学习算法研究[J]. 西安交通大学学报, 2011, 45(2): 11-14, 20. |

| [8] |

代雨柔, 杨庆, 张凤荔, 等. 基于自监督学习的社交网络用户轨迹预测模型[J]. 计算机应用, 2021, 41(9): 2545-2551. |

| [9] |

殷瑞刚, 魏帅, 李晗, 等. 深度学习中的无监督学习方法综述[J]. 计算机系统应用, 2016, 25(8): 1-7. |

| [10] |

MIKOLOV T, CHEN K, CORRADO G, et al. Efficient estimation of word representations in vector space [C/OL]. International Conference on Learning Representations, 2013. https://openreview.net/forum?id=idpCdOWtqXd60.

|

| [11] |

ZENG A, LIU X, DU Z, et al. Glm-130b: an open bilingual pre-trained model [C/OL]. International Conference on Learning Representations, 2023. https://openreview.net/forum?id=-Aw0rrrPUF.

|

| [12] |

HE K, FAN H, WU Y, et al. Momentum contrast for unsupervised visual representation learning [C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2020: 9729-9738.

|

| [13] |

CHEN T, KORNBLITH S, NOROUZI M, et al. A simple framework for contrastive learning of visual representations [C]//DAUMÉ H, SINGH A. ICML'20: Proceedings of the 37th International Conference on Machine Learning. [S. l. : s. n. ], 2020: 1597-1607.

|

| [14] |

GRILL J B, STRUB F, ALTCHÉ F, et al. Bootstrap your own latent: a new approach to self-supervised learning[C] //LAROCHELLE H, RANZATO M, HADSELL R, et al. NIPS'20: Proceedings of the 34th International Conference on Neural Information Processing Systems. Vancouver: [s. n. ], 2020: 21271-21284.

|

| [15] |

FEICHTENHOFER C, FAN H, LI Y, et al. Masked autoencoders as spatiotemporal learners [C]//KOYEJO S, MOHAMED S, AGARWAL A, et al. NIPS'22: Proceedings of the 36th International Conference on Neural Information Processing Systems. New Orleans: [s. n. ], 2022, 35: 35946-35958.

|

| [16] |

LIU Y, JIN M, PAN S, et al. Graph self-supervisedlearning: a survey[J]. IEEE Transactions on Knowledge and Data Engineering, 2022, 35(6): 5879-5900. |

| [17] |

WANG C, PAN S, LONG G, et al. Mgae: marginalized graph autoencoder for graph clustering [C]//SANDERSON M, FU A, SUN J. CIKM'17-Proceedings of the 2017 ACM Conference on Information and Knowledge Management. New York: ACM, 2017: 889-898.

|

| [18] |

PAN S, HU R, LONG G, et al. Adversarially regularized graph autoencoder for graph embedding [Z/OL]. (2019-01-08)[2023-12-17]. https://arxiv.org/abs/1802.04407v2.

|

| [19] |

KIPF T N, WELLING M. Variational graph auto-encoders [Z/OL]. (2016-11-21)[2023-12-17]. https://arxiv.org/abs/1611.07308.

|

| [20] |

HASANZADEH A, HAJIRAMEZANALI E, NARA-YANAN K, et al. Semi-implicit graph variational auto-encoders [C]//WALLACH H, LAROCHELLE H, BEYGELZIMER A, et al. Advances in Neural Information Processing Systems 32(NeurIPS 2019). [S. l. : s. n. ], 2019.

|

| [21] |

KIM D, OH A. How to find your friendly neighbor-hood: graph attention design with self-supervision [Z/OL]. (2022-04-11)[2023-12-20]. https://arxiv.org/abs/2204.04879.

|

| [22] |

HWANG D, PARK J, KWON S, et al. Self-supervised auxiliary learning with meta-paths for heterogeneous graphs[J]. Advances in Neural Information Processing Systems, 2020, 33: 10294-10305. |

| [23] |

SUN K, LIN Z, ZHU Z. Multi-stage self-supervisedlearning for graph convolutional networks on graphs with few labeled nodes[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(4): 5892-5899. DOI:10.1609/aaai.v34i04.6048 |

| [24] |

HU Z, KOU G, ZHANG H, et al. Rectifying pseudo labels: iterative feature clustering for graph representation learning [C]//Proceedings of the 30th ACM International Conference on Information & Knowledge Management. New York: ACM, 2021: 720-729.

|

| [25] |

BO D, WANG X, SHI C, et al. Structural deep clustering network [C]//Proceedings of the Web Conference 2020. New York: ACM, 2020: 1400-1410.

|

| [26] |

HUANG Z, REN Y, PU X, et al. Self-supervised graph attention networks for deep weighted multi-view clustering [C]//Proceedings of the Thirty-Seventh AAAI Conference on Artificial Intelligence and Thirty-Fifth Conference on Innovative Applications of Artificial Intelligence and Thirteenth Symposium on Educational Advances in Artificial Intelligence. New York: ACM, 2023: 7936-7943.

|

| [27] |

ZHU Y, XU Y, YU F, et al. CAGNN: cluster-aware graph neural networks for unsupervised graph representation learning [Z/OL]. (2020-09-03)[2023-12-20]. https://arxiv.org/abs/2009.01674v1.

|

| [28] |

LOPES L T, PEDRONETTE D C G. Self-supervised clustering based on manifold learning and graph convolutional networks [C]//2023 IEEE/CVF Winter Conference on Applications of Computer Vision (WACV). Piscataway, NJ: IEEE, 2023: 5634-5643.

|

| [29] |

PENG Z, DONG Y, LUO M, et al. Self-supervisedgraph representation learning via global context prediction [Z/OL]. (2020-03-03)[2023-12-20]. https://arxiv.org/abs/2003.01604v1.

|

| [30] |

JIN W, DERR T, LIU H, et al. Self-supervised learningon graphs: deep insights and new direction [Z/OL]. (2020-06-17)[2023-12-20]. https://arxiv.org/abs/2006.10141v1.

|

| [31] |

PATHAK D, KRAHENBUHL P, DONAHUE J, et al. Context encoders: feature learning by inpainting [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2016: 2536-2544.

|

| [32] |

杜航原, 郝思聪, 王文剑. 结合图自编码器与聚类的半监督表示学习方法[J]. 计算机应用, 2022, 42(9): 2643-2651. |

| [33] |

TAN Q, LIU N, HUANG X, et al. S2GAE: self-supervised graph autoencoders are generalizable learners with graph masking [C]//Proceedings of the Sixteenth ACM International Conference on Web Search and Data Mining. New York: ACM, 2023: 787-795.

|

| [34] |

RONG Y, BIAN Y, XU T, et al. Self-supervised graph transformer on large-scale molecular data [C]//Proceedings of the 34th International Conference on Neural Information Processing Systems. New York: ACM, 2020: 12559-12571.

|

| [35] |

JIN W, DERR T, WANG Y, et al. Node similarity preserving graph convolutional networks [C]//Proceedings of the 14th ACM International Conference on Web Search and Data Mining. New York: ACM, 2021: 148-156.

|

| [36] |

HU Z, DONG Y, WANG K, et al. GPT-GNN [C]//Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. New York: ACM, 2020: 1857-1867.

|

| [37] |

ZHANG X, LIU H, LI Q, et al. Attributed graph clustering via adaptive graph convolution [Z/OL]. (2019-06-04)[2024-01-03]. https://arxiv.org/abs/1906.01210v1.

|

| [38] |

CARON M, BOJANOWSKI P, JOULIN A, et al. Deep clustering for unsupervised learning of visual features [C]//Computer Vision-ECCV 2018: 15th European Conferenc. Cham: Springer International Publishing, 2018: 139-156.

|

| [39] |

YANG L, SHI R, ZHANG Q, et al. Self-supervised graph neural networks via low-rank decomposition [C]//Proceedings of the 37th International Conference on Neural Information Processing Systems. New York: ACM, 2023: 34295-34307.

|

| [40] |

KANG Z, LIN Z, ZHU X, et al. Structured graph learning for scalable subspace clustering: from single view to multiview[J]. IEEE Transactions on Cybernetics, 2021, 52(9): 8976-8986. |

| [41] |

LIN Z, KANG Z, ZHANG L, et al. Multi-view attributed graph clustering[J]. IEEE Transactions on Knowledge and Data Engineering, 2021, 35(2): 1872-1880. |

| [42] |

TU W, ZHOU S, LIU X, et al. Deep fusion clustering network[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2021, 35(11): 9978-9987. DOI:10.1609/aaai.v35i11.17198 |

| [43] |

HE X, WANG B, HU Y, et al. Parallelly adaptive graph convolutional clustering model[J]. IEEE Transactions on Neural Networks and Learning Systems, 2024, 35(4): 4451-4464. |

| [44] |

YI S, JU W, QIN Y, et al. Redundancy-free self-supervised relational learning for graph clustering [J]. IEEE Transactions on Neural Networks and Learning Systems, 2023: PP. DOI: 10.1109/TNNLS.2023.3314451.

|

| [45] |

YOU Y, CHEN T, WANG Z, et al. When does self-supervision help graph convolutional networks? [C]// DAUMÉ H, SINGH A. ICML'20: Proceedings of the 37th International Conference on Machine Learning. [S. l. : s. n. ], 2020: 10871-10880.

|

| [46] |

MANESSI F, ROZZA A. Graph-based neural network models with multiple self-supervised auxiliary tasks[J]. Pattern Recognition Letters, 2021, 148: 15-21. |

| [47] |

YUAN J, YU H, CAO M, et al. Self-supervised robust Graph Neural Networks against noisy graphs and noisy labels[J]. Applied Intelligence, 2023, 53(21): 25154-25170. |

| [48] |

HU Z, FAN C, CHEN T, et al. Pre-training graph neural networks for generic structural feature extraction [Z/OL]. (2019-05-31)[2024-01-03]. https://arxiv.org/abs/1905.13728v1.

|

| [49] |

VELIC[DD(][XCd. tif][DD)]KOVIC[DD(][XCe. tif][DD)] P, FEDUS W, HAMILTON W L, et al. Deep graph infomax [Z/OL]. (2018-12-21)[2024-01-03]. https://arxiv.org/abs/1809.10341.

|

| [50] |

HASSANI K, KHASAHMADI A H. Contrastive multi-view representation learning on graphs [C/OL]// Proceedings of the 37 th International Conference on Machine Learning, 2020: 4116-4126. http://proceedings.mlr.press/v119/hassani20a/hassani20a.pdf.

|

| [51] |

SUN F Y, HOFFMANN J, VERMA V, et al. Info-Graph: unsupervised and semi-supervised graph-level representation learning via mutual information maximization [Z/OL]. (2020-06-17)[2024-01-03]. https://arxiv.org/abs/1908.01000v3.

|

| [52] |

PENG Z, HUANG W, LUO M, et al. Graph representation learning via graphical mutual information maximization [C]//Proceedings of The Web Conference 2020. New York: ACM, 2020: 259-270.

|

| [53] |

YOU Y, CHEN T, SUI Y, et al. Graph contrastive learning with augmentations [C]//LAROCHELLE H, RANZATO M, HADSELL R, et al. NIPS'20: Proceedings of the 34th International Conference on Neural Information Processing Systems. [S. l. : s. n. ], 2020: 5812-5823.

|

| [54] |

ZHU Y, XU Y, YU F, et al. Deep graph contrastive representation learning [Z/OL]. (2020-07-13)[2024-01-03]. https://arxiv.org/abs/2006.04131v2.

|

| [55] |

QIU J, CHEN Q, DONG Y, et al. GCC: graph contrastive coding for graph neural network pre-training [C]//Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. New York: ACM, 2020: 1150-1160.

|

| [56] |

SOHN K, SOHN K. Improved deep metric learning with multi-class N-pair loss objective [C]//Proceedings of the 30th International Conference on Neural Information Processing Systems. New York: ACM, 2016: 1857-1865.

|

| [57] |

LI B, JING B, TONG H, et al. Graph communal contrastive learning [C]//Proceedings of the ACM Web Conference 2022. New York: ACM, 2022: 1203-1213.

|

| [58] |

JIAO Y, XIONG Y, ZHANG J, et al. Sub-graph contrast for scalable self-supervised graph representation learning [C]//2020 IEEE International Conference on Data Mining (ICDM). Piscataway, NJ: IEEE, 2020: 222-231.

|

| [59] |

RENDLE S, FREUDENTHALER C, GANTNER Z, et al. BPR: bayesian personalized ranking from implicit feedback [Z/OL]. (2012-05-09)[2024-01-03]. https://arxiv.org/abs/1205.2618v1.

|

| [60] |

MO Y, CHEN Y, LEI Y, et al. Multiplex graph representation learning via dual correlation reduction[J]. IEEE Transactions on Knowledge and Data Engineering, 2023, 35(12): 12814-12827. |

| [61] |

GASTEIGER J, WEIßENBERGER S, GVNNEMANN S. Diffusion improves graph learning [C]//WALLACH H M, LAROCHELLE H, BEYGELZIMER A, et al. Proceedings of the 33rd International Conference on Neural Information Processing Systems. [S. l. : s. n. ], 2019: 13366-13378.

|

| [62] |

ZHU Y, XU Y, YU F, et al. Graph contrastive learning with adaptive augmentation [C]//Proceedings of the Web Conference 2021. New York: ACM, 2021: 2069-2080.

|

| [63] |

LIU Y, ZHENG Y, ZHANG D, et al. Towards unsupervised deep graph structure learning [C]//Proceedings of the ACM Web Conference 2022. New York: ACM, 2022: 1392-1403.

|

| [64] |

LI Z, YUAN F, CAO C, et al. Self-supervised deep heterogeneous graph neural networks with contrastive learning [C]// Computational Science-ICCS 2023. Cham: Springer Nature Switzerland, 2023: 268-282.

|

| [65] |

PARK J, SONG J, YANG E. Graphens: neighboraware Ego network synthesis for class-imbalanced node classification [C]//10th International Conference on Learning Representations, ICLR 2022. [S. l. : s. n. ], 2022.

|

| [66] |

KIM D, JINHEON B, HWANG S J. Graph self-super-vised learning with accurate discrepancy learning [C]// KOYEJO S, MOHAMED S, AGARWAL A, et al. Advances in Neural Information Processing Systems 35: Annual Conference on Neural Information Processing Systems 2022, NeurIPS 2022. [S. l. : s. n. ], 2022, 35: 14085-14098.

|

| [67] |

LIU Y, ZHENG Y, ZHANG D, et al. Beyond smoo-thing: unsupervised graph representation learning with edge heterophily discriminating[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2023, 37(4): 4516-4524. |

| [68] |

WEI C, WANG Y, BAI B, et al. Boosting graph contrastive learning via graph contrastive saliency [C]//Proceedings of the 40th International Conference on Machine Learning. New York: ACM, 2023: 36839-36855.

|

| [69] |

WU Y, WANG L, HAN X, et al. Graph contrastive learning with cohesive subgraph awareness [C]//CHUA T, NGO C. WWW'24: Proceedings of the ACM Web Conference 2024. New York: Association for Computing Machinery, 2024: 629-640.

|

| [70] |

MO Y, PENG L, XU J, et al. Simple unsupervised graph representation learning[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2022, 36(7): 7797-7805. |

| [71] |

LI Y, VINYALS O, DYER C, et al. Learning deep generative models of graphs [Z/OL]. (2018-03-08)[2024-01-03]. https://arxiv.org/abs/1803.03324v1.

|

| [72] |

ZENG H, ZHOU H, SRIVASTAVA A, et al. Graph-SAINT: graph sampling based inductive learning method [C]//8th International Conference on Learning Representations, ICLR 2020. [S. l. : s. n. ], 2020.

|

| [73] |

THAKOOR S, TALLEC C, AZAR M G, et al. Large-scale representation learning on graphs via bootstrapping [C]//International Conference on Learning Representation, ICLR 2022. [S. l. : s. n. ], 2022.

|

| [74] |

GRILL J B, STRUB F, ALTCHÉ F, et al. Bootstrap your own latent a new approach to self-supervised learning [C]//Proceedings of the 34th International Conference on Neural Information Processing Systems. New York: ACM, 2020: 21271-21284.

|

| [75] |

ZHANG H, WU Q, YAN J, et al. From canonical correlation analysis to self-supervised graph neural networks [C]//Proceedings of the 35th International Conference on Neural Information Processing Systems. New York: ACM, 2021: 76-89.

|

| [76] |

XIE Y, XU Z, JI S. Self-supervised representation learning via latent graph prediction [C]//Proceedings of the 39th International Conference on Machine Learning. [S. l. : s. n. ], 2022: 24460-24477.

|

| [77] |

HU Z, DONG Y, WANG K, et al. GPT-GNN: generative pre-training of graph neural networks [C]//KDD'20: Proceedings of the 26th ACM SIGKDD international conference on knowledge discovery & data mining. New York: Association for Computing Machinery, 2020: 1857-1867.

|

| [78] |

SINHA K, SODHANI S, PINEAU J, et al. GraphLog: a benchmark for measuring logical generalization in graph neural networks[C]//The Ninth International Conference on Learning Representations, ICLR 2021. [S. l. : s. n. ], 2021.

|

| [79] |

JING B, PARK C, TONG H, et al. HDMI: high-order deep multiplex infomax [C]//Proceedings of the Web Conference 2021. New York: ACM, 2021: 2414-2424.

|

| [80] |

RONG Y, BIAN Y, XU T, et al. Self-supervised graph transformer on large-scale molecular data [C]//Proceedings of the 34th International Conference on Neural Information Processing Systems. New York: ACM, 2020: 12559-12571.

|

| [81] |

ZHANG S, CHEN X, SHEN X, et al. A-GCL: adversarial graph contrastive learning for fMRI analysis to diagnose neurodevelopmental disorders[J]. Medical Image Analysis, 2023, 90: 102932. |

| [82] |

WEN G, CAO P, LIU L, et al. Graph self-supervised learning with application to brain networks analysis[J]. IEEE Journal of Biomedical and Health Informatics, 2023, 27(8): 4154-4165. |

| [83] |

KANG Y, WANG R, SHI E, et al. Exploring brain fun-ction-structure connectome skeleton via self-supervised graph-transformer approach[C]//GREENSPAN H, MADABHUSHI A. Medical Image Computing and Computer Assisted Intervention-MICCAI 2023: 26th International Conference. Cham: Springer Nature Switzerland, 2023: 308-317.

|

| [84] |

PENG L, WANG N, XU J, et al. GATE: graph CCA for temporal self-supervised learning for label-efficient fMRI analysis[J]. IEEE Transactions on Medical Imaging, 2022, 42(2): 391-402. |

| [85] |

SUN L, YU K, BATMANGHELICH K. Context matters: graph-based self-supervised representation learning for medical images[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2021, 35(6): 4874-4882. |