2. 广西科学院, 广西南宁 530007;

3. 中国通信服务股份有限公司广西技术服务分公司, 广西南宁 530000;

4. 广东财贸职业学院数字技术学院, 广东清远 511510;

5. 广西区域多源数据集成与智能处理协同创新中心, 广西桂林 541004;

6. 广西民族大学人工智能学院, 广西南宁 530006;

7. 广西壮族自治区南宁树木园, 广西南宁 530225

2. Guangxi Academy of Sciences, Nanning, Guangxi, 530007, China;

3. Guangxi Technical Service Company, China Communications Services Corporation Limited, Nanning, Guangxi, 530000, China;

4. College of Digital Technology, Guangdong Vocational College of Finance and Trade, Qingyuan, Guangdong, 511510, China;

5. Guangxi Regional Collaborative Innovation Center for Multi-Source Data Integration and Intelligent Processing, Guilin, Guangxi, 541004, China;

6. School of Artificial Intelligence, Guangxi Minzu University, Nanning, Guangxi, 530006, China;

7. Nanning Arboretum, Guangxi Zhuang Autonomous Region, Nanning, Guangxi, 530225, China

密集型小目标检测是指在图像中识别和定位大量小而密集分布的目标对象。随着深度学习技术的发展,密集型小目标检测在计算机视觉领域中具有广泛的应用价值,例如人群计数、交通流量分析、农作物检测等[1-3]。与传统的目标检测任务不同,密集型小目标检测任务中的待检测物体具有数量多、形状不规则、尺寸不统一、分布密集、像素数量较少等特点,这都对现有的检测技术如何准确地识别和定位图像中的多个小目标提出新的挑战。

从生成目标框的角度可以将现有的密集型小目标检测算法分为基于锚框(Anchor-based)检测和无锚框(Anchor-free)检测两类。基于锚框的检测模型通过产生密集的锚框以生成高质量的候选区域,通常具有较高的准确性。如杨攀等[4]提出一种基于Mask R-CNN(Mask Region-based Convolutional Neural Network)的木材分割方法,能适应各种场景下的各尺寸大小密集木材检测分割任务。霍爱清等[5]通过改进YOLOv3(You Only Look Once version 3)算法,解决车辆密集场景中检测目标重叠率高而导致的漏检、误检问题。基于锚框的目标检测模型需要人工设定锚框和依靠RPN[6](Region Proposal Network)网络生成候选框,导致模型更依赖于先验知识而缺乏泛化能力。基于无锚框的目标检测方法不依赖锚框就能直接预测出边界框和目标类别,有效解决了由于预设固定尺度的锚框导致模型在检测尺寸或纵横比显著差异的物体时性能不佳的问题。因此,基于无锚框的目标检测方法能够更好地完成密集场景下的目标检测任务。如Wu等[7]为了使用无人机检测密集的杏花,提出了密集目标检测方法D-YOLOv8,且改进后的网络可以有效地支持任何密集目标检测任务。此外,基于Transformer[8]的目标检测模型DETR[9],在没有预定义先验锚框和NMS(Non-Maximum Suppression)后处理策略的情况下能够实现端到端的目标检测。但是基于Transformer的检测模型计算成本较高,硬件资源消耗较大,一般的计算环境难以支撑其庞大的计算需求。综上,本研究选用基于CNN的无锚框检测算法作为研究基础。

FCOS[10]是基于无锚框的全卷积目标检测方法之一,其通过判断图像中每一个像素点的目标属性及其边界框的存在以完成目标定位任务,相比于其他基于无锚框的方法,FCOS无需频繁构建锚定点方案,节省训练所需的内存,提高速度和检测性能,能有效地处理各种大小和形状不同的目标。具体而言,首先FCOS网络在骨干网络(Backbone)以卷积的计算方式对输入图像进行特征提取,在不同阶段得到不同尺度的特征图;其次在特征金字塔网络(Feature Pyramid Network,FPN)[11]中将提取到的高级语义特征上采样后与低级特征进行融合;最后分别对融合得到的不同尺度的特征在检测头(Head)部分进行逐像素的目标分类与边界框回归。Nayak等[12]在无人机检测任务中验证了FCOS识别小目标的性能;Fu等[13]在苎麻植株数量检测中发现FCOS与其他模型相比更适合在复杂情况下识别小物体作物。

尽管基于FCOS的改进工作已经取得了不错的进展,但是仍存在以下两个问题:①FCOS中用于特征提取的Backbone均由传统卷积层下采样堆叠而成。由于卷积是固定感受野下的局部操作,难以高效地挖掘图像的全局上下文特征,因此现有的解决方案是在Backbone中引入注意力机制[14-16]。但是这些注意力机制仅局限于对通道、空间、局部或全局等单个方面进行特征关注,而缺少任何一方面的信息都有可能导致网络的精度不高和泛化性不足。同时,传统自注意力机制的引入也容易使模型过于关注全局信息而忽略局部信息,缺乏对语义信息的提取,且计算成本的增加也是不可忽视的问题。②FCOS特征融合模块由传统的FPN架构组成,现有大部分针对基于FPN的改进工作仍保留着传统卷积的融合方法[17-20]。传统卷积是利用固定长宽比的滑动窗口在特征图上进行滑动计算,然而这种计算方式在对密集且不规则的物体进行检测时容易丢失描述目标信息的像素点,忽略可能仅存在于特定级别的关键细节,导致信息丢失和特征提取不完整,使得传统FPN不能很好地适应密集场景下的特征融合。

综上所述,针对传统FCOS难以在复杂背景中提取到丰富的全局上下文特征,以及在密集、形状不一、尺寸不一致的物体检测场景下容易出现漏检、错检和重检的问题,本研究提出了基于多尺度特征提取的密集型小目标检测网络(Intensive small target detection network based on Multi-Scale feature Extraction,IMSE)。IMSE主要包含两个模块:多尺度特征增强(Multi-scale Feature Enhancement,MFE)模块和可变形卷积[21]特征金字塔网络(Deformable Convolutional Feature Pyramid Network,DCFPN)结构,其中MFE模块包括窗口注意力(Window Attention,WA)模块和多尺度信息融合(Multi-scale Information Fusion,MIF)模块两部分。首先,WA模块在特征提取阶段加入了多尺度注意力机制,引导网络更全面地学习图像的特征信息;然后,MIF模块通过将输入特征图并行经过一系列卷积和池化操作,指导网络在更多维度上融合图像特征,捕捉特征元素的全局和上下文信息; 最后,通过DCFPN结构使网络在特征融合阶段能够更好地融合MFE模块的输出特征,提高模型对形状不规则、分布无规律的物体特征的表征能力。

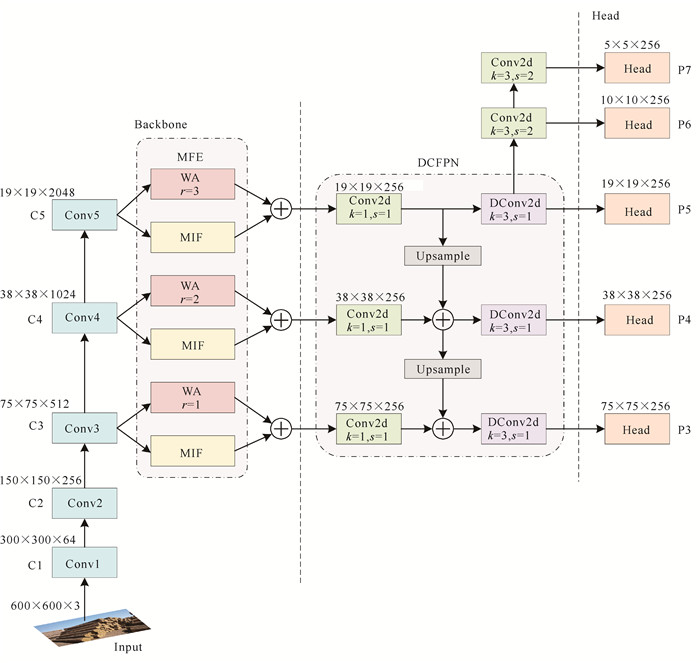

1 模型与方法本研究提出的IMSE总体架构如图 1所示。IMSE由3部分组成:骨干网络、DCFPN结构和检测头。首先,IMSE使用ResNet-101作为骨干网络进行特征提取,与FCOS网络结构相比,IMSE在骨干网络的输出层C3、C4和C5后添加MFE模块,将骨干中生成的不同分辨率的特征图分别输入WA模块和MIF模块进行特征提取,引导网络更全面地关注全局上下文信息,提高网络在特征提取阶段的多尺度表达能力;然后,将WA模块和MIF模块得到的特征进行相加融合,并将融合后的特征输入DCFPN结构,DCFPN结构引入可变形卷积来融合语义和不同尺度的特征,从而保留更多的语义信息,生成多尺度特征图作为输出;最后,DCFPN结构输出的特征和传统FPN结构的两个标准卷积层被分别输入到每一个检测头中,进行分类与边界框的回归任务。

|

| 图 1 IMSE结构 Fig. 1 Structure of IMSE |

1.1 MFE模块

MFE模块由WA模块和MIF模块构成。WA模块利用自注意力机制在不同尺度上提取空间特征,使模型更好地理解全局上下文的语义信息,捕捉到长距离的语义依赖关系,理解不同尺度的特征之间的相互关系,提高模型的表达能力。MIF模块通过不同大小的卷积和全局池化操作,实现局部空间的多尺度特征和通道特征的提取及深度融合,进一步挖掘图像的轮廓、纹理、颜色和边缘等更加丰富的细节信息。最终,相加融合WA模块和MIF模块提取的特征能够在全局和局部、空间和通道以及语义和定位上全面地学习和理解图像特征,达到特征增强的效果。

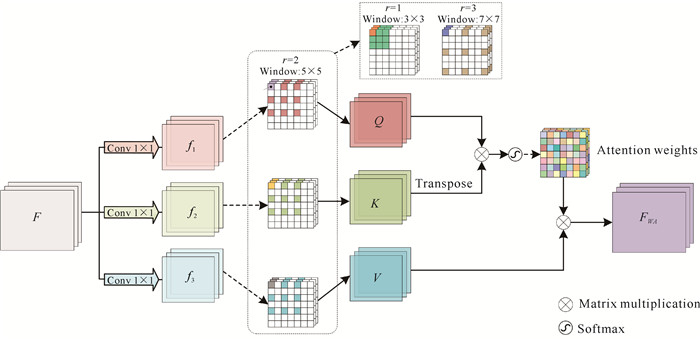

1.1.1 WA模块为了在含有遮挡或较多干扰噪声的复杂环境下有效地检测小目标,本研究设计WA模块以加强全局上下文联系,提高网络对目标的精确定位和识别能力。WA模块能够在传统的目标检测特征提取阶段,通过引入多尺度自注意力机制增强特征。但自注意力机制的3个参数Q、K、V的计算需要消耗较大的计算资源。为了降低计算代价,本研究设计分段计算Q、K、V的算法Seg_QKV。Seg_QKV利用大小为ω×ω的窗口遍历输入的特征图,在遍历过程中每读取一个窗口的特征子图,就计算对应的权重矩阵(Qω、Kω、Vω)。遍历完成后,将所有的特征子图进行拼接,得到整张特征图的自注意力参数(Q, K, V)。同时,为了更好地关注多尺度特征,本研究在设计窗口时引入了空洞卷积[22]的思想,通过设置不同的空洞系数,得到不同大小的窗口,获得不同尺度的注意力权重。WA模块的结构如图 2所示。

|

| The input feature F corresponds to the C[i]-layer output feature map in the backbone network, where i∈3, 4, 5, and FWA represent the output of the module. 图 2 WA模块结构 Fig. 2 Structure of WA module |

以滑动窗口大小5×5为例,WA模块分两步执行,第一步是窗口注意力参数Q、K、V计算,第二步是进行多尺度特征提取。本研究使用两个算法来实现WA模块,一是分段计算Q、K、V的算法Seg_QKV,二是多尺度注意力计算算法MSa。

① 分段计算Q、K、V算法Seg_QKV

该部分借鉴了卷积操作中的滑动窗口思想,利用滑动窗口的形式对特征图进行提取,将自注意力的计算限制在滑动窗口内进行计算,从而达到快速计算的效果,具体流程如算法1所示。

算法 1 Seg_QKV

输入:特征图F=[H, W, C],滑动窗口大小ω×ω,滑动步长S

输出:权重矩阵Qω, Kω, Vω

1:Qω=[] , Kω=[], Vω=[];

2:for i=1 to 3 do

3: fi=Conv(1×1, F); //表示对F进行1×1卷积操作

4:end for

5:for i=1 to C do

6: for a=1 to (W-ω) do //a表示滑动窗口在特征图F上左上角横坐标

7: for b=1 to (H-ω) do //b表示滑动窗口在特征图F上左上角纵坐标

8: WinabQ=fab1[K, K, 1];

//WinabQ表示左上角坐标为(a, b)的K×K窗口在特征图f1上所提取到的特征图,其特征维度为[K, K, 1]

9: Qω=Concat (Qω, WinabQ);

10: WinabK=fab2[K, K, 1];

11: Kω=Concat(Kω, WinabK);

12: WinabV=fab3[K, K, 1];

13: Vω=Concat (Vω, WinabV);

14: b=b+S;

15: end for

16: a=a+S;

17: end for

18:end for

19:return Qω, Kω, Vω

② 多尺度注意力计算算法MSa

空洞卷积是在增加感受野的同时保持特征图尺寸不变的操作,弥补了特征图在缩小和放大过程中造成的信息损失,同时通过改变扩张率可以增加感受野。通过不同的空洞系数可得到不同大小的滑动窗口,然后对特征图进行特征提取,从而达到多尺度的效果,具体流程如算法2所示,该算法名为MSa(Multi-Scale attention)。考虑特征提取的局部性与全局性,所采用的空洞系数分别为1、2、3,滑动步长均为1。

算法 2 MSa

输入:特征图序列F=(F1, F2, …, Fn),空洞系数D=(D1, D2, …, Dn),滑动步长S

输出:特征图序列FWA=(FWA[1], FWA[2], …, FWA[n])

1:for i=1 to n do //索引i对应空洞系数的取值,当前n取值3

2: Qi, Ki, Vi=Seg_QKV(Fi, Win[2Di+1], S); //Win[2Di+1]表示滑动窗口的大小为2di+1

3: FWA[i]=softmax(Qi KTi/$\sqrt{d_k}$)Vi; //dk表示Ki的维度

4:end for

5:return FWA

③ 关于算法SC时间复杂度与传统Q、K、V计算时间复杂度比较的讨论

传统的自注意力计算是将输入特征通过3个不同的线性投影层进行映射,从而得到Q、K、V3个特征矩阵,随后根据Softmax式进行注意力的计算。传统的自注意力计算公式如公式(1)所示:

| $ \text { Attention }(Q, K, V)=\operatorname{Softmax}\left(\frac{Q K^{\mathrm{T}}}{\sqrt{d_k}}\right) V, $ | (1) |

由式(1)可知,注意力的计算过程为矩阵相乘。假设Q、K、V3个特征矩阵大小为n行d列,滑动窗口大小为3×3,则传统自注意力的时间复杂度O1与本研究提出的WA模块注意力的时间复杂度O2的计算公式如下所示:

| $ O_1=O_{Q K^{\mathrm{T}}}+O_{\left(Q K^{\mathrm{T}}\right) V}, $ | (2) |

| $ O_{Q K^{\mathrm{T}}}=n \times d \times n=n^2 d, $ | (3) |

| $ O_{\left(Q K^{\mathrm{T}}\right) V}=n \times n \times d=n^2 d, $ | (4) |

其中,QKT与(QKT)V分别表示自注意力计算中矩阵Q、K相乘和矩阵Q、K相乘的结果与矩阵V相乘。由公式(2)至(4)可知,传统自注意力的时间复杂度O1=2n2d。

| $ O_2=O_{Q_{3 \times 3} K_{3 \times 3}^{\mathrm{T}}}+O_{\left(Q_{3 \times 3} K_{3 \times 3}^{\mathrm{T}}\right) V_{3 \times 3}}, $ | (5) |

| $ \begin{aligned} & \;\;\;\;\;\;\;\;O_{Q_{3 \times 3} K_{3 \times 3}^{\mathrm{T}}}=(d-2)(n-2) \times 3 \times 3 \times 3=27 \times \\ & (d-2)(n-2), \end{aligned} $ | (6) |

| $ \begin{aligned} & \;\;\;\;\;\;\;\;O_{\left(Q_{3 \times 3} K_{3 \times 3}^{\mathrm{T}}\right) V_{3 \times 3}}=(d-2)(n-2) \times 3 \times 3 \times 3= \\ & 27 \times(d-2)(n-2), \end{aligned} $ | (7) |

其中,Q3×3K3×3T表示滑动窗口大小为3×3时的矩阵Q、K相乘,(Q3×3K3×3T)V3×3表示滑动窗口大小为3×3时矩阵Q、K相乘的结果与矩阵V相乘。因为滑动窗口是以步长1在输入特征矩阵上进行滑动,因此(d-2)(n-2)表示滑动窗口在输入特征矩阵上的滑动次数,也代表着滑动窗口在输入特征矩阵上滑动结束后所得到的输出特征矩阵个数。由公式(5)至(7)可知,WA模块注意力的时间复杂度O2=54×(d-2)(n-2)。经过对比可知,O2 < O1,体现出WA模块的计算速度,解决了传统自注意力机制存在的计算复杂度高的问题。

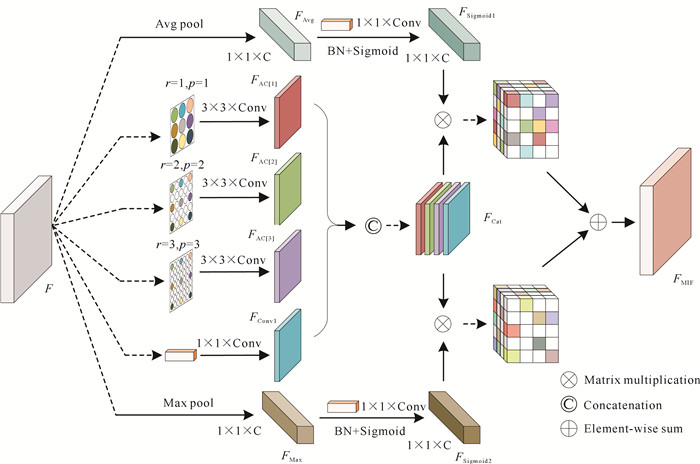

1.1.2 MIF模块特征图的空间信息包含物体位置信息,通道信息包含物体颜色信息,有效挖掘这两种信息对提高密集场景下小目标的检测性能至关重要。为解决现有注意力机制对特征信息关注不全面的问题,本研究提出MIF模块,结构如图 3所示。与WA模块利用多尺度注意力机制提取特征不同,MIF模块由一系列卷积和池化操作构成。池化操作只改变特征图的空间维度而不改变通道维度,能较好地突出特征图的通道特征。同时,利用多尺度空洞卷积、平均池化和最大池化对输入特征图进行并行操作,能更好地提取、融合特征图的空间与通道信息。拼接融合各部分的局部空间特征后,分别将其与经过归一化和激活操作后的通道特征进行矩阵相乘来获得权重矩阵,最后将权重矩阵相加融合,实现特征的深度融合。

|

| 图 3 MIF模块结构 Fig. 3 Structure of MIF module |

MIF模块的具体流程如算法3所示,其中输入特征F分别对应骨干网络中C3、C4和C5阶段的输出特征图,FAvg、FMax分别表示平均池化和最大池化后的输出特征,FAC[1]、FAC[2]、FAC[3]分别表示经过系数r为1、2、3的空洞卷积后的输出特征图,FConv1表示经过1×1卷积后的输出特征图,BN表示将通道特征进行归一化处理,FSigmoid1、FSigmoid2表示经过Sigmoid激活后得到的通道权重矩阵,FCat表示将经过卷积操作得到的不同感受野的特征图进行拼接,FMIF表示该模块的最终输出特征。

算法 3 MIF模块算法流程

输入:特征图序列F=(F1, F2, …, Fn)

输出:特征图序列FMIF=(FMIF[1], FMIF[2], …, FMIF[n])

1:for i=1 to n do

2: FAvg[i]=Avg(F[i]); //Avg(F[i])表示进行平均池化

3: for j=1 to n do

4: FAC[j]=AConv[j](3×3, F[i]); //表示进行核大小为3×3的空洞卷积

5: end for

6: FConv1[i]=Conv(1×1, F[i]);

7: FMax[i]=Max(F[i]); //Max(F[i])表示进行最大池化

8: FCat[i]=Concat(FAC[1], FAC[2], …, FAC[n], FConv1[i]); //在通道维度上进行拼接

9: FSigmoid1[i]=Sigmoid(BN (Conv(1×1, FAvg[i]))); //表示经过Sig-

moid函数激活

10: FSigmoid2[i]=Sigmoid(BN(Conv(1×1, FMax[i])));

11: FMIF[i]=FCat×FSigmoid1+FCat×FSigmoid2;

12:end for

13:return FMIF

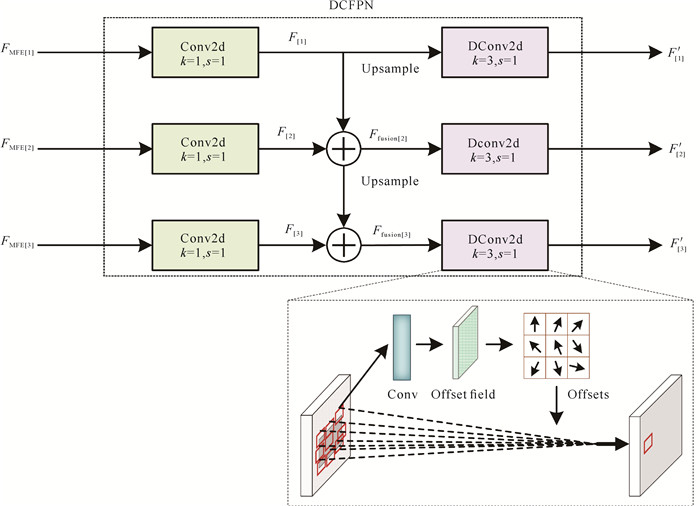

1.2 可变形卷积特征金字塔网络(DCFPN)结构传统的FPN在自上向下进行特征融合的过程中使用的是常规的卷积操作,但是固定的卷积核在对密集且不规则物体进行特征提取时,容易丢失一些包含物体局部信息的像素点,从而产生分类、回归不准确的问题。可变形卷积在常规卷积的基础上增加了空间偏移量,可以更好地适应图像中的空间变形。因此,本研究提出DCFPN结构,通过将可变形卷积融入特征金字塔网络,使得模型在应对密集、形状不统一、尺寸不一致的复杂场景时能够很好地提取到物体特征,其结构如图 4所示。

|

| 图 4 DCFPN结构 Fig. 4 Structure of DCFPN |

由图 4可知,DCFPN自上而下有3层。FMFE[1]、FMFE[2]、FMFE[3]分别表示对应层中MFE模块的输出特征,F[1]、F[2]、F[3]分别表示第一、第二、第三层1×1卷积的输出特征,Ffusion[2]、Ffusion[3]表示第二和第三层经过融合的特征,Upsample表示对特征图进行上采样操作,本研究使用的是双线性插值上采样,DConv表示可变形卷积,F[1]′、F[2]′、F[3]′分别表示DCFPN结构第一、第二和第三层的输出特征,即分别对应网络中P5、P4和P3的输出。

DCFPN结构的具体流程如算法4所示。

算法 4 DCFPN结构算法流程

输入:特征图序列FMFE=(FMFE[1], FMFE[2], FMFE[3])

输出:特征图序列F′=(F[1]′, F[2]′, F[3]′)

1:for i=1 to 3 do

2: F[i]=Conv(1×1, FMFE[6-i]);

3:end for

4:Ffusion[2]=F[2]+Upsample(F[1]);

5:Ffusion[3]=F[3]+Upsample(Ffusion[2]);

6:F[1]′=DConv(3×3, F[1]);

7:for i=2 to 3 do

8: F[i]′=DConv(3×3, Ffusion[i]);

9:end for

10:return F′

2 实验 2.1 实验设置本研究所有实验均在相同实验环境下进行,实验结果均为对应模型训练一次取最终结果。实验环境为Ubuntu 18.04.6 LTS,处理器为Intel Core i9-10980XE CPU @ 3.00 GHz×36,显卡为GeForce RTX 4080,16 GB显存。实验基于PyTorch深度学习框架,开发环境为PyTorch1.13.0,Cuda 11.7,Python版本为3.7。训练时批大小设为2,学习率设为0.005,使用SGD优化器,输入IMSE与FCOS的图片大小为600×600,输入其他模型的图片大小为800×1 333。在MS COCO数据集[23]的对比实验中,IMSE与FCOS的实验环境和实验结果的获取方式与上述一致。关于其他模型在MS COCO数据集上的实验结果,本研究引用了文献[24]中的相关数据。为了保证公平性,本研究所选的对比模型均为目标检测领域中具有代表性的优秀模型,包括基于锚框和无锚框、单阶段和两阶段的检测算法,并考虑了各模型在不同数据集上的表现,以确保能够全面且深入地评估IMSE的优越性能。

2.2 数据集为了验证本研究提出的IMSE在密集型的小目标检测场景下的适用性,本研究通过3个目标检测数据集进行验证,分别为MS COCO[23]、CARPK[2]和WOOD数据集,3个数据集的图像数据信息如表 1所示。

| 数据集 Dataset |

数据集划分 Partition of dataset |

图片数量 Number of images |

物体个数 Number of objects |

| MS COCO | Train | 118 287 | 978 288 |

| Val | 5 000 | 41 781 | |

| Test | 123 287 | 1 020 069 | |

| Total | 246 574 | 2 040 138 | |

| CARPK | Train | 989 | 42 274 |

| Test | 459 | 47 500 | |

| Total | 1 448 | 89 774 | |

| WOOD | Train | 684 | 198 060 |

| Val | 86 | 24 980 | |

| Test | 85 | 27 547 | |

| Total | 855 | 250 587 |

MS COCO数据集[23]包括训练集(Train,118 287张图片)、验证集(Val,5 000张图片)、测试集(Test,40 670张图片),共有80个类别。数据集的数据特点是多目标、部分目标存在遮挡与噪声、包含各种尺寸的物体。CARPK[2]数据集是一个通过无人机采集的大型公共数据集,该数据集包含从不同停车场捕获的近90 000辆汽车,是首个也是最大的支持物体计数的无人机视图数据集。数据集分为Train (989张图片)和Test (459张图片),共1个类别。数据集的特点是多目标、目标密集、目标尺寸小。WOOD数据集由实际生产场景采集而得,该数据集由人工采集的200张图片,经过随机裁剪、水平翻转、镜像、图像锐化等数据增强操作得到了855张图片,其中Train有684张图片(包含有198 060根木头),Val有86张图片(包含有24 980根木头),Test有85张图片(包含有27 547根木头)。数据集的特点是图片中目标数量多、分布密集、尺寸多样、噪声多。

2.3 模型评价指标本研究以COCO指标对模型进行性能评估,常见的评价指标有平均精度(Average Precision,AP)、AP75、APS、APM、APL。AP是通过计算PR曲线与横轴、纵轴之间的面积而得。PR曲线是由精确率与召回率构成的曲线,其中横轴表示召回率,纵轴表示精确率。AP75表示IoU值(IoU是预测的检测框和真实的检测框的交并比)为0.75时的平均精度,APS、APM、APL分别表示模型检测小物体、中等物体、大物体的平均精度。平均精度越高,说明模型目标检测的准确性越高。

2.4 实验结果与分析 2.4.1 在MS COCO数据集上的对比实验为了验证IMSE的有效性,表 2为IMSE在MS COCO数据集上与主流目标检测模型的对比结果。其中,骨干网络R50与R101分别表示ResNet50与ResNet101,Epochs表示不同模型的迭代次数,AP、AP75、APS、APM、APL如上文所述均表示模型的平均精度,下表同。由表 2可知,在该数据集的实验中,IMSE在较少的Epochs下就能获得较高的AP值,很好地说明了网络结构设计的有效性。IMSE的所有性能指标都优于基线FCOS,AP值从47.6%提高到49.4%,AP75值从52.1%提高到53.9%,证明了本研究提出的方法在多尺度目标检测方面的优越性。此外,IMSE除了在AP和AP75指标的表现上稍逊色于CO-DETR,在APS指标上的性能稍逊色于基于Transformer的部分DETR系列模型,其余指标均表现最佳。本研究针对落后原因分析认为,这可能是由于DETR系列的模型在Query上提出一种新的建模方式,该方式借鉴了先验框的思想,以带有坐标信息的Query来辅助注意力机制的关注位置,因此在性能指标上比本研究提出的模型高,但该类模型也因先验框的引入导致在进行多尺度检测时,无法同时较好地识别不同尺度的物体,且可能带来计算复杂度高的问题。综上可知,IMSE在非密集场景下的目标检测实现了综合性能的提升,验证了模型的泛化性和鲁棒性。

| 模型 Model |

骨干网络 Backbone |

迭代次数 Epochs |

AP/% | AP75/% | APS/% | APM/% | APL/% |

| DETR-DC5[25] | R101 | 500 | 44.9 | 47.7 | 23.7 | 49.5 | 62.3 |

| Anchor-DETR-DC5[26] | R101 | 50 | 45.1 | 48.8 | 25.8 | 49.4 | 61.6 |

| Efficient-DETR-DC5[27] | R101 | 36 | 45.7 | 49.5 | 28.2 | 49.1 | 60.2 |

| Deformable-DETR[28] | R50 | 50 | 46.2 | 50.0 | 28.8 | 49.2 | 41.7 |

| Dab-Deformable-DETR[29] | R50 | 50 | 46.9 | 50.8 | 30.1 | 50.4 | 62.5 |

| YOLOv8 | Darknet53 | 300 | 37.2 | 39.9 | 18.5 | 40.9 | 53.1 |

| DN-Deformable-DETR[30] | R50 | 12 | 43.4 | 47.2 | 24.8 | 46.8 | 59.4 |

| FCOS[10] | R101 | 12 | 47.6 | 52.1 | 24.7 | 54.1 | 71.1 |

| CO-DETR[31] | R50 | 12 | 49.5 | 54.3 | 32.4 | 52.7 | 63.7 |

| IMSE(ours) | R101 | 12 | 49.4 | 53.9 | 27.0 | 56.7 | 71.3 |

2.4.2 在CARPK数据集上的对比实验

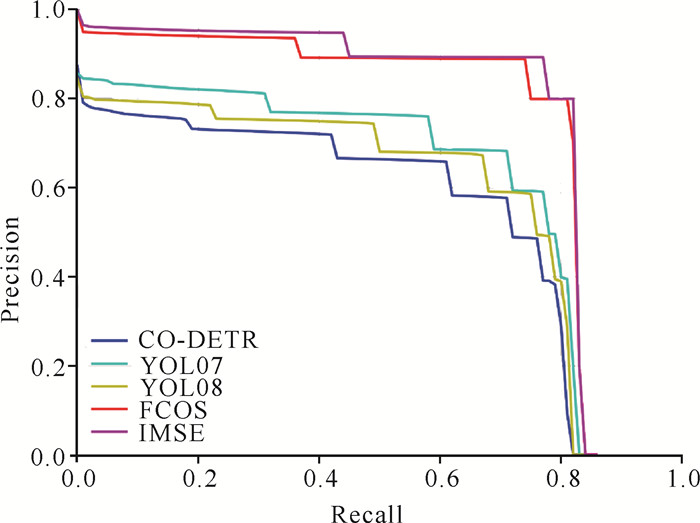

如表 3与图 5所示,展示了IMSE与其他目标检测器在CARPK数据集上的实验结果。IMSE在物体尺寸统一、物体排列密集的数据集上的所有性能指标均明显优于YOLOv8、CO-DETR等主流目标检测方法。具体而言,IMSE在AP指标上达到了75.8%,比基线提高了1.4%,在APS指标上比基线提高了1.1%。与CO-DETR模型相比,IMSE在AP值上高出21.7%,在更严格的AP75指标上高出16.1%,在APS指标上高出16.1%。由此可见,IMSE获得了更稳健的性能优势。图 5直观地展现了IMSE在CARPK数据集上的准确率和召回率在所有对比模型中获得了最好的结果。可见,IMSE不仅在多尺度检测方面占优,而且在处理物体大小和形状规则且密集的场景方面也表现出了良好的性能。

| 模型 Model |

骨干网络 Backbone |

迭代次数 Epochs |

AP/% | AP75/% | APS/% | APM/% | APL/% |

| DINO[32] | R50 | 100 | 48.1 | 55.1 | 7.0 | 49.4 | - |

| FCOS[10] | R101 | 100 | 74.4 | 82.2 | 24.0 | 76.2 | - |

| YOLOv7[33] | Darknet 53 | 100 | 60.9 | 75.1 | 5.8 | 62.8 | - |

| YOLOv8 | Darknet 53 | 100 | 57.4 | 72.1 | 2.7 | 59.2 | - |

| CO-DETR[31] | R50 | 100 | 54.1 | 66.1 | 9.0 | 55.7 | - |

| IMSE (ours) | R101 | 100 | 75.8 | 82.2 | 25.1 | 77.5 | - |

|

| 图 5 IMSE与其他模型PR曲线对比 Fig. 5 PR curve comparison between IMSE and other models |

2.4.3 在WOOD数据集上的对比实验

MS COCO等数据集的数据特点均不属于图片中物体数目多、分布密集的特点,而在实际生产场景常常是物体数量多、尺寸变化大、分布密集,因此在WOOD数据集上验证IMSE的检测能力。表 4是IMSE与不同模型在WOOD数据集上的性能对比。由表 4可知,IMSE在AP、AP75与APL上均获得了所有对比模型中的最优结果,而APS未高于DINO与YOLOv7。本研究分析认为,DINO是基于传统多头自注意力机制进行训练的,相较于本研究的WA模块能更好地关注全局特征,而中小目标因存在遮挡等因素,需要建立全局联系才能更好地识别,因此本研究在APS指标上要略逊色于DINO。但是,由于DINO中使用了传统的多头自注意力(MHSA)模块,根据表 5可知,在时间复杂度和硬件内存占用上,本研究的WA模块在参数量和计算量上更占优势。而YOLOv7中SPPCSPC结构通过4条不同的MaxPool分支增大感受野,且分支中池化核的尺寸较大,能够在更大范围内感知图像中的上下文信息,有助于理解小目标在整个图像中的位置和关系,因此在APS指标上略占优势。但是观察发现YOLOv7在其余性能指标上均表现不足,可能是由于最大池化操作只保留每个池化窗口中的最大值,导致部分重要信息丢失。综上,IMSE在密集型的小目标检测场景下获得了更具有竞争性的性能表现。

| 模型 Model |

骨干网络 Backbone |

迭代次数 Epochs |

AP/% | AP75/% | APS/% | APM/% | APL/% |

| Mask RCNN[34] | R101 | 300 | 46.0 | 52.6 | 0.9 | 5.2 | 65.9 |

| YOLOv5[35] | CSPDarknet | 300 | 34.2 | 38.4 | 9.2 | 22.6 | 36.7 |

| YOLOv7[33] | Darknet53 | 300 | 32.8 | 38.7 | 16.0 | 17.7 | 44.4 |

| DINO[32] | R50 | 300 | 40.0 | 39.6 | 26.2 | 30.4 | 58.3 |

| FCOS[10] | R101 | 300 | 52.9 | 62.3 | 13.3 | 43.8 | 65.6 |

| IMSE(ours) | R101 | 300 | 55.0 | 62.8 | 14.8 | 38.5 | 67.7 |

| 模块 Module |

每秒计算量/G FLOPs/G |

参数量/M Parameters/M |

| WA | 2.83 | 3.15 |

| MHSA | 3.90 | 14.75 |

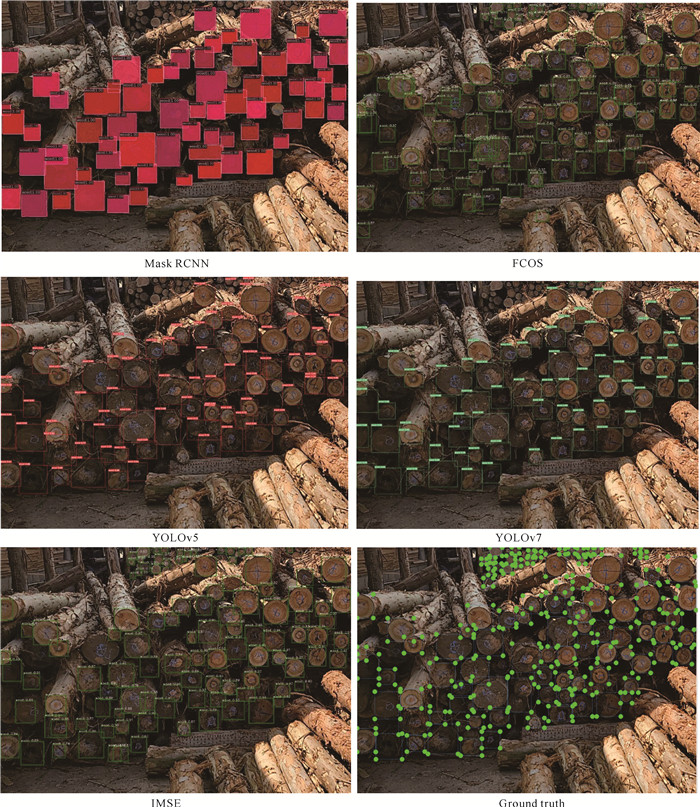

为了更直观地验证IMSE在密集场景下小目标检测的优越性能,本研究在WOOD数据集上展示了不同模型的检测结果,如图 6所示。通过观察发现,在真实的密集场景下进行检测时,Mask R-CNN在某些目标存在遮挡情况时出现了遗漏和错误的检测,对于密集且较小的物体检测效果不佳;FCOS虽然在密集场景下能较好地识别物体,但是在同一个物体中存在多个目标框重复出现和定位不够准确的问题;YOLOv5与YOLOv7均存在目标框重复出现和无法较好地识别和定位到小目标的问题,特别是在目标之间存在明显重叠的情况下。这些问题可能是因为在面对密集的小目标物体时,仅依靠传统的卷积操作无法全面地学习和提取图像特征,而IMSE能够在复杂场景下具有较好地定位目标和噪声抑制的能力。

|

| 图 6 IMSE与其他模型在WOOD数据集上检测效果展示 Fig. 6 Visualization of the detection effects of IMSE and other models on WOOD dataset |

2.4.4 MHSA模块与WA模块的计算量及参数量对比

MHSA模块与WA模块的每秒计算量与参数量对比如表 5所示。实验中两个模块均将注意力头数设置为4,输入维度均为(1 024,30,30)。从实验结果可知,WA模块在每秒计算量与参数量上都要少于MHSA模块。

2.4.5 消融实验IMSE主要包含3个功能模块: WA模块、MIF模块、DCFPN结构。本研究的消融实验在MS COCO、CARPK和WOOD数据集上评估这3个模块的重要性。表中,√表示保留此组件,×表示去除此组件。

表 6是IMSE在MS COCO数据集上的消融实验结果,由实验结果可知在WA模块、MIF模块和DCFPN结构都存在网络中时,模型AP达到了49.4%;在仅添加WA模块与DCFPN结构时,模型AP为48.5%;在仅添加MIF模块与DCFPN结构时,模型AP为49.2%,且在APL指标上获得了最好的结果,本研究分析认为MIF模块通过不同大小的卷积和全局池化操作可以捕获到更大范围的上下文信息,而在加入了WA模块后在APL指标上性能略微有所下降,这可能是因为在引入WA模块后,因需要进行窗口注意力机制计算,模块之间的权重参数相互影响,网络更倾向于在更全面的性能提升上进行优化。由此验证了本研究所提出的WA模块、MIF模块与DCFPN结构协同作用的有效性。

| 模型 Model | WA | MIF | DCFPN | AP/% | AP75/% | APS/% | APM/% | APL/% |

| IMSE-0 | × | × | × | 38.1 | 40.7 | 16.3 | 41.7 | 60.7 |

| IMSE-1 | √ | × | √ | 48.5 | 53.0 | 25.5 | 55.4 | 71.8 |

| IMSE-2 | × | √ | √ | 49.2 | 53.8 | 25.7 | 56.4 | 72.5 |

| IMSE-3 | √ | √ | × | 48.6 | 53.2 | 25.8 | 55.7 | 71.4 |

| IMSE | √ | √ | √ | 49.4 | 53.9 | 27.0 | 56.7 | 71.3 |

表 7是IMSE在CARPK数据集上的消融实验结果,由实验结果可知在WA模块、MIF模块和DCFPN结构都存在网络中时,模型AP达到了75.8%;在仅添加WA模块与DCFPN结构时,模型AP为75.7%;在仅添加MIF模块与DCFPN结构时,模型AP为75.1%。由此可知,模型引入WA模块、MIF模块和DCFPN结构均对提高模型性能有益。

| 模型 Model | WA | MIF | DCFPN | AP/% | AP75/% | APS/% | APM/% | APL/% |

| IMSE-0 | × | × | × | 74.4 | 82.2 | 24.0 | 76.2 | - |

| IMSE-1 | √ | × | √ | 75.7 | 82.2 | 24.9 | 77.3 | - |

| IMSE-2 | × | √ | √ | 75.1 | 82.2 | 23.5 | 76.8 | - |

| IMSE-3 | √ | √ | × | 75.4 | 82.2 | 24.2 | 77.2 | - |

| IMSE | √ | √ | √ | 75.8 | 82.2 | 25.1 | 77.5 | - |

表 8是IMSE在WOOD数据集上的消融实验结果。由实验结果可知在WA模块、MIF模块和DCFPN结构都存在网络中时,模型AP达到了55.0%;在仅添加WA模块与DCFPN结构时,模型AP为55.2%;在仅添加MIF模块DCFPN结构时,模型AP为54.8%。由实验结果可知,WA模块、MIF模块与DCFPN结构均同时存在网络中时,只有APS指标达到了最优值。针对这个情况,本研究认为这是由于WA模块的作用是关注特征图的全局空间信息,MIF模块的作用是关注特征图的局部空间信息和通道信息,两者均对空间信息进行关注。当WA与MIF模块同时作用于网络时,若不区分两个模块输出特征的重要程度而直接进行特征融合,会导致网络无法很好地表达关键区域的特征,从而小幅度影响模型的性能。但总体来说,模型引入WA模块、MIF模块和DCFPN结构均对提高模型的性能有益。

| 模型 Model | WA | MIF | DCFPN | AP/% | AP75/% | APS/% | APM/% | APL/% |

| IMSE-0 | × | × | × | 52.9 | 62.3 | 13.3 | 43.8 | 65.6 |

| IMSE-1 | √ | × | √ | 55.2 | 62.9 | 13.9 | 46.8 | 67.8 |

| IMSE-2 | × | √ | √ | 54.8 | 62.9 | 14.2 | 46.6 | 67.3 |

| IMSE-3 | √ | √ | × | 53.6 | 61.4 | 14.5 | 26.9 | 67.1 |

| IMSE | √ | √ | √ | 55.0 | 62.8 | 14.8 | 38.5 | 67.7 |

3 结论

本研究主要探讨了现有目标检测模型在多尺度特征提取中存在的不足,设计了MFE模块和DCFPN结构。在MFE模块中,WA模块通过不同大小的滑动窗口对特征图进行自注意力机制计算,在基本不降低模型性能的同时大大降低了模型的计算量;MIF模块能够同时兼顾特征图的局部空间和通道特征信息,有效提高了模型的特征提取能力。DCFPN结构在应对密集、形状不一和尺寸不一致的物体检测场景时能够很好地提取到物体特征,以解决网络在处理复杂检测场景时出现的漏检、错检和重检的问题。最终,在MFE模块与DCFPN结构的基础上提出了密集型小目标检测网络IMSE。通过在MS COCO、CARPK、WOOD 3个不同类型的数据集上进行对比实验和消融实验,证明了本研究提出的IMSE在密集场景下的小目标检测中有着较优异的性能表现。

| [1] |

HAN T, BAI L, GAO J Y, et al. DR. VIC: decomposition and reasoning for video individual counting [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2022: 3083-3092.

|

| [2] |

HSIEH M R, LIN Y L, HSU W H. Drone-based object counting by spatially regularized regional proposal network [C]//2017 IEEE International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2017: 4145-4153.

|

| [3] |

WANG L Q, YANG J Y, ZHANG Y F, et al. Depth-aware concealed crop detection in dense agricultural scenes [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2024: 17201-17211.

|

| [4] |

杨攀, 郑积仕, 冯芝清, 等. 基于Mask R-CNN的密集木材检测分割方法[J]. 林业工程学报, 2022, 7(2): 135-142. |

| [5] |

霍爱清, 张书涵, 杨玉艳, 等. 密集交通场景中改进YOL-Ov3目标检测优化算法[J]. 计算机工程与科学, 2023, 45(5): 878-884. |

| [6] |

REN S Q, HE K M, GIRSHICK R, et al. Faster RCNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 |

| [7] |

WU Z W, WANG X F, JIA M, et al. Dense object detection methods in RAW UAV imagery based on YOLOv8[J]. Scientific Reports, 2024, 14(1): 18019. DOI:10.1038/s41598-024-69106-y |

| [8] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need [C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. Cambridge: MIT Press, 2017: 6000-6010.

|

| [9] |

CARION N, MASSA F, SYNNAEVE G, et al. End-to-end object detection with transformers [C]//European Conference on Computer Vision. Cham: Springer, 2020: 213-229.

|

| [10] |

TIAN Z, SHEN C H, CHEN H, et al. FCOS: a simple and strong anchor-free object detector[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(4): 1922-1933. |

| [11] |

LIN T Y, DOLLÁR P, GIRSHICK R, et al. Feature pyramid networks for object detection [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2017: 2117-2125.

|

| [12] |

NAYAK A, BOUAZIZI M, AHMAD T, et al. Evaluation of fully convolutional one-stage object detection for drone detection [C]//International Conference on Image Analysis and Processing. Cham: Springer, 2022: 434-445.

|

| [13] |

FU H Y, YUE Y K, WANG W, et al. Ramie plant counting based on UAV remote sensing technology and deep learning[J]. Journal of Natural Fibers, 2023, 20(1): 2159610. DOI:10.1080/15440478.2022.2159610 |

| [14] |

LIU S, CHI J N, WU C D. FCOS-lite: an efficient anchor-free network for real-time object detection [C]//202133rd Chinese Control and Decision Conference (CCDC). Piscataway, NJ: IEEE, 2021: 1519-1524.

|

| [15] |

YU J B, CHENG X, LI Q F. Surface defect detection of steel strips based on anchor-free network with channel attention and bidirectional feature fusion[J]. IEEE Transactions on Instrumentation and Measurement, 2022, 71: 1-10. |

| [16] |

XIE J X, ZHANG X W, LIU Z Q, et al. Detection of Litchi leaf diseases and insect pests based on improved FCOS[J]. Agronomy, 2023, 13(5): 1314. DOI:10.3390/agronomy13051314 |

| [17] |

GAO P, TIAN T, ZHAO T M, et al. Double FCOS: a two-stage model utilizing FCOS for vehicle detection in various remote sensing scenes[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2022, 15: 4730-4743. DOI:10.1109/JSTARS.2022.3181594 |

| [18] |

PAVEZ L, SAAVEDRA J M. NL-FCOS: improving FCOS through non-local modules for object detection [C]//202226th International Conference on Pattern Recognition (ICPR). Piscataway, NJ: IEEE, 2022: 4651-4657.

|

| [19] |

WANG Y N, LIN X N, ZHANG X S, et al. Improved FCOS for detecting breast cancers[J]. Current Medical Imaging, 2022, 18(12): 1291-1301. DOI:10.2174/1573405618666220420091649 |

| [20] |

ZHOU B, LI B, LAN W F, et al. SDH-FCOS: an efficient neural network for defect detection in urban underground pipelines[J]. Computers, Materials & Continua, 2024, 78(1): 633-652. |

| [21] |

DAI J F, QI H Z, XIONG Y W, et al. Deformable convolutional networks [C]//2017 IEEE International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2017: 764-773.

|

| [22] |

YU F, KOLTUN V, FUNKHOUSER T. Dilated residual networks [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2017: 472-480.

|

| [23] |

LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: common objects in context [C]//European Conference on Computer Vision. Cham: Springer, 2014: 740-755.

|

| [24] |

ZHAO Y, LV W Y, XU S L, et al. DETRs beat YOLOs on real-time object detection [C]//2024 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2024: 16965-16974.

|

| [25] |

CHEN Q, CHEN X K, WANG J, et al. Group DETR: fast DETR training with group-wise one-to-many assignment [C]//2023 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2023: 6633-6642.

|

| [26] |

WANG Y M, ZHANG X Y, YANG T, et al. Anchor DETR: query design for transformer-based detector[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2022, 36(3): 2567-2575. |

| [27] |

YAO Z Y, AI J B, LI B X, et al. Efficient DETR: improving end-to-end object detector with dense prior [EB/OL]. (2021-04-03)[2024-05-21]. https://doi.org/10.48550/arXiv.2104.01318.

|

| [28] |

ZHU X Z, SU W J, LU L W, et al. Deformable DETR: deformable transformers for end-to-end object detection [EB/OL]. (2021-03-18)[2024-05-21]. https://doi.org/10.48550/arXiv.2010.04159.

|

| [29] |

LIU S L, LI F, ZHANG H, et al. Dab-DETR: dynamic anchor boxes are better queries for DETR [EB/OL]. (2022-03-30)[2024-05-21]. https://doi.org/10.48550/arXiv.2201.12329.

|

| [30] |

LI F, ZHANG H, LIU S L, et al. DN-DETR: accelerate DETR training by introducing query denoising [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2022: 13619-13627.

|

| [31] |

ZONG Z, SONG G, LIU Y. DETRs with collaborative hybrid assignments training [C]//2023 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2023: 6748-6758.

|

| [32] |

ZHANG H, LI F, LIU S L, et al. DINO: DETR with improved denoising anchor boxes for end-to-end object detection [EB/OL]. (2022-07-11)[2024-05-21]. https://doi.org/10.48550/arXiv.2203.03605.

|

| [33] |

WANG C Y, BOCHKOVSKIY A, LIAO H Y M. YOLOv7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2023: 7464-7475.

|

| [34] |

HE K M, GKIOXARI G, DOLLÁR P, et al. Mask R-CNN [C]//2017 IEEE International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2017: 2961-2969.

|

| [35] |

YANG G H, FENG W, JIN J T, et al. Face mask recognition system with YOLOV5 based on image recognition [C]//2020 IEEE 6th International Conference on Computer and Communications (ICCC). Piscataway, NJ: IEEE, 2020: 1398-1404.

|