2. 广西民族大学物理与电子信息学院, 广西南宁 530006

2. School of Physics and Electronic Information, Guangxi Minzu University, Nanning, Guangxi, 530006, China

行人检索方法是指通过特定人物的图像、视频或文本描述,在数据库中寻找对应人物的图像或视频,这一方法在公共安全领域有着广泛应用。在传统的图像行人检索方法中,比较图像间的相似度相对容易,现有算法[1-2]在这方面已经取得了显著的成果。文本行人检索方法通过自然语言文本描述来查找特定的行人目标。与传统图像行人检索方法不同,这种方法仅依赖文本描述来搜索目标个体,使文本检索在行人重识别领域中具有显著的实用价值。一些先进的跨模态算法[3-4]在解决文本与图像匹配问题上取得了一定的进展,并且在Flickr30k[5]和MSCOCO[6]等数据集上展示了其有效性,但这些优异的算法并不完全适用于行人识别的文本检索任务,这是因为Flickr30k和MSCOCO数据集通常包含高清晰度的图像和多样的物体,使得研究者侧重于图像和文本之间全局特征的匹配,而忽视了局部特征对齐的重要性。相比之下,在标准行人识别数据集CUHK-PEDES[7]中,许多图像较模糊而且分辨率较低,这就要求算法不仅要考虑图像和文本之间全局特征的匹配,还要把握文本描述中的细节信息和图像局部特征,以挖掘行人图像与文本之间的关联。

在基于文本的行人检索领域中,引入注意力机制可显著提升方法的特征提取能力,通过分配权重来揭示图像和文本之间的关联性,但其有时侧重全局特征而忽略对局部关键特征的权重分配。因此,随着计算机视觉研究的发展,不依赖于注意力机制的姿态引导方法成为主流,这种方法通过水平切分和属性对齐来实现局部与全局特征的匹配。Jing等[8]提出的姿态引导多粒度注意力(Pose-guided Multi-granularity Attention,PMA)模型和Wang等[9]提出的图像文本属性对齐网络(Visual-textual attributes alignment in person search by natural language,ViTAA)通过人体姿态解析以及属性分解提升了局部与全局特征的对齐效果。然而,Gao等[10]指出姿态引导方法未能捕捉到隐藏的高级抽象语义信息,导致某些文本描述与图像区域无法正确对齐,即局部特征关联性不足。近年来,对比语言-图像预训练模型(Contrastive Language-Image Pre-training,CLIP)[11]在挖掘图像与文本特征之间的关联性上表现出巨大的潜力,基于该模型的文本行人检索方法备受关注。然而,当前利用CLIP添加各种复杂模块来进行图像和文本匹配的研究,没有充分发挥其跨模态语义学习能力,也未能充分解决图像局部细节问题。因此,如何获取更细致的局部与全局特征表达并挖掘图像与文本属性间的语义关联性,成为当前跨模态行人检索方法的重要挑战。

针对上述问题,本文基于ViTAA在图像全局特征提取以及局部图像与文本属性特征对齐方面进行改进。首先,为了解决ViTAA缺乏对行人细节信息挖掘的问题,本文提出一个新的特征提取网络——多头自注意力网络(Multi-head self-attention network,MHANet)来增强对行人全局细节的把控能力,帮助获取具有不同空间语义信息的特征表示,使图像与文本在全局特征对齐方面有更好的匹配效果。其次,ViTAA直接计算图像与文本之间的属性特征相似度,缺乏对图像与文本内部依赖关系以及属性特征之间关联信息的挖掘。因此,本文构建跨模态属性注意力(Cross-modal attribute attention,ACA)模块,该模块通过结合多头自注意力(Multi-head self-attention, MHA)的方式获取图像和文本属性特征的内在依赖关系,并以学习到内在信息的文本特征作为指导,增强图像特征的表达,强化属性特征的对齐。最后,在MHANet和ACA模块的基础上,构建新的文本检索行人模型(Cross-modal Attribute Matching Alignment Network,CAMN),该模型通过增强全局和局部属性特征来提高图像文本匹配的效果。

1 相关工作 1.1 跨模态文本行人检索在跨模态文本行人检索任务中,早期工作主要依赖于注意力机制来提取局部特征[12-13],但这种方法的效果高度依赖于注意力机制的设计质量,并未充分考虑文本与图像之间的语义关联性,不够重视局部特征,因此在文本特征与图像特征的匹配过程中难以达成令人满意的成效。为了解决局部特征挖掘不充分的问题,Wang等[9]提出了ViTAA,从局部属性对齐的角度处理跨模态行人检索任务。ViTAA通过语义分割和语法解析,将特征空间分解为属性子空间,并利用对比学习方法实现图像与文本属性特征的对齐,这种方法不仅提高了局部特征的对齐效果,还增强了全局特征的亲和力,成为该领域的一个重要发展方向[14]。但是Gao等[10]指出,该方法未能挖掘深层语义信息,使文本与图像在局部空间上无法实现更好的对齐。此外,Wang等[15]提出了一种多分支构架(Capturing All-round Information Beyond Color,CAIBC),通过整合语义、衣物纹理等信息来增强文本检索行人的性能,但该方法仍缺少对语义理解的深度处理,对复杂场景的适应性不足。

最近几年,CLIP凭借无监督图文匹配能力成为主流特征提取框架,Han等[16]将CLIP运用至文本到图像检索任务中,提出跨模态动量对比学习框架来提升检索性能,Yan等[17]通过微调CLIP来增强对人物特征的理解。尽管这些方法增强了对人物特征的匹配度,但是CLIP本身存在语义理解的局限,易忽视局部细节,仍未能充分且有效解决局部特征的细节问题。

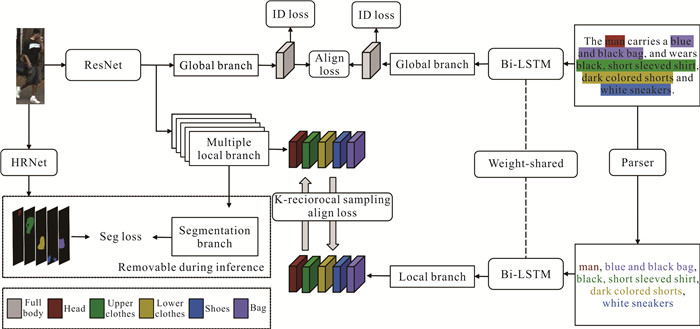

1.2 ViTAAViTAA由图像流、文本流和图像文本对齐学习3个部分组成(图 1)。图像流采用残差网络(Residual Network,ResNet)[18]作为特征提取网络,提取出全局特征vglb0,然后使用已预训练好的高分辨率网络(High-Resolution Network,HRNet)[19]语义分割网络,辅助监督形成5个局部属性分支(头部、上身、下身、鞋子和包)特征vloc,vloc={v1, …, vnatt},其中natt表示类别。文本流则利用双向长短期记忆网络(Bi-directional Long Short-Term Memory,Bi-LSTM)[20],通过构建字典的方式计算名词短语的余弦相似度来对其进行分类,得到文本全局特征tglb0和局部文本嵌入{t1, …, tN}。图像文本对齐学习是通过学习一个图像文本对的融合嵌入空间,使图像文本对的对齐更为紧密。

|

| 图 1 ViTAA示意图 Fig.1 Schematic diagram of the ViTAA |

2 方法

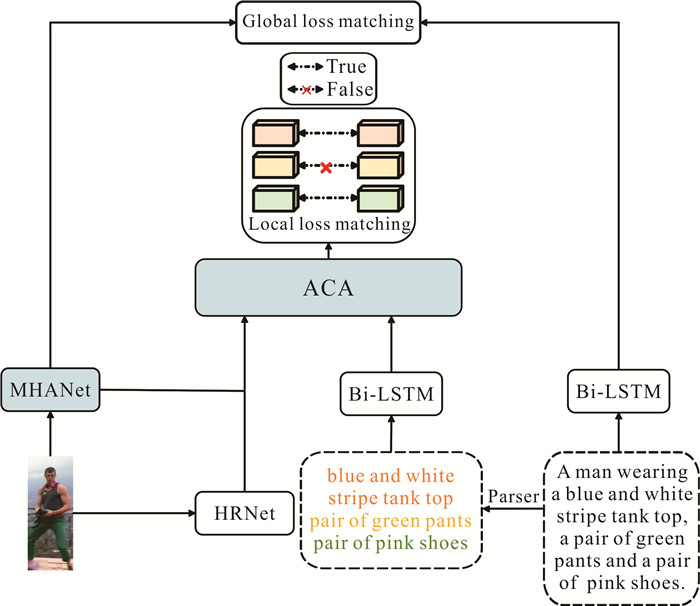

本文提出的CAMN包括基于ResNet的MHANet和ACA模块,MHANet用于捕获细致的图像特征,ACA模块进一步探索图像属性特征和文本属性特征之间的相互关联,这种关联信息被用来增强与文本相关联的图像属性特征表达,从而实现更准确的属性对齐。CAMN的架构如图 2所示,包括全局对齐和局部对齐两个部分。全局对齐通过MHANet和Bi-LSTM获取图像和文本的全局特征;局部对齐则结合MHANet和HRNet进行训练,以捕获局部图像属性特征,并利用Bi-LSTM处理分解的属性短语以获取文本属性特征。局部图像和文本属性特征通过ACA模块增强后,采用损失匹配方法对特征进行有效对齐,以提升模型性能。下面将介绍MHANet和ACA模块的设计。

|

| 图 2 CAMN架构 Fig.2 CAMN architecture |

2.1 MHANet

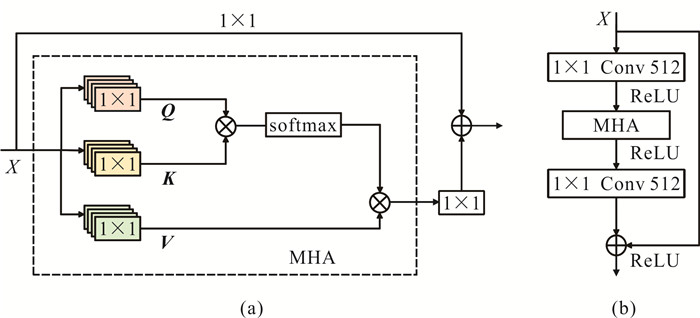

视觉变换器(Visual Transformer,ViT)模型将Transformer应用于计算机视觉领域并取得了巨大成功,得益于其自注意力机制的特征融合能力。本文提出一个新的MHANet,该网络使用图像MHA模块来改进ResNet残差块,用以获得图像更深层的特征。MHA模块结构如图 3所示。

|

| 图 3 MHA模块结构示意图(a)和MHA构建的残差块(b) Fig.3 Schematic diagram of the MHA module structure (a) and residual blocks constructed by MHA (b) |

首先在MHA模块中输入特征图XH×W×D,通过线性操作与3个不同的参数矩阵Wq、Wk、Wv得到Q、K、V,将Q、K点乘,然后经过softmax与 V进行点乘,最后得到输出结果,其输出与特征图大小一致,公式如下所示。

| $ \begin{aligned} & \boldsymbol Q_{1 \times 1}=X \boldsymbol{W}_\boldsymbol q, \boldsymbol{K}_{1 \times 1}=X \boldsymbol{W}_\boldsymbol k, \boldsymbol{V}_{1 \times 1}=X \boldsymbol{W}_\boldsymbol v, \\ & \operatorname{MHA}(X)=\operatorname{Attention}(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})= \end{aligned} $ | (1) |

| $ \operatorname{softmax}\left(\frac{\boldsymbol{Q K}^ {\boldsymbol {\mathrm T}}}{\sqrt{d_k}}\right) \boldsymbol{V}, $ | (2) |

其中,Wq、Wk、Wv ∈R1×1×D, 表示可学习参数矩阵,Q、K、V是输入特征图X分别与可学习参数矩阵 Wq、Wk、Wv经线性相乘生成的向量,KT表示 K的转置,dk表示 V的维度。

通过使用MHA模块,得到了改进的MHANet,该网络对ResNet中的残差块进行了改进,克服了传统卷积操作在全局上下文建模上的局限性,MHANet结构如表 1所示,其中Fc为全连接层,用于整合特征并映射到输出空间。MHA模块利用多头注意力机制动态融合特征图上位置的关联信息,使MHANet具有捕捉长距离依赖的能力,其多头设计通过多子空间学习,增强了特征的多样性与表达能力,帮助MHANet得到更细致的特征。

| 层名 Layer name |

输出 Output |

MHANet |

| Stage 0 | 112×112 | 7×7, 64, stride=2 |

| Stage 1 | 56×56 | |

| Stage 2 | 28×28 | |

| Stage 3 | 14×14 | |

| Stage 4 | 7×7 | |

| Stage 5 | 1×1 | 7×7, average pool, Fc |

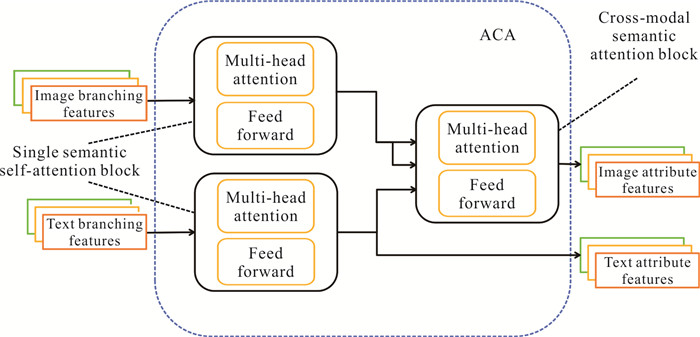

2.2 ACA模块

本文设计一种ACA模块,该模块旨在增强图像和文本的属性特征表达,通过挖掘图像与文本属性特征之间的语义关系,提升图像属性特征与文本属性特征之间的匹配度。对于ACA模块,首先输入图像分支特征 Vp和文本分支特征 Tp,经过单一语义自注意力块后,分别得到图像属性特征 V′和文本属性特征 Tp′,将V′和Tp′一起输入跨模态语义注意力块,生成与文本属性有关联的图像属性特征。其中单一语义自注意力块和跨模态语义注意力块的结构相同,均由多头自注意力机制层和前向反馈层构成(图 4)。

|

| 图 4 ACA模块 Fig.4 ACA module |

单一语义自注意力块中图像属性特征V′的公式为

| $ {\boldsymbol Q_\boldsymbol p^\boldsymbol v=\boldsymbol{V}_\boldsymbol p \boldsymbol{W}_\boldsymbol Q^\boldsymbol v, \boldsymbol{K}_\boldsymbol p^\boldsymbol v=\boldsymbol{V}_\boldsymbol p \boldsymbol{W}_\boldsymbol K^\boldsymbol v, \boldsymbol{V}_\boldsymbol p^\boldsymbol v=\boldsymbol{V}_\boldsymbol p \boldsymbol{W}_\boldsymbol V^\boldsymbol v} $ | (3) |

| $ \boldsymbol{V}^{\prime}=\operatorname{Attention}\left(Q_\boldsymbol p^\boldsymbol v, \boldsymbol{K}_\boldsymbol p^\boldsymbol v, \boldsymbol{V}_\boldsymbol p^\boldsymbol v\right), $ | (4) |

其中,WQv、WKv、WVv表示单一语义自注意力块图像的参数矩阵。单一语义自注意力块的文本属性特征Tp′的公式为

| $ \boldsymbol{Q_p^t=T_p W_Q^t, K_p^t=T_p W_K^t, V_p^t=T_p W_V^t}, $ | (5) |

| $ \boldsymbol{T}_\boldsymbol p^{\prime}=\operatorname{Attention}\left(\boldsymbol{Q}_\boldsymbol p^\boldsymbol t, \boldsymbol{K}_\boldsymbol p^\boldsymbol t, \boldsymbol{V}_\boldsymbol p^\boldsymbol t\right), $ | (6) |

其中,WQt、WKt、WVt表示单一语义自注意力块文本的参数矩阵。单一语义自注意力块旨在促使图像局部特征理解各分支特征间的内在联系,同时让文本分支特征捕获单词之间的依赖关系,并揭示句子间的语义联系,以获得富含内在关联属性的文本特征。

跨模态语义注意力块的目标是利用已掌握关键信息的文本属性特征 Qt来指导图像属性特征 Kv和 Vv, 学习与文本属性相关的语义信息,进而提升图像属性特征表达的丰富度,增强局部图像属性特征与文本属性特征之间的匹配效果,最后输出局部图像属性特征 Vp′。文本属性特征Qt和局部图像属性特征 Vp′的计算公式如下。

| $ {\boldsymbol Q_\boldsymbol t=\boldsymbol T_\boldsymbol p^{\prime} \boldsymbol W_\boldsymbol Q, \boldsymbol K_\boldsymbol v=\boldsymbol V^{\prime} \boldsymbol W_\boldsymbol K, \boldsymbol V_\boldsymbol v=\boldsymbol V^{\prime} \boldsymbol W_\boldsymbol V}, $ | (7) |

| $ \begin{aligned} & \quad \boldsymbol{V}_\boldsymbol p^{\prime}=\operatorname{Attention}\left(\boldsymbol{Q}_\boldsymbol t, \boldsymbol{K}_\boldsymbol v, \boldsymbol{V}_\boldsymbol v\right)= \\ & \operatorname{softmax}\left(\frac{\boldsymbol Q_\boldsymbol t \boldsymbol{K}_\boldsymbol v^{\mathrm{\boldsymbol T}}}{\sqrt{d_K}}\right) \boldsymbol{V}_\boldsymbol v, \end{aligned} $ | (8) |

其中,WQ、WK、WV表示可学习参数矩阵,KvT表示 Kv的转置,dK表示图像属性特征向量 Vv的维度。跨模态注意力机制通过交叉注意方式有效关联了图像与文本的属性特征,并深入挖掘其深层语义关联,从而增强特征表达并优化局部特征匹配效果。ACA模块算法如算法1所示。

算法1 ACA模块算法流程

输入:文本分支特性 Tp ={t1, …, tn},图像分支特征 Vp= {v1, v2, …, vnatt}

输出:文本属性特征 Tp′和增强后的局部图像属性特征Vp′

1:按公式(3)计算图像属性特征V′的Qpv、Kpv、Vpv;

2:V′ =Attention (Qpv, Kpv, Vpv);//计算图像属性特征V′

3:按公式(5)计算文本属性特征Tp′的Qpt、Kpt、Vpt;

4:Tp′ =Attention (Qpt, Kpt, Vpt);//计算文本属性特征Tp′

5:Qt=Tp′WQ;//计算文本属性特征Qt

6:Kv=V′WK;//计算图像属性特征Kv

7:Vv=V′WV;//计算图像属性特征Vv

8:Vp′ =Attention (Qt, Kv, Vv);//计算增强后的局部图像属性特征Vp′

9:Output Tp′、Vp′

2.3 跨模态属性特征匹配训练CAMN通过端对端的方式训练整个网络,采用与ViTAA同样的损失训练方式,使用交叉双向三重排序损失(Align函数)来完成对全局和局部特征匹配损失的优化。对于一批图像-文本对,全局特征匹配的损失如公式(9)所示:

| $ \begin{aligned} & L_{\text {align }}=\frac{1}{N} \sum\limits_{i=1}^N\left\{\log \left[1+e^{-\tau_p\left(S^{+}-\alpha\right)}\right]+\log [1+\right. \\ & \left.\left.e^{\tau_n\left(S^{-}-\beta\right)}\right]\right\}, \end{aligned} $ | (9) |

其中,S+、S-分别为使用余弦相似度计算的图像文本对的正、负样本相似度,N表示训练批次中的样本总数,α和β分别为正样本的上限和负样本的下限,τp和τn分别为控制正、负样本的温度参数。对于局部特征匹配,采用由ACA模块得到的局部图像属性特征 Vp′与文本属性特征Tp′,通过公式(9)计算得到最终的局部特征匹配损失。此外,在提取局部图像属性特征Vp′时,引入语义分割损失(Seg)作为监督信号,将人体属性特征划分为5个分支。总损失为

| $ L=L_{\text {seg }}+L_{\text {global }}^{\text {align }}+L_{\text {part }}^{\text {align }}, $ | (10) |

其中,Lseg为语义分割损失,Lglobalalign为全局特征匹配损失,Lglobalpart为局部特征匹配损失。

3 实验与结果分析 3.1 数据集CUHK-PEDES数据集是由香港中文大学开发的行人重识别数据集,该数据集包含13 003个行人的40 206张图片,每张图像配备两段平均长度超过23个字的自然语言描述,涵盖行人外观特征,其数据来源多样,包含多摄像头、不同光照、复杂背景及姿态变化场景,是目前公认的、专门为基于文本的行人重识别任务设计的第一个大规模数据集。

ICFG-PEDES数据集是由华南理工大学几何感知与智能实验室在2021年提出的一个数据集,该数据集包含4 102个不同身份行人的54 522张图片,每张图片对应一条详细描述行人外观特征的文本,可用于图像行人重识别及基于文本描述的查询。与CUHK-PEDES数据集相比,ICFG-PEDES数据集更强调身份中心的精确描述,要求算法实现文本与图像的高保真对齐,对跨模态特征融合和语义理解提出更高的挑战。

RSTPReid数据集是一个专为基于文本的行人重识别设计的数据集,包含20 505张由15个摄像头拍摄的图片,覆盖4 101个行人,其特点是多样性和复杂性,每个人物有5张不同摄像头拍摄的照片,涵盖复杂室内外场景转换和背景,更具真实场景的挑战性。

3.2 评价指标本文采用Rank-K(K=1、5、10)作为实验的性能评价指标,它是本领域广泛认可的评价指标。具体而言,Rank-K表示在模型输出的排序结果中,正确匹配的目标出现在前K个位置的概率,Rank-K数值越高,表明模型在检索任务中的性能越优。

3.3 实验配置实验环境为Ubuntu 18.04.6 LTS系统,Intel Core i9-10980XE CPU,GeForce RTX 4080显卡。实验开发环境基于PyTorch 1.13.0和CUDA 11.7,使用Python 3.7。图像大小为384×128,图像表征向量 VN+1和文本表征向量 TM+1均为512,α为0.6,β为0.4,τp为20,τn为60;单一语义自注意力块N为4,跨模态语义注意力块M为3。Batch size为64,epoch为60,初始学习率为1×10-5。

3.4 对比实验为验证CAMN在基于文本的跨模态检索行人任务上的性能,将本文提出的CAMN与各类主流算法模型在CUHK-PEDES、ICFG-PEDES、RSTPReid数据集上进行对比实验(表 2至表 4)。其中,Rank-1、Rank-5、Rank-10均取结果最好的一代,*表示根据作者提供的代码进行复现实验的结果,对表格中CAMN的实验结果进行加粗处理。

| 模型 Model |

图像网络 Image network |

文本网络 Text network |

Rank-1 | Rank-5 | Rank-10 |

| GNA-RNN[7] | VGG | LSTM | 19.05 | 53.65 | |

| PMA[8] | ResNet | LSTM | 54.12 | 75.45 | 82.97 |

| ViTAA[9]* | ResNet | LSTM | 55.97 | 75.84 | 83.52 |

| NAFS[10] | ResNet | BERT | 59.94 | 79.86 | 86.70 |

| Han et al.[16] | CLIP-RN101 | CLIP-Xformer | 64.08 | 81.73 | 88.19 |

| Dualpath[21] | ResNet | ResNet | 14.40 | 66.26 | 75.07 |

| CMPM/C[22] | ResNet | LSTM | 49.37 | 79.27 | |

| MIA[23] | VGG | GRU | 53.10 | 75.00 | 82.90 |

| TIMAM[24] | ResNet | BERT | 54.51 | 77.56 | 84.78 |

| CMKA[25] | ResNet | LSTM | 54.69 | 73.65 | 81.86 |

| CMAAM[26] | Mobilenet | LSTM | 56.68 | 77.18 | 84.86 |

| NAFS+LapsCore[27] | ResNet | BERT | 63.40 | 87.80 | |

| SSAN[28]* | ResNet | LSTM | 61.37 | 80.15 | 86.73 |

| TIPCB[29] | ResNet | BERT | 64.26 | 83.19 | 89.10 |

| LGUR[30]* | DeiT-Small | BERT | 64.68 | 83.12 | 89.00 |

| CLIP-RN50[31] | CLIP-RN50 | CLIP-Xformer | 57.26 | 78.57 | 85.58 |

| CLIP-RN101[31] | CLIP-RN101 | CLIP-Xformer | 60.27 | 80.88 | 87.88 |

| ADA[32] | ResNet | LSTM | 64.36 | 81.67 | 88.13 |

| CAMN | MHANet | LSTM | 67.93 | 84.17 | 88.79 |

| 模型 Model |

图像网络 Image network |

文本网络 Text network |

Rank-1 | Rank-5 | Rank-10 |

| ViTAA[9]* | ResNet | LSTM | 50.98 | 68.79 | 75.76 |

| Dualpath[21] | ResNet | ResNet | 38.99 | 59.44 | 68.41 |

| CMPM/C[22] | ResNet | LSTM | 43.51 | 65.44 | 74.26 |

| MIA[23] | VGG | GRU | 46.49 | 67.14 | 75.18 |

| SSAN[28]* | ResNet | LSTM | 54.23 | 72.63 | 79.53 |

| TIPCB[29] | ResNet | BERT | 54.96 | 74.72 | 81.89 |

| LGUR[30]* | DeiT-Small | BERT | 59.02 | 75.32 | 81.56 |

| CLIP-RN50[31] | CLIP-RN50 | CLIP-Xformer | 41.46 | 63.68 | 73.04 |

| CLIP-RN101[31] | CLIP-RN101 | CLIP-Xformer | 44.09 | 66.27 | 74.75 |

| CLIP-ViT-B/16[31] | CLIP-ViT | CLIP-Xformer | 56.74 | 75.72 | 82.26 |

| ADA[32] | ResNet | LSTM | 56.88 | 74.05 | 80.82 |

| CSKT[33] | CLIP-Vit | CLIP- Xformer | 58.90 | 77.31 | 83.56 |

| CAMN | MHANet | LSTM | 60.23 | 78.09 | 84.23 |

| 模型 Model |

图像网络 Image network |

文本网络 Text network |

Rank-1 | Rank-5 | Rank-10 |

| ViTAA[9]* | ResNet | LSTM | 38.45 | 62.40 | 73.80 |

| CMKA[25] | ResNet | LSTM | 37.60 | 61.15 | 73.55 |

| SSAN[28]* | ResNet | LSTM | 43.50 | 67.80 | 77.15 |

| TIPCB[29] | ResNet | BERT | 45.55 | 68.20 | 77.85 |

| LGUR[30]* | DeiT-Small | BERT | 46.70 | 70.00 | 78.80 |

| CLIP-RN50[31] | CLIP-RN50 | CLIP-Xformer | 41.40 | 68.55 | 77.95 |

| CLIP-RN101[31] | CLIP-RN101 | CLIP-Xformer | 43.45 | 67.75 | 78.40 |

| CAMN | MHANet | LSTM | 46.94 | 72.13 | 82.76 |

3.4.1 在CUHK-PEDES数据集上进行的对比实验分析

表 2展示了在各模型CUHK-PEDES数据集上的性能对比结果。实验结果表明,本文提出的CAMN在Rank-1、Rank-5、Rank-10上的性能分别为67.93%、84.17%、88.79%,证明了该模型的有效性。与GNA-RNN[7]、Dualpath[21]、CMPM/C[22]、TIMAM[24]、CMKA[25]这类仅依赖全局特征进行对齐的模型相比,CAMN比性能最好的CMKA在Rank-1、Rank-5、Rank-10上分别提升13.24百分点、10.52百分点、6.93百分点。同时,CAMN与基于CLIP的CLIP-RN50[31]相比,在Rank-1、Rank-5、Rank-10性能上分别提升10.67百分点、5.60百分点、3.21百分点,证明了CAMN在该数据集上具有明显优势。

在基于文本的行人检索任务中,为验证CAMN在属性特征方面所具有的优势,将其与PMA[8]、ViTAA[9]、CMAAM[26]这类使用属性特征对齐的模型进行对比。实验结果表明,与CMAAM相比,结合了全局和局部特征对齐策略的CAMN性能最优,Rank-1、Rank-5、Rank-10性能分别提升11.25百分点、6.99百分点、3.93百分点。这证明了加强全局图像特征并深入挖掘局部图像与文本属性特征之间的联系有利于提高匹配精度,验证了结合全局与局部特征对齐策略的优势。

3.4.2 在ICFG-PEDES数据集上进行的对比实验分析表 3展示了各模型在ICFG-PEDES数据集上的性能对比结果。与Dualpath[21]和CMPM/C[22]这类仅依赖全局特征进行对齐的模型相比,CAMN比CMPM/C在Rank-1上的性能显著提升16.72百分点,与当前主流的LGUR[30]模型相比,CAMN在Rank-1上的性能提升1.21百分点。同时,与基于CLIP的CSKT[32]相比,在Rank-1、Rank-5、Rank-10上的性能分别提升1.33百分点、0.78百分点、0.67百分点。对比结果证明了通过深入挖掘图像和文本属性特征之间的相互关系可以有效提升图像与文本特征之间的匹配度,也验证了CAMN标注不同身份行人的有效性。

3.4.3 在RSTPReid数据集上进行的对比实验分析表 4展示了各模型在RSTPReid数据集上的性能对比结果。ViTAA在RSTPReid数据集上的实验结果表明,基于属性特征对齐的方法能够有效提升复杂场景下的文本检索行人性能。CAMN则是通过获取更细致的图像全局特征以及挖掘图像文本之间的属性关系获得了进一步的性能提升,超越了性能最好的模型LGUR[30],在Rank-1、Rank-5、Rank-10上的性能分别提升0.24百分点、2.13百分点、3.96百分点,证明了强化全局图像特征并探索图像与文本属性特征间的关联能够提高图像文本特征之间的匹配准确性。然而,RSTPReid数据集中包含不同的场景转换以及现实情境,增加了模型在该数据集内检索行人的难度,因此CAMN在该数据集下的提升没有在另外两个数据集上明显。

3.5 消融实验为验证本文提出的MHANet和ACA模块对整体结构的重要性,在CUHK-PEDES数据集上对其进行消融实验,结果如表 5所示,最佳结果已加粗处理,√表示使用该组件,×表示去除该组件。实验结果表明,不使用MHANet和ACA模块时,CAMN的性能较低;仅添加MHANet或ACA模块时,CAMN的性能有所提升;而两者结合使用时,CAMN在Rank-1、Rank-5、Rank-10上的性能分别达到67.93%、84.17%、88.79%。这证明了通过MHANet改进图像提取特征骨干网络可以获取更细致的图像特征,而ACA模块能够获取文本与图像之间的关联性,进而增强图像文本之间的属性特征匹配。

| MHANet | ACA | Rank-1 | Rank-5 | Rank-10 |

| × | × | 55.97 | 75.84 | 83.52 |

| √ | × | 57.19 | 76.31 | 84.62 |

| × | √ | 63.71 | 81.16 | 85.14 |

| √ | √ | 67.93 | 84.17 | 88.79 |

3.6 可视化分析

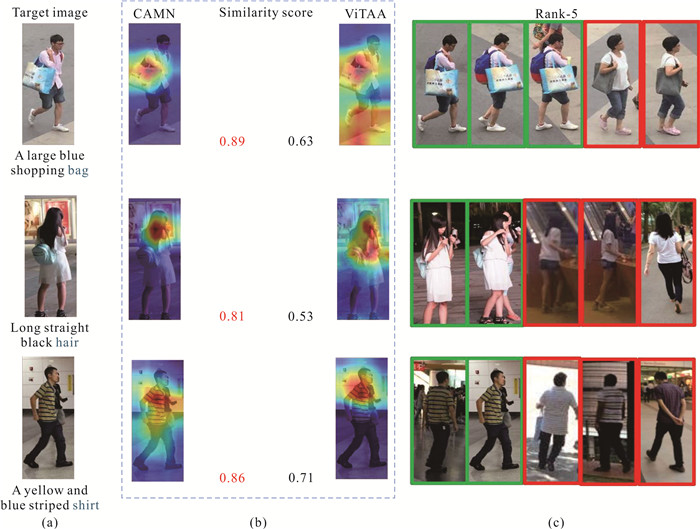

为充分证明CAMN能够有效地识别文本与图像属性特征之间的关联,在CUHK-PEDES数据集上对其进行可视化分析。图 5为CAMN可视化图,其中,图 5(a)为文本与检索图片,图 5(b)为CAMN、ViTAA的热力图和属性相似度得分,图 5(c)为CAMN的Rank-5结果,绿色框表示与目标人物匹配成功,红色框为未匹配成功。通过将属性短语的检索与图像中人物的属性特征间的相似性得分进行对比,发现ViTAA能够识别文本所对应的图像区域,但其相似度得分较低。相比之下,CAMN在识别相关属性方面表现出色,这一结果归功于CAMN在挖掘图像全局特征及局部图像-文本属性关联性方面具有更优秀的性能。

|

| 图 5 CAMN在CUHK-PEDES数据集上的可视化分析 Fig.5 Visualization analysis of CAMN on the CUHK-PEDES dataset |

4 结论

本文提出了基于跨模态属性匹配对齐的文本检索行人模型(CAMN),通过精细化图文的全局和局部属性对齐,提升了文本到行人图像的检索性能。首先,针对传统图像骨干网络提取特征的不足,本文设计了多头自注意力网络(MHANet),利用自注意力机制提取更细致的图像全局特征。其次,为改善图像与文本属性在关联性上的不足,本文提出了跨模态属性注意力(ACA)模块,通过多头自注意力挖掘模态内属性关联,进而引入交叉注意力机制,以文本属性的潜在关联信息为指导,强化图像中与文本属性相关的特征表达,实现图文语义空间的对齐优化。实验结果表明,CAMN在CUHK-PEDES、ICFG-PEDES、RSTPReid 3个公开数据集上表现出色,克服了传统图像骨干网络在捕获细节的局限以及图文间属性特征关联性的不足。

| [1] |

WIECZOREK M, RYCHALSKA B, DA BROWSKI J. On the unreasonable effectiveness of centroids in image retrieval [C]//Neural Information Processing. Cham: Springer International Publishing, 2021: 212-223.

|

| [2] |

GONG Y P. A general multi-modal data learning method for person re-identification [Z/OL]. (2021-06-01) [2025-01-25]. https://arxiv.org/abs/2101.08533v4.

|

| [3] |

ZENG Y, ZHANG X S, LI H. Multi-grained vision language pre-training: aligning texts with visual concepts [Z/OL]. (2022-06-01) [2025-01-25]. https://arxiv.org/abs/2111.08276.

|

| [4] |

CHEN H, DING G G, LIU X D, et al. IMRAM: iterative matching with recurrent attention memory for cross-modal image-text retrieval [C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2020: 12652-12660.

|

| [5] |

PLUMMER B A, WANG L, CERVANTES C M, et al. Flickr30k entities: collecting region-to-phrase correspondences for richer image-to-sentence models [C]//2015 IEEE International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2016: 2641-2649.

|

| [6] |

LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: common objects in context [C]//Computer Vision-ECCV 2014. Cham: Springer, 2014: 740-755.

|

| [7] |

LI S, XIAO T, LI H S, et al. Person search with natural language description [C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2017: 5187-5196.

|

| [8] |

JING Y, SI C Y, WANG J B, et al. Pose-guided multi-granularity attention network for text-based person search [C]//Proceedings of the AAAI Conference on Artificial Intelligence. Menlo Park: AAAI, 2020, 34(7): 11189-11196.

|

| [9] |

WANG Z, FANG Z Y, WANG J, et al. ViTAA: visual-textual attributes alignment in person search by natural language [C]//Computer Vision-ECCV 2020. Cham: Springer, 2020: 402-420.

|

| [10] |

GAO C Y, CAI G Y, JIANG X Y, et al. Contextual non-local alignment over full-scale representation for text-based person search [Z/OL]. (2021-01-08) [2025-01-25]. https://arxiv.org/abs/2101.03036.

|

| [11] |

RADFORD A, KIM J W, HALLACY C, et al. Learning transferable visual models from natural language supervision [C]//International Conference on Machine Learning. New York: Proceedings of Machine Learning Research, 2021: 8748-8763.

|

| [12] |

XU X, WANG T, YANG Y, et al. Cross-modal attention with semantic consistence for image-text matching[J]. IEEE Transactions on Neural Networks and Learning Systems, 2020, 31(12): 5412-5425. DOI:10.1109/TNNLS.2020.2967597 |

| [13] |

YE M, SHEN J B, LIN G J, et al. Deep learning for person re-identification: a survey and outlook[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(6): 2872-2893. DOI:10.1109/TPAMI.2021.3054775 |

| [14] |

张新峰, 宋博. 一种基于改进三元组损失和特征融合的行人重识别方法[J]. 计算机科学, 2021, 48(9): 146-152. |

| [15] |

WANG Z J, ZHU A C, XUE J Y, et al. CAIBC: capturing all-round information beyond color for text-based person retrieval [C]//Proceedings of the 30th ACM International Conference on Multimedia. New York: ACM, 2022: 5314-5322.

|

| [16] |

HAN X, HE S, ZHANG L, et al. Text-based person search with limited data [Z/OL]. (2021-10-20) [2025-02-01]. https://arxiv.org/abs/2110.10807.

|

| [17] |

YAN S L, DONG N, ZHANG L Y, et al. CLIP-driven fine-grained text-image person re-identification[J]. IEEE Transactions on Image Processing, 2023, 32: 6032-6046. DOI:10.1109/TIP.2023.3327924 |

| [18] |

HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2016: 770-778.

|

| [19] |

WANG J, SUN K, CHENG T, et al. Deep high-resolution representation learning for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 43(10): 3349-3364. |

| [20] |

HUANG Z H, XU W, YU K. Bidirectional LSTM-CRF models for sequence tagging [Z/OL]. (2021-01-08) [2025-01-25]. https://arxiv.org/abs/1508.01991.

|

| [21] |

ZHENG Z D, ZHENG L, GARRETT M, et al. Dual-path convolutional image-text embeddings with instance loss[J]. ACM Transactions on Multimedia Computing, Communications, and Applications, 2020, 16(2): 1-23. |

| [22] |

ZHANG Y, LU H C. Deep cross-modal projection learning for image-text matching [C]//Computer Vision-ECCV 2018. Cham: Springer, 2018: 707-723.

|

| [23] |

NIU K, HUANG Y, OUYANG W L, et al. Improving description-based person re-identification by multi-granularity image-text alignments[J]. IEEE Transactions on Image Processing, 2020, 29: 5542-5556. DOI:10.1109/TIP.2020.2984883 |

| [24] |

SARAFIANOS N, XU X, KAKADIARIS I. Adversarial representation learning for text-to-image matching [C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2019: 5813-5823.

|

| [25] |

CHEN Y C, HUANG R, CHANG H, et al. Cross-modal knowledge adaptation for language-based person search[J]. IEEE Transactions on Image Processing, 2021, 30: 4057-4069. DOI:10.1109/TIP.2021.3068825 |

| [26] |

AGGARWAL S, BABU R V, CHAKRABORTY A. Text-based person search via attribute-aided matching [C]//2020 IEEE Winter Conference on Applications of Computer Vision (WACV). Piscataway, NJ: IEEE, 2020: 2617-2625.

|

| [27] |

WU Y S, YAN Z Z, HAN X G, et al. LapsCore: language-guided person search via color reasoning [C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2021: 1604-1613.

|

| [28] |

DING Z F, DING C X, SHAO Z Y, et al. Semantically self-aligned network for text-to-image part-aware person re-identification [Z/OL]. (2021-08-09) [2025-02-01]. https://arxiv.org/abs/2107.12666.

|

| [29] |

CHEN Y H, ZHANG G Q, LU Y J, et al. TIPCB: a simple but effective part-based convolutional baseline for text-based person search[J]. Neurocomputing, 2022, 494: 171-181. DOI:10.1016/j.neucom.2022.04.081 |

| [30] |

SHAO Z Y, ZHANG X Y, FANG M, et al. Learning granularity-unified representations for text-to-image person re-identification [C]//30th ACM International Conference on Multimedia. New York: ACM, 2022: 5566-5574.

|

| [31] |

JIANG D, YE M. Cross-modal implicit relation reasoning and aligning for text-to-image person retrieval [C]//2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2023: 2787-2797.

|

| [32] |

夏威, 袁鑫攀. 基于属性依存增强的文搜图行人重识别[J]. 科技资讯, 2024, 22(8): 12-15. |

| [33] |

LIU Y T, LI Y W, LIU Z M, et al. CLIP-based synergistic knowledge transfer for text-based person retrieval [C]//ICASSP 2024-2024 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Piscataway, NJ: IEEE, 2024: 7935-7939.

|