城市发展受到道路的绝对影响,而时间和气象变化给路面造成很大的破坏[1]。路面损坏检测和缺陷修复工程可以在保障交通安全的同时,以较低代价延长道路使用寿命。路面破损情况最初由专家来判断,这种方法易受人为因素影响,在较大的路面损坏检测工程面前不能大范围推广[2]。随着科技的进步,图像处理技术和机器学习方法逐渐被应用于道路缺陷检测领域。图像处理技术仅能识别表面特征,难以适应复杂多变的路面缺陷特征;机器学习虽然能够掌握数据规律并学习深层特征,但在道路裂缝提取方面仍需人工设置阈值和参数,对缺陷类型的检测存在局限性,因而无法完全实现自动化检测。

随着计算机行业成为经济发展的关键推动力,深度学习算法正朝着前所未有的高度前进。众多学者不断尝试通过深度学习方法拓展道路缺陷检测的应用范围,将这一问题的解决方案推向新高度[3]。基于深度学习的目标检测算法能够通过卷积神经网络(Convolutional Neural Network,CNN)有效提取路面图像的缺陷特征并实现自动学习[4],从而在检测准确率上取得了突破性进展。目标检测技术主要分为两阶段目标检测算法和单阶段目标检测算法。Vishwakarma等[5]选择更快速的区域卷积神经网络(Faster Region-based Convolutional Neural Network,Faster R-CNN),通过大量实验不断调整模型,在道路缺陷病害检测中取得了最佳性能,但模型的泛化能力尚未得到充分验证。Singh等[6]采用以区域提案网络(Region Proposal Network,RPN)和101层残差网络(Residual Network with 101 layers,ResNet 101)为骨干网络的基于区域提议的掩膜卷积神经网络(Mask Region-based Convolutional Neural Network,Mask R-CNN),在真实路面缺陷检测中取得了不错的效果,但存在评估指标较为单一的问题,且模型的泛化能力缺乏充分验证。两阶段目标检测算法虽然准确率很高,但运行速度大幅下降[7]。为此,单阶段目标检测算法应运而生,并迅速引起广泛关注。该算法不仅弥补了原有算法的缺陷,大幅提升了检测速度,还在准确率方面取得了重大突破。Maeda等[8]推出一个全新的大规模道路缺陷数据集,并在研究中将SSD(Single Shot MultiBox Detector)模型部署在智能手机上,实现了75%的检测精度。Alfarrarjeh等[1]使用YOLO (You Only Look Once)训练模型,通过数据增强策略优化学习过程,并采用了较高的非极大抑值(Non-maximum Suppression, NMS),实验结果表明,该模型的F1分数达到了0.62,为城市道路检测和维护提供了一个实用的解决方案;然而,由于某些类别的道路损坏图像数量较少,模型在这些类别上的性能可能不佳,且其泛化能力尚未得到充分验证。Lei等[9]采用YOLOv3模型作为基准模型,采用尺度不变特征变换并结合全球定位系统(Global Positioning System,GPS)定位进行道路破损程度检测,取得了88.37%的平均精度,但所用数据集的覆盖范围较为有限。何铁军等[10]提出的PD-YOLO(Pavement Damage-YOLO)模型通过结合空间金字塔快速池化(Spatial Pyramid Pooling Fast,SPPF)、跨阶段部分连接(Cross Stage Partial Connection,CSP)模块和自适应空间特征融合(Adaptively Spatial Feature Fusion,ASFF)模块,能够有效处理不同尺度的路面病害,在不同光照和阴影条件下仍保持较好的检测精度;然而,该模型对细小裂缝以及阴影、污染等干扰因素的检测性能仍需进一步优化。王朕等[11]提出基于改进YOLOv5的路面病害检测模型YOLOv5l-CBF,通过加入坐标注意力机制和Transformer结构增强了模型对病害特征的捕捉能力,在真实路面病害数据集上平均精确度均值(mAP)达到90.8%,但模型的参数量有待优化。Pham等[12]采用YOLOv7模型并引入坐标注意力机制,在谷歌街景道路损坏数据集中取得了较高准确率,但未与主流算法进行对比,难以凸显模型优势。许小伟等[13]提出基于RT-DETR的路面坑槽检测模型(Pavement Pothole-DETR,PP-DETR),采用空间-深度残差结构特征提取模块(Space-to-depth Residual Struct Feature Extraction Block,SPDRSFE)强化了小目标特征学习能力,mAP达到76.9%,但存在检测速度下降以及参数量和计算复杂度小幅增加的问题。总体而言,深度学习算法的发展为道路缺陷检测持续提供新思路,使模型的检测性能得到显著提升。

道路病害通常通过车载相机或无人机进行拍摄,但由于图像分辨率低且缺陷呈现多尺度特征,导致检测难度增加,准确率下降。现有的道路缺陷检测研究普遍局限于模型和数据集的选取,并未涉及路面缺陷的多尺度特征。针对以上问题,本文提出一种面向道路缺陷检测的轻量级多尺度卷积移动注意力模型(YOLOv8 Multi-scale Convolutional Mobile Attention,YOLOv8-MCMA)。该模型采用MobileViT网络提取多尺度缺陷特征,在减少参数量的同时提高了检测精度;通过引入内容感知的特征重组(Content-Aware Reassembly of Features, CARAFE)模块代替原有的上采样模块,能够在大范围感受野内捕获到更多内容,从而减少信息丢失;设计多尺度倒置残差注意力(Multi-scale Inverted Residual Attention, MIRA)模块,以更高效提取更复杂的局部和全局多尺度缺陷特征;最后,引入可变核卷积(Alterable Kernel Convolution,AKConv),通过不同大小的卷积核和采样形状,更有效地关注不规则的多尺度路面缺陷特征信息。

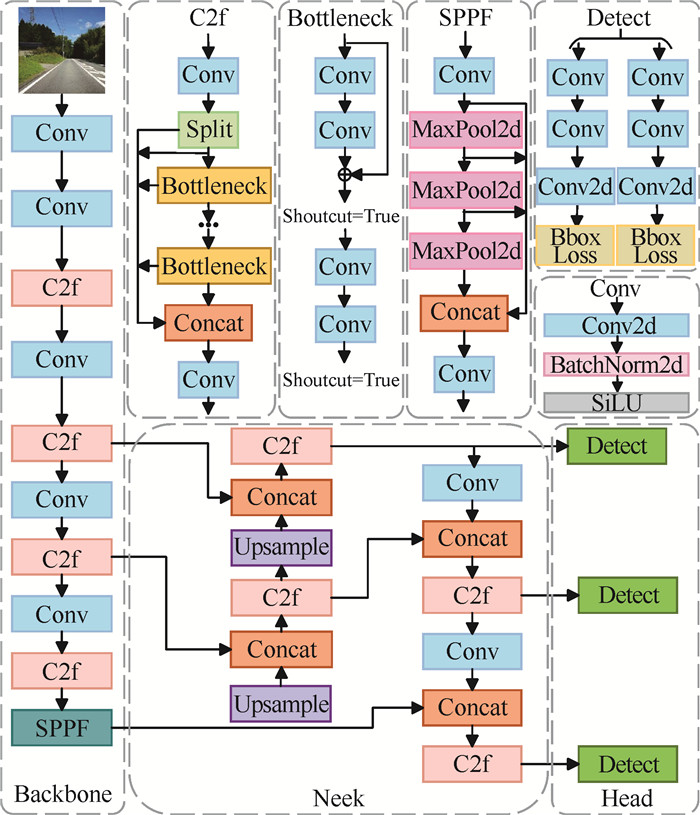

1 模型介绍YOLO[14]算法自2016年发布以来就受到广泛关注。YOLOv8模型在不增加额外参数量的前提下提高了准确率,适合应用于实时道路缺陷检测任务,因此本文选用YOLOv8n作为基准模型。YOLOv8模型的整体框架由骨干网络、颈部网络和检测头3部分组成:骨干网络通过卷积操作提取图像特征, 颈部网络负责融合骨干网络提取的特征, 3个不同尺寸的检测头则用于预测目标类别。

图 1展示了YOLOv8模型的网络结构。在骨干网络部分,将C3模块替换为C2f模块,并将每个阶段的模块数从[3, 6, 9, 3]调整为[3, 6, 6, 3],从而节省计算资源,使模型运行更快、效率更高。颈部的设计灵感来源于YOLOv5的PAN-FPN(Path Aggregation Network-Feature Pyramid Network)结构[15],FPN层将高层语义信息向下传递,而PAN层则将底层的强定位特征向上传递,随后对参数进行融合处理。YOLOv8模型采用了解耦头结构,进一步减少了参数量。此外,模型引入了无锚框(Anchor-Free)思想,通过简化冗余步骤直接快速定位对象的中心位置,同时减少了锚框(Anchor)的数量,从而加速目标检测。最后,在训练的最后10轮停止马赛克(Mosaic)数据增强操作,进一步提升了模型的准确度。

|

| 图 1 YOLOv8模型的网络结构 Fig.1 Network structure of YOLOv8 modle |

2 算法改进 2.1 YOLOv8-MCMA模型

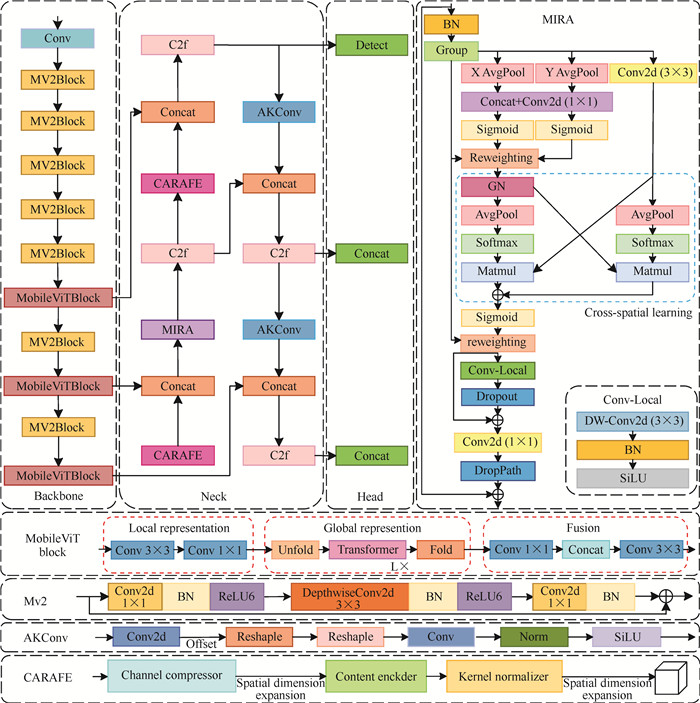

本文提出轻量级模型YOLOv8-MCMA。该模型采用MobileViT作为主干网络,减少了参数量;同时,将上采样模块替换为CARAFE模块,以增强对各类路面损伤特征的识别能力。此外,本文提出MIRA模块,使模型能够更全面地关注多尺度缺陷特征。最后,通过引入AKConv模块,模型能够有效提取不规则的缺陷信息。图 2展示了YOLOv8-MCMA模型的网络结构。

|

| 图 2 YOLOv8-MCMA模型的网络结构 Fig.2 Network structure of YOLOv8-MCMA modle |

2.2 MobileViT网络

本文将YOLOv8的骨干网络替换为轻量级的MobileViT[16]网络。该网络具有参数量低、适用范围广和灵活性强等优势,既继承了CNN的高效率和轻量级,又具备Transformer网络的自注意力机制和全局视野能力,从而成为一款性能更加全面的轻量级模型。

MobileViT网络的结构如图 2所示。MobileNetV2 block (MV2)模块采用标准的1×1卷积和3×3卷积结构。首先通过深度可分离卷积进行特征筛选和清洗,然后经过一系列归一化和激活函数处理完成特征提取,接着通过全连接层将特征反映到标签空间,最后输出结果。MobileViT block模块的处理流程如下:首先用3×3卷积处理输入图像,用1×1卷积调整通道数;然后通过展开、局部处理和折叠等操作构建模型,利用1×1卷积恢复原始通道数,并将结果与初始特征图沿通道方向拼接;最后通过3×3卷积整合各子模块的特征信息,输出最终结果。

2.3 CARAFE模块本文采用CARAFE[17]模块代替原有的上采样模块,该模块能够在大范围内有效聚合信息,同时保持较高的计算效率。图 2展示了CARAFE模块的结构,它由上采样核预测模块和特征重组模块组成。

上采样核预测模块包含通道压缩、内容编码和核扩展与归一化3个子模块。具体流程如下。

① 通道压缩。使用1×1卷积层将输入的C×H×W特征图的通道数从C压缩到Cm,以减轻计算负担,其中C表示通道数,H表示高度,W表示宽度。

② 内容编码。通过内核大小为kencoder的卷积操作生成基于输入特征内容的重组核,得到形状为H×W×σ2×kup2的上采样核, 其中kup2表示单个特征点的上采样核大小,σ为上采样率。

③ 核扩展与归一化。将上采样核的通道扩展到宽度和高度维度,得到形状为σH×σW×kup2的核;随后,对每个kup×kup重组核在空间维度上进行softmax归一化。

在特征重组模块中,输出特征图的每个位置被映射回输入特征图,并与预测的上采样核进行点积运算,最终生成全新的C×σH×σW的特征图。

CARAFE模块通过预测的上采样核对各个特征点执行自适应上采样操作,从而提升上采样特征图的质量。通过聚合局部区域内相关特征点的信息,特征重组方法能够融合更强的语义信息,生成比原始图像更显著的特征。这一改进增强了模型对不同尺度缺陷类别的辨别能力,同时能够更准确地捕获目标缺陷的形状,从而提高了模型的整体准确性。

2.4 MIRA模块由于道路缺陷具有多尺度、特征细小且识别准确度低的特点,为了解决这一问题,本文设计了MIRA模块,该模块能够更有效地关注局部和全局的多尺度缺陷,其结构如图 2所示。

MIRA模块首先通过批归一化(Batch Normalization, BN)对特征进行动态重标定,并借鉴高效多尺度注意力(Efficient Multi-scale Attention,EMA)[18]模块的思想,将输入在通道维度上划分为G个分组,每组表示为X=[X0, Xi, …, XG-1],其中Xi∈

MIRA模块采用3条并行的子网络结构,包括两条1×1卷积分支和1条3×3卷积分支。其中,在1×1卷积分支中,首先通过两个全局平均池化(GAP)操作分别沿水平(X)和垂直(Y)方向进行空间编码,然后沿高度方向拼接特征并使用1×1卷积融合。接着,将1×1卷积的输出分解为两个向量,并通过Sigmoid函数生成注意力权重,最终聚合两条通道的注意力图,实现跨通道信息交互。在3×3卷积分支中,采用单个3×3卷积提取多尺度表征,以增强局部跨通道特征的建模能力。然后,MIRA模块在空间维度上进行跨空间信息融合。针对1×1卷积分支的输出,采用2D全局平均池化编码空间信息,公式如下:

| $ Z_c=\frac{1}{H \times W} \sum\limits_j^H \sum\limits_i^W x_c(i, j), $ | (1) |

其中,c表示输入通道数,H表示高度,W表示宽度,xc表示第c个通道的输入特征,i和j分别表示沿着水平和垂直方向的坐标索引。接下来,对1×1卷积分支的输出采用Softmax函数,并与3×3卷积分支的输出进行点积运算,生成第一个空间注意力图。针对3×3卷积分支,首先同样采用全局平均池化编码空间信息,然后与1×1卷积分支的输出进行点积运算,得到第二个空间注意力图,该图能够完整且准确地保留空间位置信息。最后,将两个空间注意力图聚合为空间注意力权重。

借鉴倒置残差移动块(Inverted Residual Mobile Block,iRMB)的思想[19],将提取到的所有像素的全局信息输入到Conv-Local层,再通过一系列卷积、归一化和激活函数操作进一步捕捉和融合局部区域特征。结合残差连接,MIRA模块能够学习到更加细致复杂的路面缺陷特征表示。

2.5 可变核卷积AKConv[20]能够生成任意大小的卷积核并形成初始采样坐标,提供不规则卷积核的初始采样形状,然后将初始采样坐标分配给任意大小的卷积核,并使用可学习的偏移量重新调整采样结构。AKConv的结构如图 2所示。在该结构中,首先通过卷积运算计算出核偏移量以调整采样形状,其维度为(B,2N,H,W),其中B表示批量大小,N表示卷积核大小。接着,将偏移量与原始坐标相加得到修正后的坐标,通过重采样获取相应位置的特征,再经过reshaple、卷积、归一化和SiLU激活函数处理,最终生成输出。这一过程有效解决了不规则卷积核采样位置特征提取困难的问题。与原始采样形状相比,重新采样改变了每个位置的采样形状。

3 实验与结果分析 3.1 数据集本文采用开源的Road Damage Detection Dataset[8]进行实验和改进。该数据集包含7种道路缺陷类别(表 1),共计8 586幅图像。

| 缺陷类别 Defect category |

图像数量/幅 Image quantity |

| Alligator cracks | 5 838 |

| Damaged crosswalk | 685 |

| Damaged paint | 4 590 |

| Longitudinal cracks | 1 934 |

| Manhole cover | 4 398 |

| Potholes | 3 194 |

| Transverse cracks | 3 831 |

为了检验模型的泛化能力,本文从RDD2022_China[21]中选取了“中国_摩托车”和“中国_无人机”两个子集,共计3 853幅道路图像,涵盖4种道路缺陷类别。数据集的缺陷类别和数量如表 2所示。将数据集按7∶2∶1的比例划分为训练集(2 696幅)、验证集(772幅)、测试集(385幅)。

| 子集 Subset |

图像尺寸 Image size |

缺陷类别 Defect category |

图像数量/幅 Image quantity |

| China_Motorbike | 512×512 | D00 | 2 678 |

| D10 | 1 096 | ||

| D20 | 641 | ||

| D40 | 235 | ||

| China_Drone | 512×512 | D00 | 1 426 |

| D10 | 1 263 | ||

| D20 | 293 | ||

| D40 | 86 |

为了进一步验证模型的性能和泛化能力,本文选取开源的Crack-forest Dataset[22]作为测试数据集。该数据集包含118幅图像,通过旋转、翻转、光照调整和对比度增强等策略进行数据增强,最终扩充至1 903幅图像。数据共分为4个类别,包括crack_hor(横向裂缝)、crack_ver(纵向裂缝)、crack_net(网状裂缝)和manhole cover(井盖)。

3.2 实验环境本模型基于Python 3.8软件开发,实验环境配置为Windows 10操作系统和PyTorch开源深度学习框架。硬件测试环境采用12核AMD EPYC 7642 48-Core Processor CPU(32 GB内存)和NVIDIA RTX3090 GPU(24 GB显存)。表 3列出了模型训练的超参数设置。

| 类型 Type |

参数 Parameter |

| Image size | 640×640 |

| Batch size | 8 |

| Learning rate | 0.01 |

| Optimizer | Stochastic Gradient Descent (SGD) |

| Momentum | 0.937 |

| Weight decay | 0.000 5 |

3.3 评价指标

本实验中,采用的评价指标包括精确度(Precision)、召回率(Recall)、平均精确度(Average Precision,AP)、平均精确度均值(mAP)、F1分数(F1 score)、每秒帧数(FPs)、参数量(Parameters)和Giga浮点运算每秒(GFLOPs)。

精确度、召回率、AP、mAP和F1分数的计算公式如式(2)至式(6)所示:

| $ P_{\text {Precision }}=\frac{T_{\mathrm{P}}}{T_{\mathrm{P}}+F_{\mathrm{P}}} \times 100 \%, $ | (2) |

| $ R_{\text {Recall }}=\frac{T_{\mathrm{P}}}{T_{\mathrm{P}}+F_{\mathrm{N}}} \times 100 \%, $ | (3) |

| $ A_{\mathrm{AP}}=\int_0^1 P(t) \mathrm{d} t, $ | (4) |

| $ m_{\mathrm{mAP}}=\frac{\sum_{i=1}^C A_{\mathrm{AP}_i}}{C}, $ | (5) |

| $ F_1=\frac{2 P \times R}{P+R}, $ | (6) |

其中,TP(True Positive)表示实际为正样本且被正确预测为正样本的数量,FP(False Positive)表示实际为负样本但被误预测为正样本的数量,FN(False Negative)表示实际为正样本但被误预测为负样本的数量,TN(True Negative)表示实际为负样本且被正确预测为负样本的数量,P(t)表示交并比(Intersection of Union, IoU)阈值为t时的精确度,C表示总类别数,AAPi表示第i个类别的AP值。

F1分数是精确度和召回率的调和平均值,FPs用于衡量模型的检测速度,GFLOPs用于评估模型的计算复杂度。

3.4 注意力机制对模型性能的影响实验选取CBAM、CoTAttention、SE、ShuffleAttention和CA 5种先进的注意力机制,与本文提出的MIRA模块进行比较。实验在Road Damage Detection Dataset上进行,结果如表 4所示。与其他5种注意力机制相比,MIRA模块的检测精度最高。得益于MIRA模块的多尺度裂缝特征关注能力,其在道路缺陷检测中的表现优于其他注意力模块。

| 模型 Model |

精确度/% Precision/% |

平均精确度 均值@0.5/% mAP@0.5/% |

平均精确度 均值@0.5:0.95/% mAP@0.5:0.95/% |

参数量(×106) Parameters (×106) |

Giga浮点运算每秒 GFLOPs |

| YOLOv8n | 62.3 | 59.9 | 31.5 | 3.0 | 8.1 |

| CBAM | 63.4 | 60.1 | 31.4 | 3.2 | 8.3 |

| CoTAttention | 59.9 | 59.9 | 31.3 | 4.3 | 12.3 |

| SE | 60.3 | 59.9 | 31.3 | 3.0 | 8.8 |

| ShuffleAttention | 61.6 | 59.4 | 31.4 | 3.0 | 8.2 |

| CA | 62.1 | 60.0 | 31.9 | 3.0 | 8.2 |

| MIRA(ours) | 63.6 | 60.2 | 31.9 | 3.2 | 8.2 |

为验证添加MIRA模块的位置对检测效果的影响,本文设计了如表 5所示的实验。该实验以MobileViT作为主干网络,并将上采样模块更换为CARAFE模块,其中(a)表示在主干网络引入MIRA模块,(b)表示在颈部网络插入MIRA模块。由表 5的实验结果可知,在主干网络插入MIRA模块的效果欠佳,因为MobileViT主干网络提取特征的性能已经非常优秀,若再引入注意力模块反而会降低模型的检测精度。因此,将MIRA模块插入颈部网络可以发挥其最大优势。

| 模型 Model |

精确度 Precision |

召回率 Recall |

平均精确度均值@0.5 mAP@0.5 |

平均精确度均值@0.5:0.95 mAP@0.5:0.95 |

| YOLOv8n | 62.3 | 58.0 | 59.9 | 31.5 |

| YOLOv8-MCMA(a) | 60.6 | 61.4 | 62.7 | 32.6 |

| YOLOv8-MCMA(b) | 64.1 | 59.9 | 63.7 | 33.5 |

3.5 消融实验

为验证本文提出的YOLOv8-MCMA模型中各改进模块对性能的影响,本文在Road Damage Detection Dataset上进行了消融实验,结果如表 6所示。将主干网络改进为MobileViT后,模型mAP@0.5提升2.2%,参数量降至2.2×106,但FPs有所下降。基于上采样模块CARAFE的改进使模型的mAP@0.5提升1.1%,参数量仅小幅增加,同时FPs下降21.4。添加MIRA模块后,召回率下降0.8%,但精确度提升1.3%,mAP@0.5提升0.3%。用AKConv替换颈部普通卷积后,精确度和mAP@0.5分别提升0.6%和2.0%。最终,相比YOLOv8n,YOLOv8-MCMA模型的精确度、mAP@0.5和召回率均达到最高,分别显著提升3.1%、3.7%和4.3%,参数量减少0.7×106,减少了23.3%。实验结果表明,YOLOv8-MCMA模型在降低参数量的同时保持了良好的检测精度,能有效提升多尺度路面缺陷特征的识别能力,适用于道路缺陷检测任务。

| 模型 Model |

MobileViT 网络 MobileViT network |

CARAFE 模块 CARAFE module |

MIRA模块 MIRA module |

可变核 卷积 AKConv |

精确度/% Precision/% |

召回率/% Recall/% |

平均精确度 均值@0.5/% mAP@0.5/% |

参数量 (×106) Parameters (×106) |

每秒帧数 FPs |

| YOLOv8n | 62.3 | 58.0 | 59.9 | 3.0 | 135.0 | ||||

| √ | 63.1 | 60.7 | 62.1 | 2.2 | 77.5 | ||||

| √ | 61.0 | 57.7 | 61.0 | 3.1 | 113.6 | ||||

| √ | 63.6 | 57.2 | 60.2 | 3.2 | 112.4 | ||||

| √ | 62.9 | 57.9 | 61.9 | 2.9 | 74.6 | ||||

| √ | √ | 62.8 | 60.2 | 63.0 | 2.2 | 73.0 | |||

| √ | √ | √ | 64.1 | 59.9 | 63.7 | 2.3 | 71.0 | ||

| YOLOv8-MCMA | √ | √ | √ | √ | 65.4 | 62.3 | 63.6 | 2.3 | 62.5 |

3.6 与不同算法的对比

与主流检测算法进行对比实验,验证本文提出的YOLOv8-MCMA模型的效果。对比算法包括Faster-RCNN、Cascade-RCNN、SSD、YOLOv3、YOLOv4、YOLOv5、YOLOv6、YOLOv7、YOLOv8、YOLOv10和RT-DETR-L。其中,Faster R-CNN和Cascade R-CNN的初始学习率设为0.001,权重衰减为1×10-4,batch size为1;SSD初始学习率设为2×10-3,权重衰减为5×10-4,batch size为1;YOLOv3、YOLOv4、YOLOv5、YOLOv6、YOLOv7、YOLOv8和YOLOv10的初始学习率设为0.01,权重衰减为5×10-4;RT-DETR-L初始学习率为0.000 1,权重衰减为1×10-4。除Faster R-CNN、Cascade R-CNN和SSD外,其余算法的batch size均设置为8。所有算法的输入图像尺寸统一调整为640×640。

为验证改进后模型的性能,将YOLOv8-MCMA模型在Road Damage Detection Dataset上与主流目标检测算法进行对比实验,epoch设置为150轮,结果如表 7所示。与Faster R-CNN相比,YOLOv8-MCMA模型在参数量和模型复杂度上具有显著优势,mAP@0.5提高了18.2%。此外,将YOLOv8-MCMA模型与轻量级算法(如YOLOv3-tiny、YOLOv4-tiny、YOLOv5n、YOLOv6n、YOLOv7-tiny和YOLOv10n)对比,其mAP@0.5分别高出8.4%、32.9%、4.6%、3.6%、4.4%、8.1%,检测精度优于其他算法。相较于单阶段算法SSD,YOLOv8-MCMA模型的mAP@0.5提高了20.4%;与RT-DETR-L相比,mAP@0.5提升2.9%,同时参数量和计算量显著低于SSD和RT-DETR-L。

| 算法 Algorithms |

平均精确度 均值@0.5/% mAP@0.5/% |

F1分数/% F1 score/% |

参数量(×106) arameters (×106) |

每秒帧数 FPs |

Giga浮点运算每秒 GFLOPs |

| Faster-RCNN | 45.4 | - | 29.4 | 31.8 | 940.0 |

| SSD | 43.2 | 36 | 26.3 | 23.1 | 62.7 |

| YOLOv3-tiny | 55.2 | 55 | 12.1 | 125.0 | 19.1 |

| YOLOv4-tiny | 30.7 | 22 | 5.9 | 178.0 | 6.8 |

| YOLOv5n | 59.0 | 57 | 2.5 | 117.6 | 7.2 |

| YOLOv6n | 60.0 | 58 | 4.2 | 142.9 | 11.9 |

| YOLOv7-tiny | 59.2 | 58 | 6.0 | 73.5 | 13.2 |

| YOLOv10n | 55.5 | 55 | 2.7 | 141.0 | 8.4 |

| RT-DETR-L | 60.7 | 59 | 29.3 | 24.4 | 110.0 |

| YOLOv8n | 59.9 | 59 | 3.0 | 135.0 | 8.1 |

| YOLOv8-MCMA | 63.6 | 62 | 2.3 | 62.5 | 13.4 |

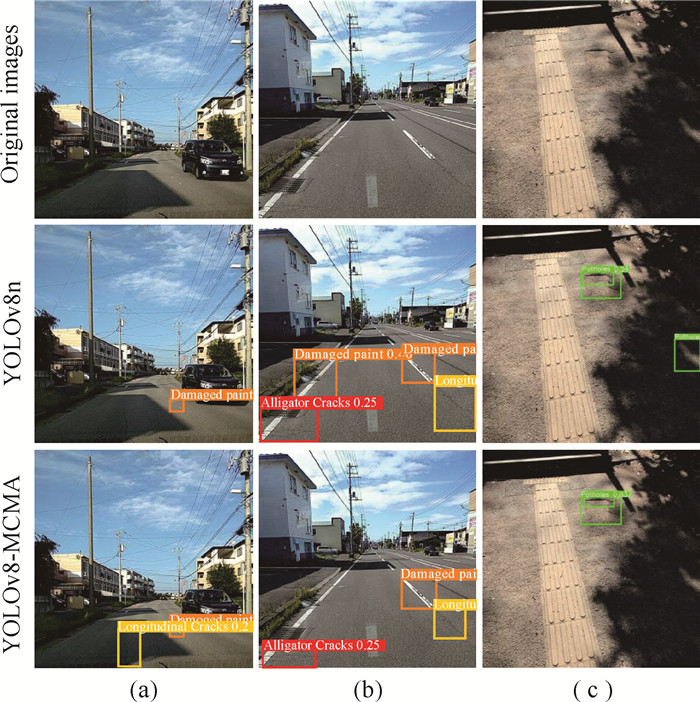

YOLOv8和YOLOv8-MCMA模型在Road Damage Detection Dataset上的可视化训练结果见图 3。图 3(a)显示,对于细小的裂缝,YOLOv8n模型出现了漏检的情况;图 3(b)中,YOLOv8n模型对模糊的油漆缺陷产生了误检;图 3(c)中,由于阴影遮挡,YOLOv8n模型将影子误识别为坑洞。与之形成鲜明对比的是,YOLOv8-MCMA模型显著降低了误检和漏检的概率,能够更准确地识别细小的缺陷。

|

| 图 3 在Road Damage Detection Dataset上的检测结果对比 Fig.3 Comparison of detection results on the Road Damage Detection Dataset |

为了进一步证明YOLOv8-MCMA模型的泛化性,本文在RDD2022_China上进行了实验(epoch设置为450轮),以评估模型在其他数据集上的路面损坏检测效果,结果如表 8所示。YOLOv8-MCMA模型的mAP@0.5和mAP@0.5:0.95均最高,与Faster-RCNN和Cascade-RCNN相比,mAP@0.5分别提高3.9%和3.5%;与YOLOv3-tiny、YOLOv5n、YOLOv6n、YOLOv7-tiny相比,mAP@0.5分别高出4.3%、1.5%、1.7%、0.6%,mAP@0.5:0.95分别高出5.0%、1.4%、2.5%、4.9%;与RT-DETR-L相比,mAP@0.5提高6.2%,精确度和召回率分别高出3.2%和9.3%;与YOLOv8n模型相比,精确度略有下降(1.0%),但mAP@0.5和mAP@0.5:0.95分别提高1.4%和0.9%。此外,RDD2022_China包含无人机和摩托车拍摄的多样化数据,且涵盖不同天气条件与光照强度,进一步验证了YOLOv8-MCMA模型能够适应不同地区路面损伤、拍摄设备及环境变化,具有较强的泛化能力和通用性。

| 算法 Algorithms |

精确度 Precision |

召回率 Recall |

平均精确度 均值@0.5 mAP@0.5 |

平均精确度 均值@0.5:0.95 mAP@0.5:0.95 |

F1分数 F1 score |

| Faster-RCNN | 85.1 | 80.7 | 85.2 | 49.3 | - |

| Cascade-RCNN | 86.1 | 81.0 | 85.6 | 50.7 | - |

| YOLOv3-tiny | 83.4 | 80.2 | 84.8 | 50.1 | 82 |

| YOLOv5n | 86.4 | 80.8 | 87.6 | 53.7 | 83 |

| YOLOv6n | 84.4 | 82.0 | 87.4 | 52.6 | 83 |

| YOLOv7-tiny | 82.9 | 85.6 | 88.5 | 50.2 | 85 |

| RT-DETR-L | 83.1 | 76.0 | 82.9 | 49.5 | 79 |

| YOLOv8n | 87.3 | 84.3 | 87.7 | 54.2 | 86 |

| YOLOv8-MCMA | 86.3 | 85.3 | 89.1 | 55.1 | 85 |

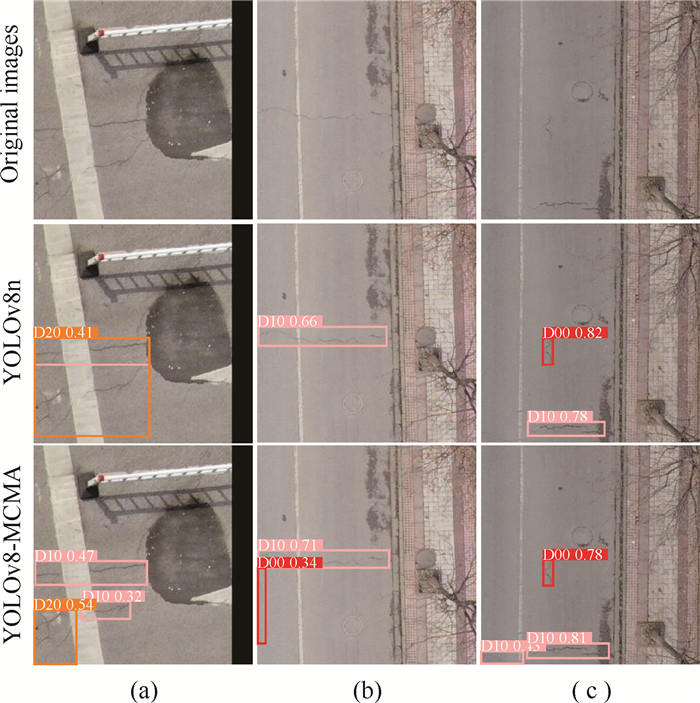

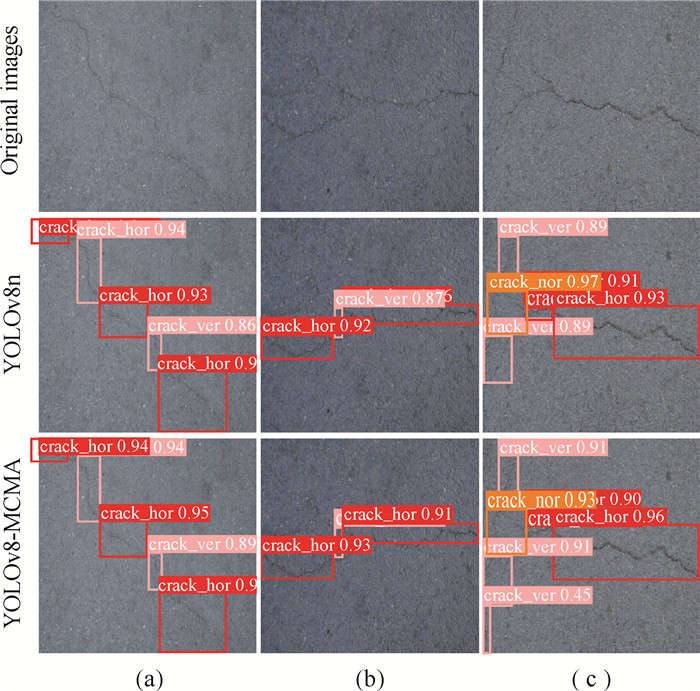

YOLOv8和YOLOv8-McMA模型在RDD2022_China和Crack-forest Dataset上的检测结果对比分别见图 4、图 5。如图 4(a)所示,YOLOv8n模型因缺陷重叠出现了漏检;如图 4(b)、图 4(c)和图 5(c)所示,该模型对细小裂缝也存在漏检现象。相比之下,YOLO-MCMA模型不仅能检测出更细小的道路缺陷,对重叠缺陷也具有更强的辨别能力,识别效果更为突出。

|

| 图 4 在RDD2022_China上的检测结果对比 Fig.4 Comparison of detection results on the RDD2022_China |

|

| 图 5 在Crack-forest Datasets上的检测结果对比 Fig.5 Comparison of detection results on the Crack-forest Dataset |

不同算法在Crack-forest Dataset上的对比实验结果见表 9,epoch设置为640轮。YOLOv8-MCMA模型与Faster-RCNN和Cascade-RCNN相比,mAP@0.5分别提高3.0%和2.2%,与RT-DETR-L、YOLOv5n、YOLOv6n和YOLOv7-tiny相比,mAP@0.5分别提升了3.3%、2.9%、2.0%和0.5%,精确度分别提高了2.1%、3.9%、1.4%和1.5%。虽然YOLOv8-MCMA模型mAP@0.5:0.95略低于YOLOv6n,且召回率比YOLOv7-tiny低1.1%,但其他指标均优于对比算法。此外,与YOLOv8n相比,YOLOv8-MCMA模型的mAP@0.5提高了2.6%,F1分数提高了2%。这些结果进一步证明了YOLOv8-MCMA模型具有较强的泛化能力。

| 算法 Algorithms |

精确度 Precision |

召回率 Recall |

平均精确度 均值@0.5 mAP@0.5 |

平均精确度 均值@0.5:0.95 mAP@0.5:0.95 |

F1分数 F1 score |

| Faster-RCNN | 87.3 | 89.1 | 92.7 | 82.1 | - |

| Cascade-RCNN | 88.2 | 90.7 | 93.5 | 81.9 | - |

| RT-DETR-L | 94.7 | 88.2 | 92.4 | 71.4 | 91 |

| YOLOv5n | 92.9 | 89.6 | 92.8 | 82.1 | 91 |

| YOLOv6n | 95.4 | 90.9 | 93.7 | 83.7 | 93 |

| YOLOv7-tiny | 95.3 | 94.0 | 95.2 | 78.4 | 95 |

| YOLOv8n | 93.9 | 91.7 | 93.1 | 83.2 | 93 |

| YOLOv8-MCMA | 96.8 | 92.9 | 95.7 | 83.3 | 95 |

4 结论

本文基于YOLOv8n模型提出了一种针对道路缺陷多尺度、特征细小等特点的YOLOv8-MCMA模型,用于自动检测道路缺陷。通过采用MobileViT网络作为特征提取主干,模型在降低参数量的同时保证了准确率的提升;使用CARAFE上采样模块最大限度地保留更丰富的特征,从而提取更多的语义信息;通过设计MIRA模块,模型能够关注重要的细小裂缝内容,使其对不同尺度的缺陷更加敏感;最后,将颈部的普通卷积操作替换为更有效的AKConv,能够动态调整卷积核的大小和采样形状,从而适应不同形状的缺陷特征。经过实验验证,本文提出的YOLOv8-MCMA模型在Road Damage Detection Dataset、RDD2022_China和Crack-forest Dataset上的检测准确性均有显著提升。然而,算法在识别道路缺陷时的运行速度以及模型的复杂度仍有待优化。今后的研究将以提高检测速度和降低模型复杂度为目标寻找突破口,设计出更均衡的解决方案。

| [1] |

ALFARRARJEH A, TRIVEDI D, KIM S H, et al. A deep learning approach for road damage detection from smartphone images [C]//2018 IEEE International Conference on Big Data (Big Data). Piscataway, NJ: IEEE, 2018: 5201-5204.

|

| [2] |

DU Y C, PAN N, XU Z H, et al. Pavement distress detection and classification based on YOLO network[J]. International Journal of Pavement Engineering, 2021, 22(13): 1659-1672. DOI:10.1080/10298436.2020.1714047 |

| [3] |

XU X Y, ZHAO M, SHI P X, et al. Crack detection and comparison study based on faster R-CNN and mask R-CNN[J]. Sensors, 2022, 22(3): 1215. DOI:10.3390/s22031215 |

| [4] |

覃晓, 黄呈铖, 施宇, 等. 基于卷积神经网络的图像分类研究进展[J]. 广西科学, 2020, 27(6): 587-599, 696. |

| [5] |

VISHWAKARMA R, VENNELAKANTI R. CNN model & tuning for global road damage detection [C]//2020 IEEE International Conference on Big Data (Big Data). Piscataway, NJ: IEEE, 2020: 5609-5615.

|

| [6] |

SINGH J, SHEKHAR S, DOSHI K, et al. Road damage detection and classification in smartphone captured images using mask R-CNN [Z/OL]. (2018-11-12)[2024-11-16]. https://arxiv.org/abs/1811.04535v1.

|

| [7] |

李柯泉, 陈燕, 刘佳晨, 等. 基于深度学习的目标检测算法综述[J]. 计算机工程, 2022, 48(7): 1-12. |

| [8] |

MAEDA H, SEKIMOTO Y, SETO T, et al. Road damage detection using deep neural networks with images captured through a smartphone [Z/OL]. (2018-02-02)[2024-11-16]. https://arxiv.org/abs/1801.09454v2.

|

| [9] |

LEI X, LIU C L, LI L, et al. Automated pavement distress detection and deterioration analysis using street view map[J]. IEEE Access, 2020, 8: 76163-76172. DOI:10.1109/ACCESS.2020.2989028 |

| [10] |

何铁军, 李华恩. 基于改进YOLOv5的路面病害检测模型[J]. 土木工程学报, 2024, 57(2): 96-106. |

| [11] |

王朕, 李豪, 严冬梅, 等. 基于改进YOLOv5的路面病害检测模型[J]. 计算机工程, 2023, 49(2): 15-23. |

| [12] |

PHAM V, NGUYEN D, DONAN C. Road damage detection and classification with YOLOv7 [C]//2022 IEEE International Conference on Big Data (Big Data). Piscataway, NJ: IEEE, 2022: 6416-6423.

|

| [13] |

许小伟, 陈燕玲, 占柳, 等. 基于改进RT-DETR的路面坑槽检测模型[J]. 武汉科技大学学报, 2024, 47(6): 457-467. DOI:10.3969/j.issn.1674-3644.2024.06.007 |

| [14] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2016: 779-788.

|

| [15] |

李斌, 文莉莉, 邬满, 等. 基于注意力机制的SK- YOLOv5海洋目标检测分类算法[J]. 广西科学, 2023, 30(1): 132-138. |

| [16] |

MEHTA S, RASTEGARI M. MobileViT: light- weight, general-purpose, and mobile-friendly vision transformer [Z/OL]. (2022-03-04)[2024-11-16]. https://arxiv.org/abs/2110.02178v2.

|

| [17] |

WANG J Q, CHEN K, XU R, et al. CARAFE: content-aware ReAssembly of FEatures [C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2019: 3007-3016.

|

| [18] |

OUYANG D L, HE S, ZHANG G Z, et al. Efficient multi-scale attention module with cross-spatial learning [C]//ICASSP 2023-2023 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Piscataway, NJ: IEEE, 2023: 1-5.

|

| [19] |

ZHANG J N, LI X T, LI J, et al. Rethinking mobile block for efficient attention-based models [C]//2023 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2023: 1389-1400.

|

| [20] |

ZHANG X, SONG Y Z, SONG T T, et al. AKConv: convolutional kernel with arbitrary sampled shapes and arbitrary number of parameters [Z/OL]. (2023-11-20)[2024-11-16]. https://arxiv.org/abs/2311.11587v1.

|

| [21] |

ARYA D, MAEDA H, GHOSH S K, et al. RDD2022: a multi-national image dataset for automatic Road Damage Detection [Z/OL]. (2022-09-18)[2024-11-16]. https://arxiv.org/abs/2209.08538v1.

|

| [22] |

DAI J F, QI H Z, XIONG Y W, et al. Deformable convolutional networks [C]//2017 IEEE International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2017: 764-773.

|